NVIDIA의 데이터 처리 장치(DPU) BlueField-2가 테스트를 통해 세계 신기록을 달성했습니다. BlueField DPU는 서버와 스토리지 간 4,100만 IOPS(초당 입출력 작업)를 초과해 기존 기록보다 4배 이상 증가된 성능을 증명했습니다. 이를 통해 신속한 스토리지 액세스가 요구되는 데이터센터에 가장 빠른 DPU 성능을 제공합니다.

NVIDIA의 최근 테스트 결과에 따르면, 2개의 BlueField-2 DPU는 4,150만 IOPS를 달성해 현존하는 모든 DPU보다 4배 이상 높은 성능을 보였습니다.

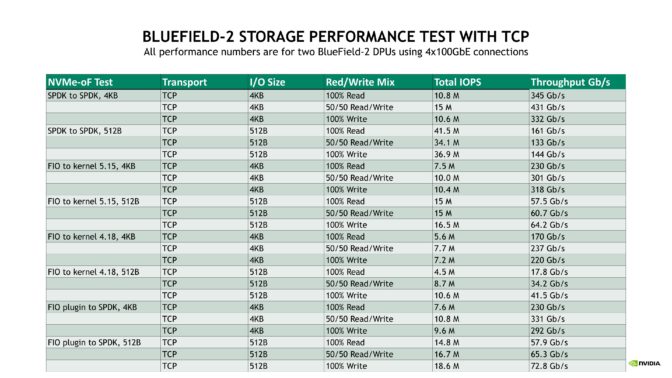

BlueField-2 DPU는 이번 테스트에서 표준 네트워킹 프로토콜과 오픈 소스 소프트웨어를 사용해 뛰어난 성능을 기록했는데요. 기본 인터넷 프로토콜 중 하나인 TCP 네트워킹을 통해 스토리지 미디어에 액세스하는 일반적인 방법인 NVMe-oF(NVMe over Fabric)에 대해 4KB의 경우 500만 이상의 IOPS, 512B의 경우 700만부터 2,000만에 달하는 IOPS를 기록했습니다.

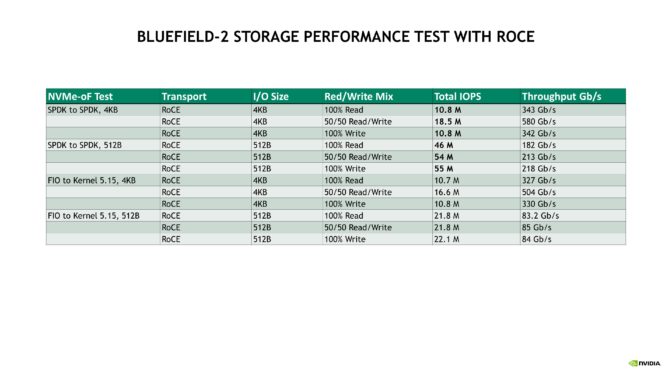

BlueField는 AI, 빅데이터, 고성능 컴퓨팅(HPC) 애플리케이션을 가속화하기 위해 오늘날 널리 사용되는 RoCE 네트워크 전송 옵션을 사용하며, 이를 통해 훨씬 더 높은 스토리지 성능을 제공합니다.

테스트에서 BlueField는 다양한 유형의 스토리지 소프트웨어 라이브러리와 워크로드를 사용하여 실제 스토리지 구성을 시뮬레이션하고 이니시에이터와 타겟으로서의 성능을 모두 극대화했는데요. 또한 BlueField는 수많은 HPC, AI 애플리케이션에서 선호되는 네트워킹 아키텍처인 InfiniBand를 통해 빠른 스토리지 연결을 지원합니다.

테스트 방법

BlueField가 달성한 4,150만 IOPS는 독점 스토리지 오퍼링(proprietary storage offerings)을 사용해 수립된 이전 세계 기록인 1,000만 IOPS의 4배 이상입니다. 이러한 성능은 각각 애플리케이션 서버(스토리지 이니시에이터)와 스토리지 시스템(스토리지 타겟)을 담당하는 두 대의 고속 휴렛 팩커드 엔터프라이즈 프로라이언트(Hewlett Packard Enterprise Proliant) DL380 Gen 10 플러스 서버를 연결하여 달성됐죠.

각 서버는 2.3GHz로 클럭된 인텔(Intel)의 아이스레이크(Ice Lake) 제온 플래티넘(Xeon Platinum) 8380 CPU 2개를 탑재했으며, 서버당 160개의 하이퍼스레드 코어, 512GB의 DRAM, 120MB의 L3 캐시(소켓당 60MB), PCIe 4세대 버스를 제공합니다.

네트워킹과 NVMe-oF를 가속화하기 위해 각 서버는 2개의 100Gb 이더넷(Ethernet) 네트워크 포트를 갖춘 NVIDIA BlueField-2 P-시리즈 DPU 카드 2개로 구성되는데요. 이니시에이터와 타겟 간에 4개의 네트워크 포트와 400Gb/s 유선 대역폭을 제공하고, NVIDIA LinkX 100GbE DAC (Direct-Attach Copper)를 사용해 백투백(Back-to-Back)으로 연결됩니다. 두 서버 모두 레드햇(Red Hat) 엔터프라이즈 리눅스(RHEL) 버전 8.3을 채택했죠.

스토리지 시스템 소프트웨어의 경우 SPDK와 표준 업스트림 리눅스 커널 타겟 모두 기본 커널 4.18과 최신 커널 중 하나인 5.15를 사용해 테스트됐습니다. 서로 다른 3개의 스토리지 이니시에이터인 SPDK, 표준 커널 스토리지 이니시에이터, SPDK용 FIO 플러그인이 벤치마킹 됐죠. 워크로드 생성과 측정은 FIO 및 SPDK로 실행됐고, I/O 크기는 각각 일반적인 중형, 소형 스토리지 I/O 크기인 4KB와 512B를 사용해 테스트됐습니다.

NVMe-oF 스토리지 프로토콜은 네트워크 전송 계층에서 TCP와 RoCE를 모두 사용하여 테스트됐으며, 각 구성은 100% 읽기, 100% 쓰기, 50/50 읽기/쓰기 워크로드로 양방향 네트워크 활용도를 극대화하여 테스트됐습니다.

BlueField DPU의 성능에 대한 테스트 결과는 다음과 같습니다.

- 더 작은 512B I/O 크기로 테스트한 결과 IOPS는 높지만 회선 속도보다 낮은 처리량이 나타났으며, 4KB I/O 크기는 처리량이 높지만 IOPS가 비교적 낮았습니다.

- 100% 읽기, 100% 쓰기 워크로드는 유사한 IOPS와 처리량을 제공하는 반면, 50/50 혼합 읽기/쓰기 워크로드는 네트워크 연결의 양방향을 동시에 사용해 더 높은 성능을 생성했습니다.

- SPDK를 사용하면 커널 공간 소프트웨어보다 성능이 향상되지만, SPDK가 지속적인 폴링(polling)으로 사용자 공간에서 실행되기 때문에 예상되는 동작인 서버 CPU 사용률이 높아집니다.

- 최신 리눅스 15 커널은 리눅스 커뮤니티에서 정기적으로 추가되는 저장소 개선 사항 덕분에 4.18 커널보다 뛰어난 성능을 달성했습니다.

기록적인 DPU 스토리지 성능과 보안

오늘날의 스토리지 환경에서 대다수의 클라우드, 엔터프라이즈 구축에는 이더넷 또는 인피니밴드를 통해 액세스되는 빠르고 분산된 네트워크 플래시 스토리지가 필요한데요. 고속 서버, GPU, 네트워크, 저장 매체는 모두 서버 CPU에 영향을 미치므로, 가장 좋은 방법은 스토리지 기능을 갖춘 DPU를 활용하는 것이죠.

BlueField-2 DPU의 우수한 스토리지 성능은 데이터센터 전체에 걸쳐 애플리케이션 서버와 스토리지 어플라이언스에 보다 높은 성능과 효율성을 지원합니다

BlueField는 빠른 스토리지 액세스 외에도 이더넷 스토리지 트래픽과 스토리지 미디어 자체의 하드웨어 가속 암호화, 암호 해독을 지원해 데이터 도난 또는 유출에서 보호합니다.

BlueField는 최대 100Gb/s(유선 데이터)의 IPsec, 최대 200Gb/s(유휴 데이터)의 256비트 AES-XTS를 오프로드하는데요. 이는 공격자가 스토리지 네트워크에 잠입하거나 물리적 스토리지 드라이브가 도난, 판매, 부적절하게 폐기될 경우 데이터 도난의 위험을 줄여줍니다.

고객과 주요 보안 소프트웨어 공급업체는 BlueField의 NVIDIA DOCA 프레임워크 최신 업데이트를 통해 분산 방화벽 또는 세분화된 보안 그룹과 같은 사이버 보안 애플리케이션을 DPU에서 실행합니다. 이를 통해 컴퓨팅 서버의 애플리케이션, 네트워크 보안을 더욱 개선하며, 서버에 연결된 저장소에 대한 부적절한 액세스 또는 데이터를 수정 위험을 줄이죠.

NVIDIA BlueField-2 DPU 테스트의 자세한 결과는 다음 사진과 같습니다.

NVIDIA 네트워킹 가속 더 알아보기

NVIDIA DPUs, DOCA, RoCE에 대해 더 알아보고, 다음의 링크를 통해 DPU, DOCA가 네트워킹과 제로 트러스트 보안을 가속화하는 방법에 대해서 확인하세요.

- NVIDIA BlueField DPU 정보

- NVIDIA DOCA DPU 개발 플랫폼

- NVIDIA 블로그: NVIDIA improves the scalability of Zero-Touch RoCE

- NVIDIA 블로그: NVIDIA Enables Future of Zero-Trust Enterprise Security