트랜스포머 활용하기

얼마 지나지 않아 트랜스포머 모델들은 과학과 헬스케어에 도입되기 시작했습니다.

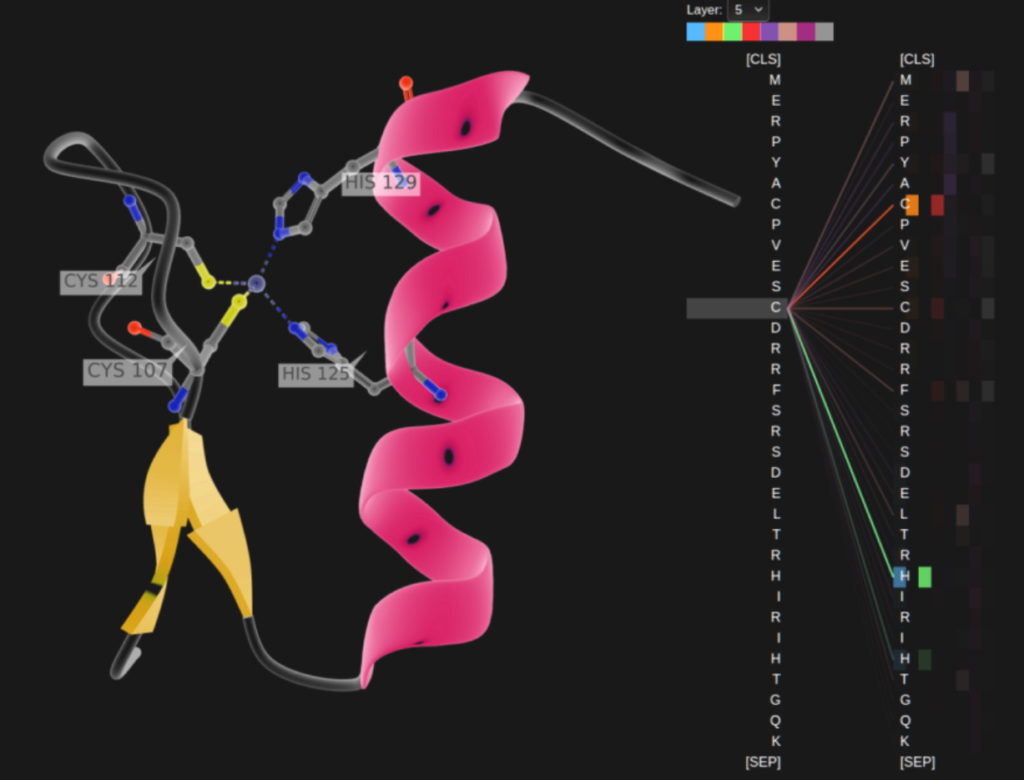

런던의 딥마인드(DeepMind)는 최근 <네이처> 지에 소개된 트랜스포머인 알파폴드2(AlphaFold2)를 활용해 생명의 빌딩 블록에 해당하는 단백질 연구를 개선하고 있습니다. 이 모델은 아미노산 사슬을 문자줄처럼 처리하는 혁신을 통해 단백질이 접히는 방식을 설명하고 신약 발견을 가속합니다.

NVIDIA와 아스트라제네카(AstraZeneca)는 신약 개발용 트랜스포머인 메가몰바트(MegaMolBART)를 구축했습니다. 아스트라제네카가 보유한 몰바트 트랜스포머의 다른 버전인 메가몰바트는 라벨링되지 않은 대규모 화합물 데이터 세트에서 대형 트랜스포머 모델 구축용 프레임워크인 NVIDIA Megatron을 사용해 훈련됐습니다.

분자와 의료 기록 읽기

작년에 메가몰바트가 발표되던 당시 아스트라제네카의 올라 잉크비스트(Ola Engkvist) 분자AI와 발견과학, 연구개발 부문 책임자는 “AI 언어 모델이 문장 속 단어들의 관계를 학습하듯, 우리의 목표는 분자 구조 데이터로 훈련된 신경망이 실제 분자 속 원자들의 관계를 학습할 수 있게 되는 것”이라고 말했습니다.

플로리다대학교 학술의료센터는 NVIDIA 연구진과 협업해 GatorTron을 구축하기도 했습니다. 이 트랜스포머 모델은 방대한 양의 임상 데이터에서 인사이트를 추출해 의료 연구를 가속합니다.

트랜스포머의 성장

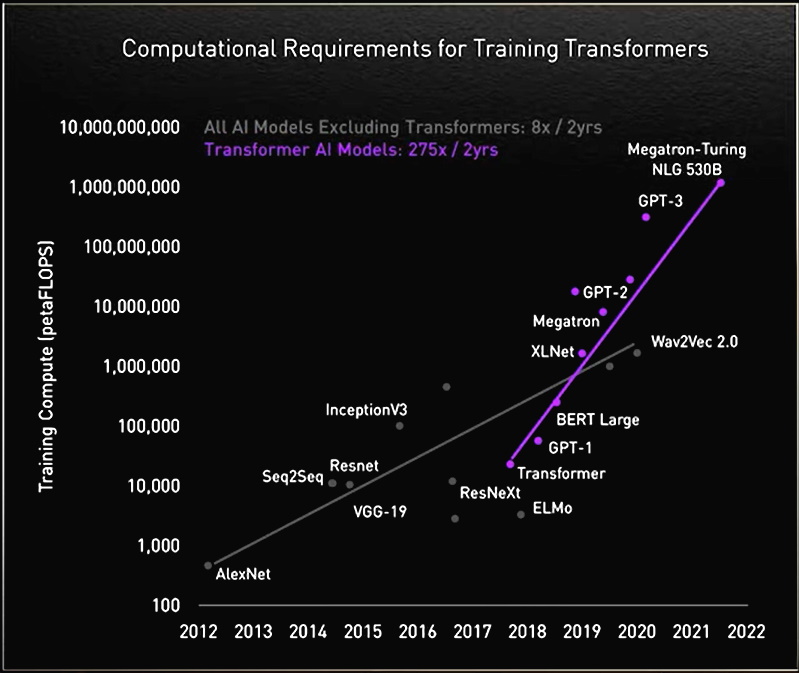

이 과정에서 연구자들은 트랜스포머의 규모가 클수록 성능도 좋아진다는 사실을 발견했습니다.

일례로 AI와 생물학 접목 연구의 선구자인 뮌헨공과대학교 소속 로스트랩(Rostlab) 연구진은 자연어 처리를 활용해 단백질을 이해합니다. 9,000만 개의 매개변수를 가진 RNN에서 5억6,700만 개의 매개변수를 가진 트랜스포머 모델들로 18개월에 걸쳐 이동했죠.

오픈AI(OpenAI) 랩은 GPT(Generative Pretrained Transformer)를 통해 대규모 모델의 우수함을 보여줬습니다. 최신 버전인 GPT-3의 경우, GPT-2에서는 15억 개였던 파라미터 수가 1,750억 개로 늘었습니다.

GPT-3는 특별히 따로 훈련하지 않은 작업에서도 사용자의 쿼리에 응답할 수 있습니다. 시스코(Cisco)와 IBM, 세일즈포스(Salesforce) 등의 기업들에서 이미 사용되고 있죠.

메가 트랜스포머 이야기

NVIDIA와 마이크로소프는 지난 11월에 5,300억 개의 파라미터를 가진 MT-NLG(Megatron-Turing Natural Language Generation) 모델을 발표하면서 대형 트랜스포머의 정점을 찍었습니다. 이 모델은 새로운 프레임워크인 NVIDIA NeMo Megatron과 함께 데뷔했는데요. 어떤 기업이든 십억 또는 조 단위의 파라미터를 보유한 자체 트랜스포머를 개발할 수 있도록 지원해 커스텀 챗봇과 개인 어시스턴트 등 언어를 이해하는 AI 애플리케이션을 개선하는 것이 목표입니다.

MT-NLG는 2021년 11월 NVIDIA GTC 키노트에 등장한 TJ, 즉 Toy Jensen 아바타의 브레인으로 공식 데뷔전을 치른 바 있는데요.

이 모델의 훈련 담당팀을 이끈 모스토파 팻워리(Mostofa Patwary)는 “TJ가 젠슨 황 CEO의 질문에 답하고 우리가 진행한 작업의 위력을 입증했을 때 무척 기뻤습니다”고 말합니다.

이 같은 모델의 구축에는 대범함이 필요합니다. MT-NLG는 수천억 개의 데이터 요소를 사용해 훈련됐으며, 이 과정은 수천 개의 GPU를 동원해 수주일 동안 계속됐습니다.

“대규모 트랜스포머 모델의 훈련은 많은 비용과 시간을 요하기 때문에 최초 한두 번의 시도에 성공하지 못하면 프로젝트 자체가 취소될 가능성이 있습니다”

조 단위의 파라미터를 가진 트랜스포머

오늘날 많은 AI 엔지니어들이 조 단위의 파라미터를 보유한 트랜스포머와 이들을 위한 애플리케이션을 개발하고 있습니다.

팻워리는 “우리는 이 같은 대형 모델의 더 우수한 쓰임새를 끝없이 탐색하고 있습니다. 모델의 성능과 규모 개선에 도움이 되도록 실패 사례의 면면도 함께 연구합니다”라고 설명합니다.

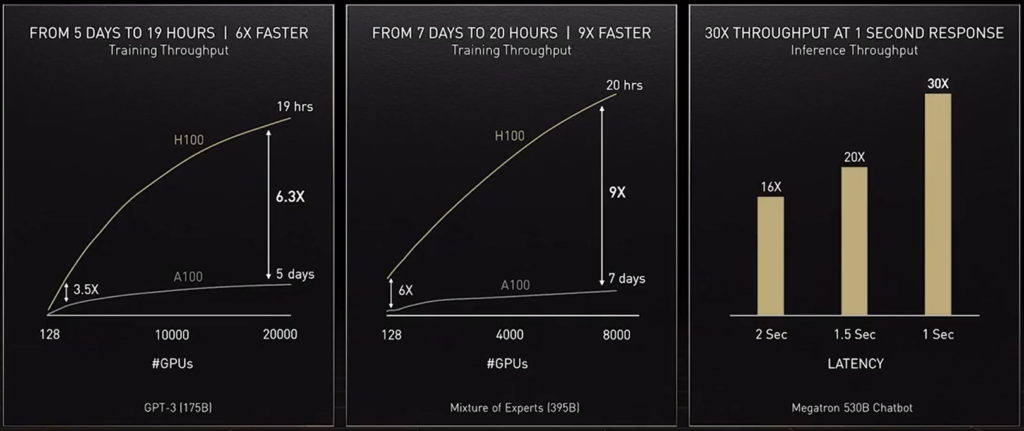

이러한 모델들에 필요한 컴퓨팅 능력을 제공하기 위해 NVIDIA가 내놓은 최신 액셀러레이터인 NVIDIA H100 Tensor Core GPU는 트랜스포머 엔진을 탑재하고 새로운 FP8 포맷을 지원합니다. 이를 통해 훈련 가속화와 정확도 유지를 동시에 달성합니다.

젠슨 황 CEO는 이를 비롯한 여러 혁신들 덕분에 “트랜스포머 모델의 훈련이 수주일에서 수일로 단축될 수 있다”고 전망하기도 했습니다.

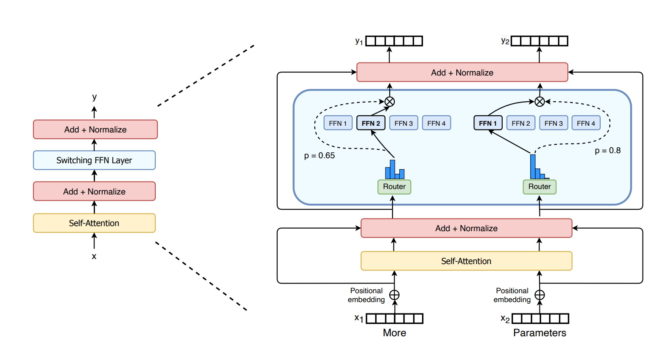

트랜스포머 강화하는 MoE

지난해 구글 연구진은 최초의 조 단위 파라미터 모델인 스위치 트랜스포머(Switch Transformer)를 선보였습니다. AI 희소성(sparsity)과 복잡한 MoE(mixture-of experts) 아키텍처 등의 혁신을 활용해 언어 처리 성능을 개선하고 사전 훈련 속도를 최대 7배까지 높였습니다.

마이크로소프트 애저(Azure)의 경우 NVIDIA와 협업을 통해 트랜스레이터(Translator) 서비스용 MoE 트랜스포머를 구현했습니다.

트랜스포머의 과제 해결하기

일각에서는 파라미터의 개수가 더 적고 단순하면서도 대규모 모델과 비슷한 성능을 제공하는 트랜스포머의 개발을 진행 중입니다.

고메즈 코히어 CEO는 딥마인드의 레트로(Retro) 모델을 예로 들며 “검색 기반(retrieval-based) 모델의 가능성을 보고 또 하나의 돌파구를 찾은 듯해 무척 기뻤습니다”라고 말합니다.

검색 기반 모델은 데이터베이스에 쿼리를 제출해 학습합니다. “지식들이 모여 있는 거점에 무엇을 넣을지 선택할 수 있어서 좋습니다”

스텔스(stealth) AI 스타트업의 공동 창립자가 된 바스와니는 이 모델들이 “실세계의 맥락에서 아주 적은 데이터로도 인간처럼 학습할 수 있게 만드는 것”이 궁극적인 과제라고 말합니다.

그는 더 많은 연산을 선행한 덕분에 더 적은 데이터가 필요하고, 사용자가 피드백을 제공하는 방법 또한 개선된 미래 모델들을 상상합니다.

“우리의 목표는 일상적인 삶에 도움이 되는 모델들을 구축하는 것입니다”

안전하고 책임성 있는 모델

모델이 그릇되거나 유해한 언어를 내놓는 경우 편견이나 독성을 제거하는 방법도 연구되고 있습니다. 가령 스탠퍼드대학교는 이 문제들의 탐구를 위해 ‘파운데이션모델연구센터(Center for Research on Foundation Models)’를 설립하기도 했죠.

이 분야를 연구 중인 NVIDIA 연구원 시리마이 프라뷰모예(Shrimai Prabhumoye)는 “이들은 모델의 안전한 배포를 위해 반드시 해결해야 할 중대 사안들”이라고 말합니다.

“오늘날 대부분의 모델들은 확실한 단어나 구문을 찾아내는 편이지만 실세계에서는 민감하게 받아들여지는 경우가 발생하므로 전체적인 맥락을 고려할 수 있어야 합니다”

고메즈 CEO는 “코히어 또한 이 문제에 대해 깊이 고민하고 있습니다”라고 전합니다. “사람을 해하는 모델이라면 그 누구도 사용하지 않을 겁니다. 따라서 가장 안전하고 책임성 있는 모델을 만드는 것이 필수적입니다”

지평을 넓히다

바스와니는 스스로 학습하고 어텐션 기법을 활용하는 트랜스포머가 AI라는 성배에 가까워지는 미래를 상상합니다.

“‘범용 인공지능’이라는 말이 만들어지던 당시 함께 거론됐던 목표들의 일부나마 달성할 기회가 주어진 셈입니다. 아주 고무적인 북극성이 우리를 그 미래로 인도하고 있습니다”

“우리는 신경망과 같은 간단한 기법이 새로운 가능성의 폭발로 이어지는 시대를 살고 있습니다”