양자 컴퓨팅(Quantum computing)은 신약 개발을 위해 분자의 구성을 시뮬레이션 하는 등 과학 분야의 혁신적 발전에 기여할 것으로 기대를 모으고 있습니다.

기존의 컴퓨터 대비 정보의 처리량을 기하급수적으로 늘리기 위해 양자 컴퓨터는 아원자 입자의 물리학을 활용해 병렬 계산을 수행합니다. 현재 양자 컴퓨터와 알고리즘을 연구 중인 전세계의 학계와 산업계, 국립 연구소들은 양자 회로 시뮬레이션으로 연구의 속도를 높이고 있죠.

NVIDIA는 지난 GTC 2021에서 GPU상의 양자 회로 시뮬레이션을 가속화하는 cuQuantum 소프트웨어 개발 키트(SDK)를 공개했습니다. 초기 연구에 따르면 cuQuantum은 양자 회로의 시뮬레이션을 막대한 수준으로 가속하여 미래의 혁신으로 가는 길을 다지고 있습니다.

양자 컴퓨팅 우위(전통적 컴퓨터가 합리적인 시간 내에 처리할 수 없는 문제를 양자 컴퓨터가 해결하는 상황)의 도래는 이미 예견된 일이지만, 그를 둘러싼 논쟁은 현재 진행형입니다. 노이즈 상태를 의미하는 결잃음(decoherence)이나 양자 상태의 불안정을 해결하는 문제가 아직 남아 있는데요, 이들은 양자 회로의 기능을 떨어트리는 제한 요인으로 작용하기도 합니다.

또한 양자 컴퓨팅이 연산의 단위로 사용하는 큐비트(qubits)와 관련한 문제도 있습니다. 큐비트는 0이나 1, 또는 0이면서 1인 상태로 존재할 수 있는데요. 결잃음이라는 오류를 정정하기 위해서는 훨씬 많은 수의 큐비트가 필요합니다.

NVIDIA cuQuantum SDK는 양자 회로 시뮬레이터를 가속하여 더 나은 성능의 양자 컴퓨터 설계와 결과의 검증, 전통적 컴퓨팅과 융합된 시스템의 모델링, 보다 최적의 양자 알고리즘 탐색 작업에 일조합니다.

이와 더불어 cuQuantum SDK가 제공하는 툴들은 상태 벡터 기법(state vector method)과 텐서 네트워크 기법(tensor network method) 등 다양한 접근법을 지원해 개발자가 자신에게 적합한 기법을 선택적으로 적용할 수 있게 해줍니다.

상태 벡터 기법

율리히 슈퍼컴퓨터센터(Jülich Supercomputing Centre)의 연구자들은 상태 벡터 기법과 GPU를 활용해 양자 컴퓨터의 물리적 실현을 시뮬레이션하고 있습니다. 이들의 벤치마크 테스트 결과는 GTC 2021에서 조명되기도 했는데요. CPU 기반 시스템에서 구동했을 때보다 GPU 클러스터 상에서 25배 빠른 성능을 기록했죠.

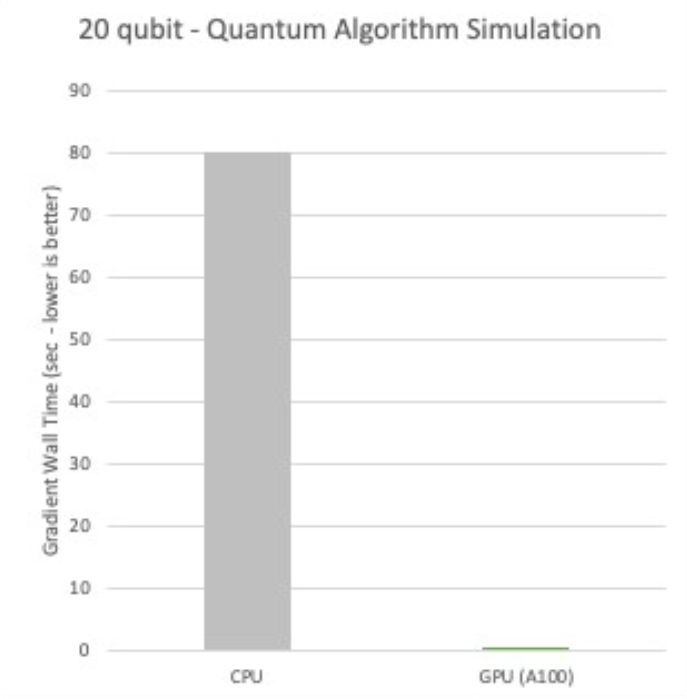

큐씨웨어(QCWare)는 양자 컴퓨팅 부문의 시뮬레이션과 응용에 대한 연구 보고서를 발표해 온 민간 기업입니다. NVIDIA와의 협업을 통해 양자 근사 최적화 알고리즘(quantum approximate optimization algorithm)이 20큐비트에서 얼마나 월등한 성능을 달성하는지 설득력 있게 보여주기도 했죠.

NVIDIA A100 80GB Tensor Core GPU 8개가 탑재된 NVIDIA DGX A100은 단일 시스템만으로 최대 36큐비트까지 시뮬레이션이 가능해 선도적인 상태 벡터 시뮬레이션들에 듀얼 소켓 CPU를 사용할 때보다 엄청난 수준의 가속을 달성합니다.

율리히 슈퍼컴퓨터센터와 큐씨웨어 외에도 IBM, 옥스퍼드 나노포어(Oxford Nanopore), 아마존웹서비스(Amazon Web Services), NVIDIA AI Technology Center 등이 NVIDIA GPU를 기반으로 상태 벡터 시뮬레이터를 구동합니다.

텐서 네트워크 기법

텐서 네트워크 시뮬레이션은 상태 벡터 접근법에 비해 더 적은 메모리와 더 많은 연산을 사용하는 새로운 기법입니다.

NVIDIA와 미국 캘리포니아공과대학(Caltech)은 대표적인 양자 회로 시뮬레이터의 가속화에 NVIDIA A100 Tensor Core GPU와 cuQuantum을 활용했습니다. 이 설정을 적용해 NVIDIA의 슈퍼컴퓨터인 Selene에서 구글 시카모어(Google Sycamore) 회로의 풀서킷(full-circuit) 시뮬레이션을 진행하고 샘플을 생성하기까지 9.3분이 걸렸습니다. 얼마 전까지만 해도 동일한 작업에 CPU 코어 수백만 개를 동원하고도 수일이 걸릴 것으로 예상되었던 것을 감안하면 주목할 만한 쾌거입니다.

캘리포니아공과대학과 더불어 알리바바(Alibaba), 아마존 웹 서비스, 미국 아르곤국립연구소(Argonne National Lab), 오크리지국립연구소(Oak Ridge National Lab) 등이 텐서 네트워크 시뮬레이터를 사용하고 있습니다.

밀도 행렬 시뮬레이션

미국 퍼시픽노스웨스트국립연구소(Pacific Northwest National Laboratory)와 리하이대학교(Lehigh University), 워싱턴주립대학교(Washington State University)의 연구자들은 새로운 형태의 다중 GPU 프로그래밍 기법인 MG-BSP를 개발했습니다. 그리고 이를 활용해 밀도 행렬 양자 시뮬레이터를 구축했죠.

연구팀은 단일 NVIDIA DGX-2에서 94분 만에 백만 개의 양자 게이트(general gate)를 시뮬레이션 하는 데 성공했습니다. 이는 기존보다 훨씬 깊이 있는 회로에 해당한다고 합니다.

연구 보고서에 발표된 결과에 따르면, 이 밀도 행렬 시뮬레이터는 GPU와 기타 플랫폼에서 구동되는 상태 벡터 양자 시뮬레이터보다 10배 이상 빠른 속도를 자랑하죠.

NVIDIA의 조기 관심 리스트에 등록하고 cuQuantum 관련 최신 소식을 확인하세요.

메인 이미지는 IBM 양자 컴퓨팅 시스템의 내부 모습입니다(이미지 제공: IBM).