NVIDIA Ampere 아키텍처 기반 저전력 시스템 온 칩(system-on-chip) NVIDIA Orin이 MLPerf 벤치마크에 최초로 도입됨과 동시에 AI 추론 부문에서 신기록을 달성했습니다. 이로써 NVIDIA Orin은 엣지에서의 액셀러레이터당 성능 기준을 더욱 높이게 됐습니다.

전반적으로, NVIDIA와 파트너사는 프로덕션 AI와 관련된 5번째 벤치마크에서 모든 머신 러닝 워크로드와 시나리오를 실행하는 최고의 성능과 광범위한 생태계를 지속적으로 보여왔습니다.

NVIDIA Orin의 프리 프로덕션(pre-production) 버전은 엣지 AI 성능 테스트 6개 가운데 5개에서 선두를 차지했습니다. 이전 세대의 Jetson AGX Xavier보다 최대 5배 더 빠르게 작동했으며 평균 2배의 에너지 효율을 실현했습니다.

NVIDIA Orin은 현재 로보틱스와 자율 시스템을 위해 NVIDIA Jetson AGX Orin 개발자 키트로 제공됩니다. 아마존 웹 서비스(Amazon Web Services), 존 디어(John Deere), 코마츠(Komatsu), 메드트로닉(Medtronic), 마이크로소프트 애저(Microsoft Azure)를 비롯한 6,000여 고객이 AI 추론이나 기타 작업에 NVIDIA Jetson 플랫폼을 사용하죠.

또한 Jetson 플랫폼은 자율주행 차량을 위한 NVIDIA Hyperion 플랫폼의 핵심 요소입니다. 중국 최대의 전기차 제조업체 비야디(BYD)는 차세대 자율주행 전기 자동차에 Orin 기반 DRIVE Hyperion 아키텍처를 사용할 것이라고 가장 최근 발표한 자동차 제조업체입니다.

Orin은 의료기기를 위한 NVIDIA Clara Holoscan의 핵심 구성 요소이기도 합니다. NVIDIA Clara Holoscan 플랫폼은 시스템 제조업체와 연구원들이 차세대 AI 기기를 개발하는 데 사용됩니다.

작은 모듈, 큰 스택

Jetson AGX Orin을 포함한 NVIDIA GPU가 탑재된 서버와 장치는 MLPerf 벤치마크 6개를 모두 실행하는 유일한 엣지 액셀러레이터였습니다.

Orin은 JetPack SDK를 통해 데이터센터와 클라우드에서 이미 입증된 소프트웨어 스택인 NVIDIA AI 플랫폼 전체를 실행합니다. NVIDIA Jetson 플랫폼을 사용하는 백만 명의 개발자가 NVIDIA AI 플랫폼을 지원하고 있습니다.

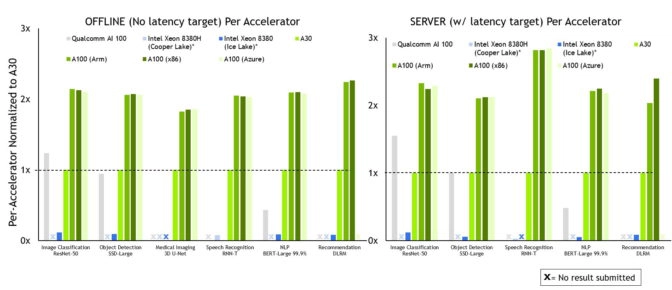

NVIDIA와 파트너사는 최신 MLPerf 추론 벤치마크의 모든 테스트와 시나리오에서 지속적으로 뛰어난 성능을 보여줍니다.

MLPerf 벤치마크는 아마존(Amazon), Arm, 바이두(Baidu), 델 테크놀로지스(Dell Technologies), 페이스북(Facebook), 구글(Google), 하버드(Harvard), 인텔(Intel), 레노버(Lenovo), 마이크로소프트(Microsoft), 스탠퍼드(Stanford), 토론토 대학(University of Toronto)을 비롯한 기업과 조직들로부터 지원을 받고 있습니다.

가장 폭넓은 파트너사, 가장 많은 결과 제출

NVIDIA AI 플랫폼은 역대 가장 광범위한 파트너 생태계로부터 가장 많은 MLPerf 결과를 제출하도록 이끌었습니다.

애저는 지난 12월 MLPerf 트레이닝 테스트에서 첫 선을 보인 후, 이번 AI 추론 라운드에서 강력한 결과를 이어갔는데요. 애저는 두 테스트에서 모두 NVIDIA A100 Tensor Core GPU를 사용했죠. 애저의 ND96amsr_A100_v4 인스턴스는 거의 모든 추론 테스트에서 최고 성능의 8 GPU 와 맞먹는 결과를 보였으며, 퍼블릭 클라우드에서 쉽게 사용할 수 성능을 보여줬습니다.

시스템 제조업체 에이수스(ASUS)와 H3C는 이번 테스트에서 NVIDIA AI 플랫폼을 사용한 결과로 MLPerf에 데뷔했습니다. 이들은 24개 이상의 NVIDIA-Certified Systems에 대한 결과를 제출한 시스템 제조업체 델 테크놀로지스, 후지쯔(Fujitsu), 기가바이트(GIGABYTE), 인스퍼(Inspur), 네트릭스(Nettrix), 슈퍼마이크로(Supermicro)에 합류했습니다.

MLPerf가 중요한 이유

NVIDIA 파트너사는 MLPerf가 AI 플랫폼과 공급업체를 평가하는 고객에게 유용한 툴이라는 것을 알기 때문에 MLPerf에 참여합니다.

MLPerf의 다양한 테스트는 오늘날 가장 인기 있는 AI 워크로드와 시나리오를 다룹니다. 이를 통해 사용자는 벤치마크가 작업 전반에 걸쳐 기대 성능을 반영할 수 있다는 확신을 가지죠.

추론을 지원하는 소프트웨어

테스트에 사용된 모든 소프트웨어는 MLPerf 저장소에서 이용할 수 있습니다. 추론 결과를 가능케 한 두 가지 핵심 요소는 AI 모델 최적화를 위한 NVIDIA TensorRT와 효율적인 배포를 위한 NVIDIA Triton Inference Server로, GPU 최적화 소프트웨어 카탈로그 NGC에서 무료 이용 가능합니다.

아마존과 마이크로소프트와 같은 클라우드 서비스 제공업체를 포함해 전 세계의 수많은 단체들이 Triton을 채택하고 있습니다.

NVIDIA는 지속적으로 모든 최적화 기능을 NGC에서 이용 가능한 컨테이너에 추가합니다. 이를 통해 모든 사용자가 최고의 성능으로 AI를 프로덕션에 도입할 수 있습니다.