생성형 AI 애플리케이션의 정확성이 떨어지면 그 가치는 낮아집니다. 그리고 그 정확성은 데이터를 기반으로 합니다.

NVIDIA는 4개의 새로운 NVIDIA NeMo Retriever NIM 추론 마이크로서비스를 발표했습니다. 이를 통해 개발자는 최상의 맞춤형 데이터를 효율적으로 가져와 AI 애플리케이션에 대한 지식이 풍부한 응답을 생성할 수 있습니다.

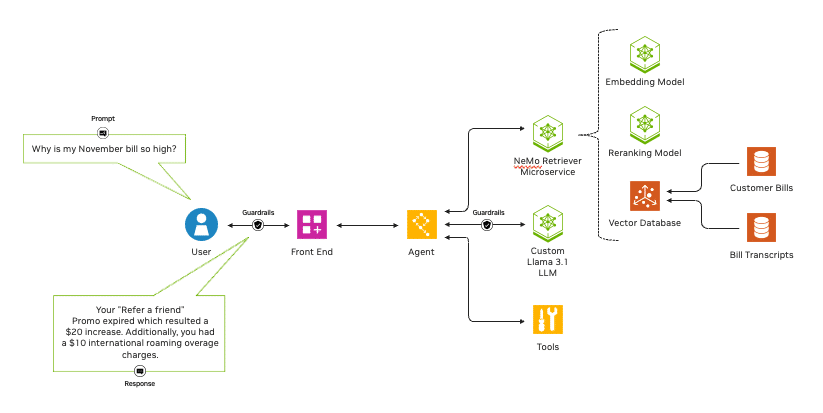

최근 발표된 라마 3.1(Llama 3.1) 모델을 위한 NVIDIA NIM 추론 마이크로서비스와 결합해, NeMo Retriever NIM 마이크로서비스는 기업이 에이전틱 AI 워크플로우(agentic AI workflows)로 확장할 수 있도록 지원합니다. AI 애플리케이션은 최소한의 개입이나 감독으로도 정확하게 작동할 수 있고, 가장 높은 정확도의 검색 증강 생성(retrieval-augmented generation, RAG)을 제공합니다.

NeMo Retriever를 통해 조직은 맞춤형 모델을 다양한 비즈니스 데이터에 원활하게 연결하고 RAG를 사용해 AI 애플리케이션에 매우 정확한 응답을 제공할 수 있는데요. 기본적으로 프로덕션 지원 마이크로서비스는 매우 정밀한 정보 검색이 가능해 정확도가 높은 AI 애플리케이션을 구축할 수 있습니다.

예를 들어, NeMo Retriever는 AI 에이전트와 고객 서비스 챗봇을 만들거나 보안 취약점을 분석하고 복잡한 공급망 정보에서 인사이트를 추출하는 개발자를 위해 모델 정확도와 처리량을 향상시킬 수 있습니다.

NIM 추론 마이크로서비스는 사용하기 쉬운 고성능 엔터프라이즈급 추론을 가능하게 합니다. 그리고 NeMo Retriever NIM 마이크로서비스를 통해 개발자는 데이터를 기반으로 이 모든 혜택을 활용할 수 있죠.

이제 새로운 NeMo Retriever 임베딩(embedding)과 리랭킹(reranking) NIM 마이크로서비스를 정식으로 사용할 수 있습니다.

- NV-EmbedQA-E5-v5: 텍스트 질의응답 검색에 최적화된 인기 커뮤니티 기반 임베딩 모델

- NV-EmbedQA-Mistral7B-v2: 정확한 질문 답변을 위해 텍스트 임베딩에 맞게 미세 조정된 인기 있는 다국어 커뮤니티 기본 모델

- Snowflake-Arctic-Embed-L: 최적화된 커뮤니티 모델

- NV-RerankQA-Mistral4B-v3: 정확한 질문 답변을 위한 텍스트 리랭킹을 위해 정밀하게 조정된 인기 커뮤니티 기본 모델

이 모델들은 NVIDIA API 카탈로그를 통해 쉽게 접근할 수 있는 NIM 마이크로서비스 컬렉션에 합류합니다.

임베딩과 리랭킹 모델

NeMo Retriever NIM 마이크로서비스는 임베딩과 리랭킹의 두 가지 모델 유형으로 구성되며, 투명성과 신뢰성을 보장하는 개방형과 상용 제품으로 제공됩니다.

임베딩 모델은 텍스트, 이미지, 차트, 동영상 등 다양한 데이터를 숫자 벡터로 전환해 벡터 데이터베이스에 저장하는 동시에 의미와 문맥까지 포착합니다. 임베딩 모델은 기존의 거대 언어 모델(large language model, LLM)에 비해 빠르고 계산 비용이 저렴합니다.

리랭킹 모델은 데이터와 쿼리를 수집한 다음 쿼리와의 관련성에 따라 데이터의 점수를 매깁니다. 이러한 모델은 임베딩 모델에 비해 계산이 복잡하고 속도가 느리지만 정확도가 크게 향상됩니다.

NeMo Retriever는 두 가지 장점을 모두 제공합니다. 임베딩 NIM으로 검색할 데이터를 광범위하게 캐스팅한 다음, 리랭킹 NIM을 사용해 관련성을 기반으로 결과를 선별하죠. 이로써 NeMo Retriever를 활용하는 개발자는 기업에 가장 유용하고 정확한 결과를 보장하는 파이프라인을 구축할 수 있습니다.

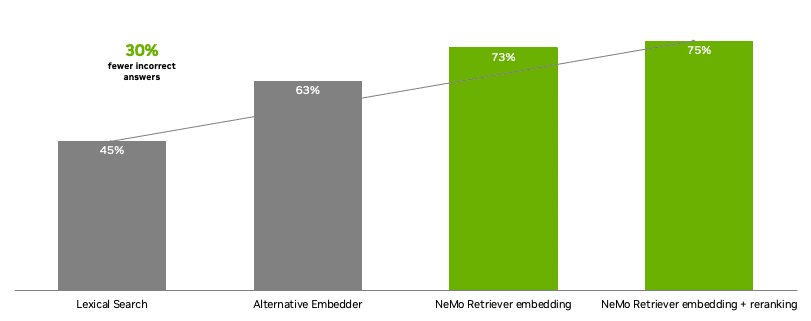

NeMo Retriever를 통해 개발자는 최상의 정확도를 제공하는 텍스트 응답 검색 파이프라인을 구축할 수 있는 최첨단 개방형 상용 모델을 이용할 수 있습니다. 대체 모델과 비교했을 때, NeMo Retriever NIM 마이크로서비스는 기업 질의응답에 대한 부정확한 답변을 30% 더 적게 제공했습니다.

주요 사용 사례

RAG, AI 에이전트 솔루션부터 데이터 기반 분석 등에 이르기까지 NeMo Retriever는 다양한 AI 애플리케이션을 지원합니다.

마이크로서비스는 정확한 상황 인식 응답을 제공하는 지능형 챗봇을 구축하는 데 사용할 수 있죠. 또한, 방대한 양의 데이터를 분석해 보안 취약점을 파악하거나 복잡한 공급망 정보에서 인사이트를 추출하는 데 도움을 줄 수 있습니다. 그리고 자연스럽고 개인화된 쇼핑 경험을 제공하는 AI 기반 소매 쇼핑 자문 서비스를 강화하는 등 다양한 작업을 수행할 수 있습니다.

이러한 사례를 위한 NVIDIA AI 워크플로우는 생성형 AI 기반 기술 개발을 위해 도움을 제공하는 간편한 시작점이 됩니다.

수십 개의 NVIDIA 데이터 플랫폼 파트너가 NeMo Retriever NIM 마이크로서비스와 협력해 AI 모델의 정확도, 처리량을 높이고 있습니다.

데이터스택스(DataStax)는 자사의 아스트라 DB(Astra DB)와 하이퍼 컨버지드 플랫폼(Hyper-Converged Platforms)에 NIM 마이크로서비스를 내장한 NeMo Retriever를 통합합니다. 고객에게 정확하고 생성적인 AI 강화 RAG 기능을 제공함으로써 시장 출시 시간을 단축할 수 있게 됐죠.

코히시티(Cohesity)는 NVIDIA NeMo Retriever 마이크로서비스와 자사의 AI 제품인 코히시티 가이아(Gaia)를 통합했습니다. 이로써 고객들이 RAG를 기반으로 데이터를 활용해 통찰력 있고 혁신적인 생성형 AI 애플리케이션을 구동할 수 있도록 지원할 예정입니다.

키네티카(Kinetica)는 LLM 에이전트를 개발하기 위해 NVIDIA NeMo Retriever를 사용할 예정입니다. 이는 자연어로 복잡한 네트워크와 상호 작용해 중단이나 침해 상황에 보다 신속하게 대응하고 인사이트를 즉각적인 조치로 전환할 수 있습니다.

넷앱(NetApp)은 NVIDIA와 협력해 NeMo Retriever 마이크로서비스를 지능형 데이터 인프라의 엑사바이트급 데이터에 연결하고 있습니다. 모든 넷앱 온탭(ONTAP) 고객은 데이터의 보안이나 개인 정보를 침해하지 않고도 데이터와 원활하게 ‘대화’하고 독점적인 비즈니스 인사이트에 액세스할 수 있죠.

액센츄어(Accenture), 딜로이트(Deloitte), 인포시스(Infosys), LTTS, 타타 컨설턴시 서비시스(Tata Consultancy Services), 테크 마힌드라(Tech Mahindra), 위프로(Wipro) 등 NVIDIA의 글로벌 시스템 통합 파트너와 서비스 제공 파트너인 데이터 몬스터즈(Data Monsters), 엑슬서비스 (아일랜드) 리미티드(EXLService (Ireland) Limited), 레이턴트뷰(Latentview), 퀀티파이(Quantiphi), 슬라럼(Slalom), 소프트서브(SoftServe), 트레던스(Tredence)는 기업이 자사의 AI 파이프라인에 NeMo Retriever NIM 마이크로서비스를 추가할 수 있도록 지원하는 서비스를 개발 중입니다.

다른 NIM 마이크로서비스와 함께 사용하기

NeMo Retriever NIM 마이크로서비스는 산업 전반의 음성 AI 애플리케이션을 강화합니다. 이를 통해 고객 서비스를 개선하고 디지털 휴먼에 활기를 불어넣는 NVIDIA Riva NIM 마이크로서비스와 함께 사용할 수 있습니다.

곧 Riva NIM 마이크로서비스로 제공될 새로운 모델에는 텍스트 음성 변환 애플리케이션을 위한 FastPitch와 HiFi-GAN, 다국어 신경망 기계 번역을 위한 Megatron, 자동 음성 인식을 위한 혁신적인 NVIDIA Parakeet 모델 제품군 등이 포함됩니다.

NVIDIA NIM 마이크로서비스는 전부 함께 또는 개별적으로 사용할 수 있어 개발자에게 AI 애플리케이션 구축에 대한 모듈식 접근 방식을 제공합니다. 또한 마이크로서비스는 클라우드, 온프레미스 또는 하이브리드 환경에서 커뮤니티 모델, NVIDIA 모델 또는 사용자의 맞춤형 모델과 통합할 수 있어 개발자에게 더 큰 유연성을 제공하죠.

NVIDIA NIM 마이크로서비스는 ai.nvidia.com에서 사용할 수 있습니다. 기업은 NVIDIA AI Enterprise 소프트웨어 플랫폼으로 NIM을 사용해 프로덕션 환경에서 AI 애플리케이션을 배포할 수 있습니다.

NIM 마이크로서비스는 아마존 웹 서비스(Amazon Web Services, AWS), 구글 클라우드(Google Cloud), 마이크로소프트 애저(Microsoft Azure), 오라클 클라우드 인프라스트럭처(Oracle Cloud Infrastructure)의 클라우드 인스턴스와 시스코(Cisco), 델 테크놀로지스(Dell Technologies), 휴렛팩커드 엔터프라이즈(Hewlett Packard Enterprise), 레노버(Lenovo), 슈퍼마이크로(Supermicro)로 등 글로벌 서버 제조 파트너의 NVIDIA Certified System 등 고객이 선호하는 가속화된 인프라에서 실행할 수 있습니다.

NVIDIA Developer Program 회원은 곧 자신이 선호하는 인프라에서 연구, 개발, 테스트를 위해 NIM에 무료로 액세스할 수 있습니다.

7월 28일부터 8월 1일까지 미국 덴버에서 열리는 글로벌 최대 컴퓨터 그래픽 콘퍼런스인 SIGGRAPH에서 NVIDIA와 함께 최신 생성형 AI와 가속 컴퓨팅에 대해 자세히 알아보세요.

소프트웨어 제품의 서비스 약관을 자세히 확인하세요.