편집자 노트: 본 게시물은 AI Decoded 시리즈의 일부로, AI에 대한 접근성을 높여 AI에 대한 이해를 돕고, GeForce RTX PC 및 NVIDIA RTX 워크스테이션 사용자를 위한 새로운 하드웨어, 소프트웨어, 도구 및 가속 기술을 소개합니다.

거대 언어 모델(LLM)은 생산성을 재구성하고 있습니다. 그들은 문서를 작성하고, 웹 페이지를 요약하고, 방대한 양의 데이터에 대해 훈련을 받았으며, 거의 모든 주제에 대한 질문에 정확하게 답할 수 있습니다. LLM은 디지털 비서, 대화형 아바타 및 고객 서비스 에이전트를 포함하여 생성형 AI에서 다양하고 많은 활용 사례의 핵심이 됩니다.

최신 LLM의 대부분은 PC 또는 워크스테이션에서 로컬로 실행할 수 있습니다. 사용자는 기기에서 대화와 콘텐츠를 비공개로 유지하거나, 인터넷 없이 AI를 사용할 수 있으며, 또는 단순히 시스템에서 강력한 NVIDIA GeForce RTX GPU를 활용할 수 있습니다. 다른 모델은 크기와 복잡성 때문에 로컬 GPU의 비디오 메모리(VRAM)에 적합하지 않으며 대형 데이터 센터에서 하드웨어가 필요합니다.

그러나, GPU 오프로드라는 기술을 사용하여 RTX 기반 PC에서 데이터 센터 클래스 모델의 프롬프트의 일부를 로컬로 가속화할 수 있습니다. 이를 통해 사용자는 GPU 메모리 제약에 의해 제한되지 않고 GPU 가속을 활용할 수 있습니다.

크기 및 품질과 성능 비교

모델 크기와 응답의 품질과 성능 사이에 상충점이 있습니다. 일반적으로 더 큰 모델은 더 높은 품질의 응답을 제공하지만 더 느리게 실행됩니다. 더 작은 모델에서는 성능이 올라가고 품질이 떨어집니다.

이 균형은 언제나 간단한 것은 아닙니다. 성능이 품질보다 더 중요할 수 있는 경우가 있습니다. 일부 사용자는 작업이 백그라운드에서 실행될 수 있기 때문에 콘텐츠 생성과 같은 사용 사례에 대해 정확성을 우선 순위로 지정할 수 있습니다. 한편, 대화 어시스턴트는 정확한 응답을 빠르게 제공해야 합니다.

데이터 센터에서 실행되도록 설계된 가장 정확한 LLM은 수십 기가바이트 크기이며 GPU의 메모리에 적합하지 않을 수 있습니다. 이로 인해 전통적으로 응용 프로그램이 GPU 가속을 활용하지 못하게 됩니다. 그러나 GPU 오프로드를 통해 사용자는 GPU과 CPU에서 LLM의 일부를 사용할 수 있으므로 모델 크기에 관계없이 GPU 가속을 최대한 활용할 수 있습니다.

GPU 오프로드 및 LM Studio를 통한 AI 가속 최적화

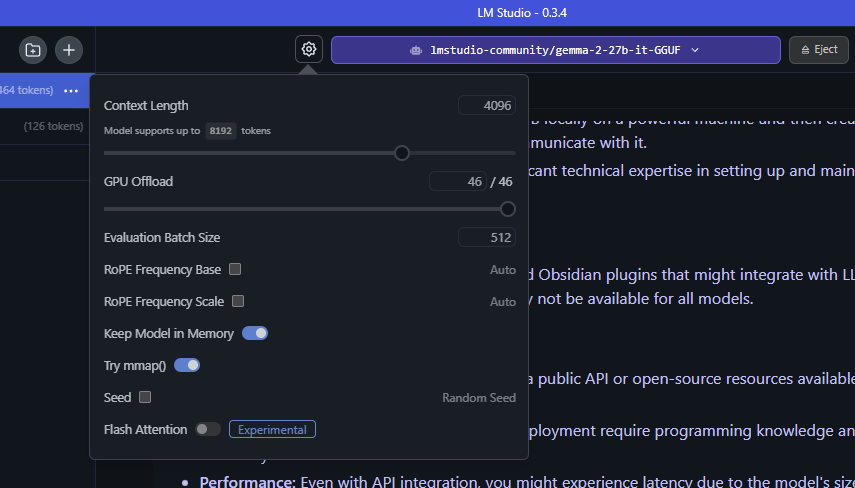

LM Studio는 사용자가 데스크탑 또는 노트북 컴퓨터에서 LLM을 다운로드하고 호스팅할 수있게 해주는 응용 프로그램으로, 사용하기 쉬운 인터페이스로 모델 작동 방법에 대한 광범위한 사용자 정의를 허용합니다. LM Studio는 llama.cpp 위에 구축되어 GeForce RTX 및 NVIDIA RTX GPU와 함께 사용하도록 완벽하게 최적화되었습니다.

LM Studio와 GPU 오프로드를 통해 사용자는 GPU 가속을 활용하여 로컬 호스팅 LLM의 성능을 향상할 수 있습니다.

GPU 오프로드를 통해 LM Studio는 모델 아키텍처의 레이어를 나타내는 작은 청크 또는 “하위 그래프”로 모델을 나눕니다. 서브그래프는 GPU에 영구적으로 고정되지 않지만 필요에 따라 로드 및 언로드됩니다. LM Studio의 GPU 오프로드 슬라이더를 사용하면 사용자는 GPU에서 처리하는 레이어의 수를 결정할 수 있습니다.

예를 들어, Gemma 2 27B와 같은 거대 모델에 이 GPU 오프로드 기술을 사용한다고 상상해 보십시오. “27B”는 모델에서 파라미터의 수를 나타내며, 모델을 실행하는 데 필요한 메모리의 양을 추정합니다. 정확도를 크게 줄이지 않고 LLM의 크기를 줄이는 기술인 4비트 양자화에 따르면, 각 매개 변수는 메모리의 절반 바이트를 차지합니다. 즉, 모델은 약 135억 바이트 또는 13.5GB를 필요로 하며, 일반적으로 1~5GB의 범위의 오버헤드가 필요합니다.

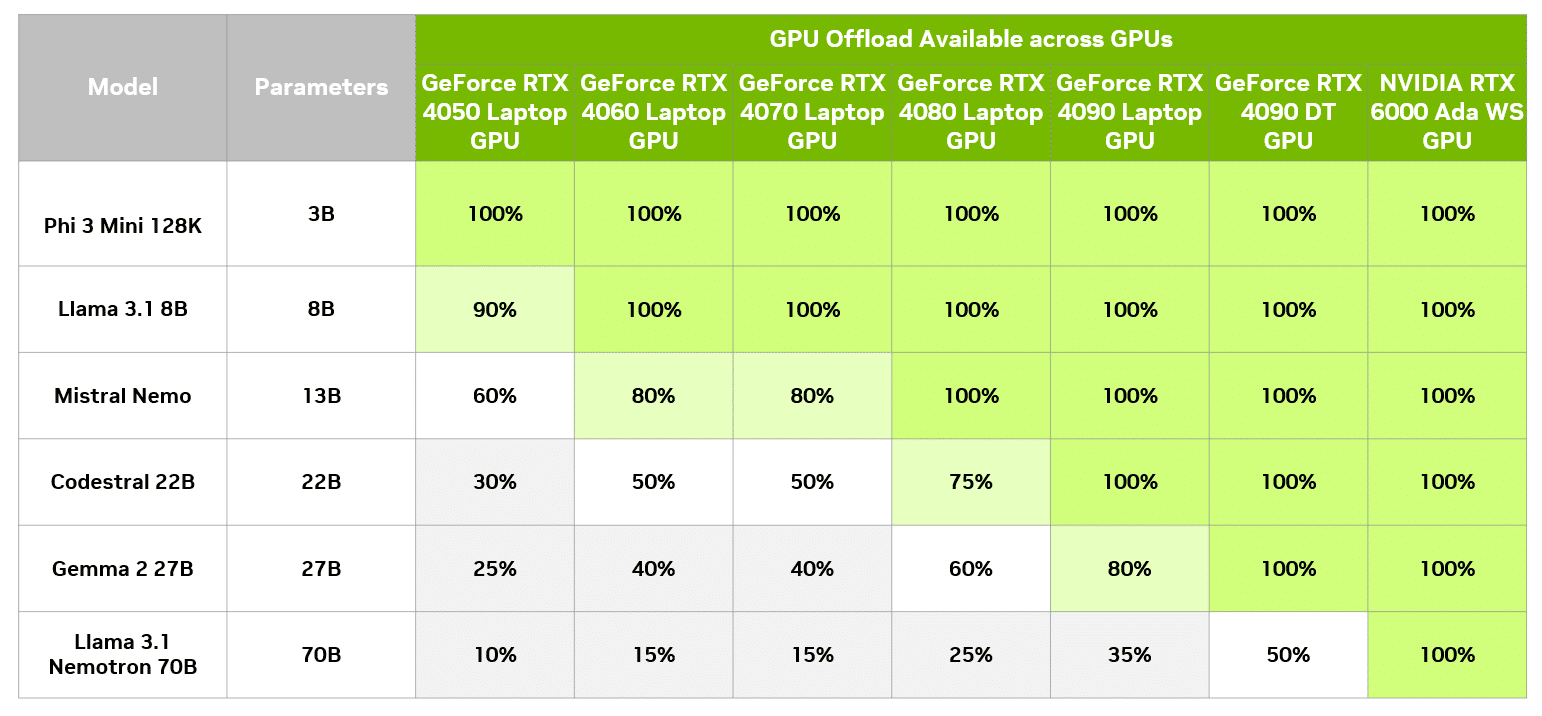

GPU에서 이 모델을 가속화하려면 GeForce RTX 4090 데스크탑 GPU에서 사용할 수 있는 19GB의 VRAM이 필요합니다. GPU 오프로드를 통해 이 모델은 저사양 GPU를 사용하는 시스템에서 실행할 수 있으며, 계속 가속의 이점을 누릴 수 있습니다.

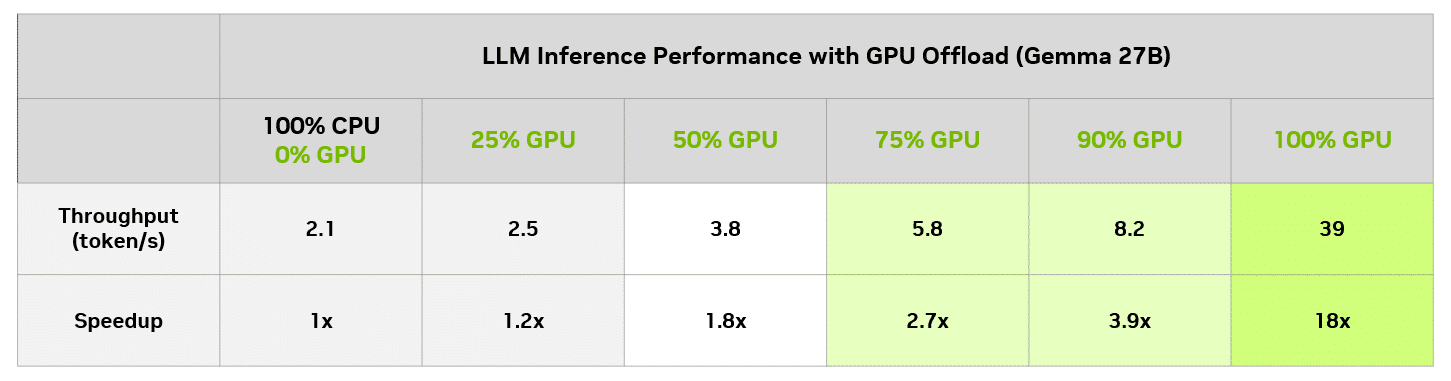

LM Studio에서는 CPU만 비교하여 다양한 수준의 GPU 오프로딩이 성능에 주는 영향을 평가할 수 있습니다. 아래 표는 GeForce RTX 4090 데스크톱 GPU에서 다양한 오프로딩 수준에서 동일한 쿼리를 실행한 결과를 보여줍니다.

이 특정 모델에서는 8GB GPU를 사용하는 사용자조차도 CPU에서만 실행하는 것과 비교하여 의미있는 속도 향상을 즐길 수 있습니다. 물론 8GB GPU는 GPU 메모리에 완전히 적합한 작은 모델을 항상 실행하고 전체 GPU 가속을 얻을 수 있습니다.

최적의 균형 달성

LM Studio의 GPU 오프로드 기능은 Gemma-2-27B와 같은 RTX AI PC에서 로컬로 데이터 센터용 LLM의 잠재력을 최대한 활용할 수 있는 강력한 도구입니다. 이를 통해 더 크고 복잡한 모델을 GeForce RTX 및 NVIDIA RTX GPU를 사용하는 전체 PC 라인업에 사용할 수 있습니다.

LM Studio를 다운로드받고 더 큰 모델에서 GPU 오프로드를 시도하거나 RTX AI PC 및 워크스테이션에서 로컬로 실행되는 다양한 RTX 가속 LLM을 실험해 보세요.

생성형 AI는 게임, 화상 회의 및 모든 종류의 인터랙티브 경험을 혁신하고 있습니다. AI Decoded 뉴스레터를 구독하고 AI 기술이 바꿀 현재와 미래의 모습을 확인하세요.