NVIDIA Hopper 아키텍처는 도입 이후 AI와 고성능 컴퓨팅(HPC) 환경을 혁신하고 있습니다. 기업, 연구자, 개발자들은 세계에서 가장 복잡한 문제를 더 높은 성능과 에너지 효율로 해결할 수 있게 됐죠.

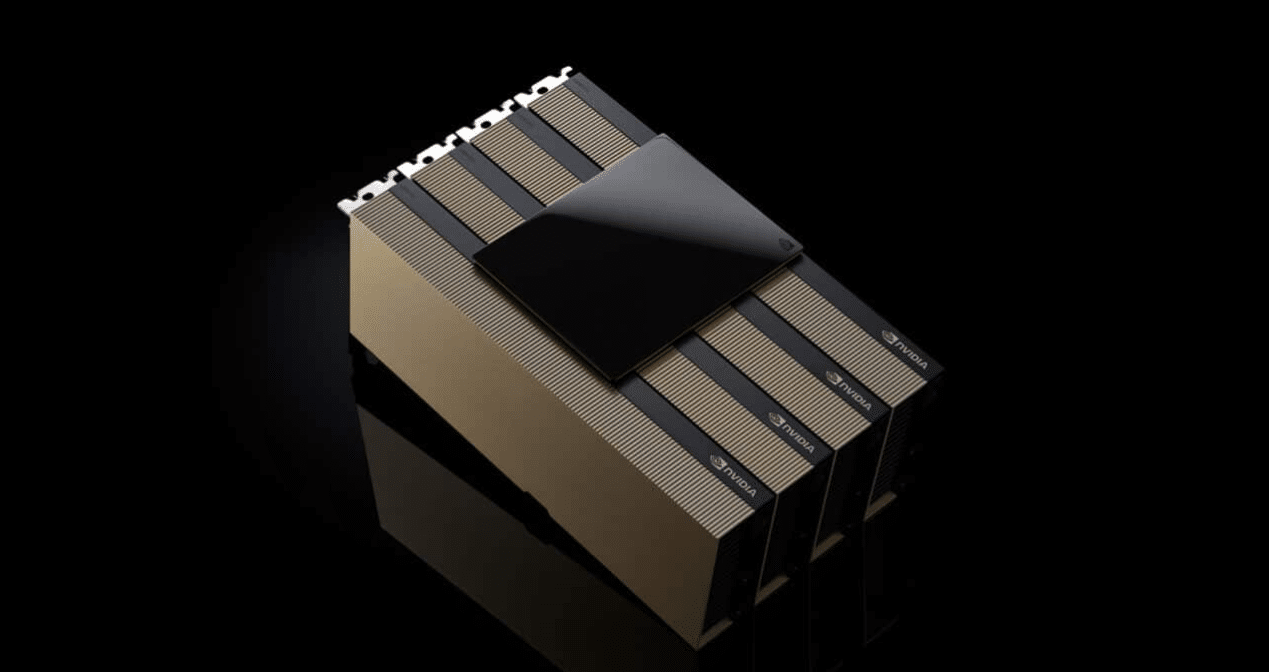

‘슈퍼컴퓨팅 2024(Supercomputing 2024, SC24) 콘퍼런스에서 NVIDIA는 Hopper 제품군의 최신 제품인 NVIDIA H200 NVL PCIe GPU의 출시를 발표했습니다. NVIDIA H200 NVL PCIe GPU는 낮은 전력 소비와 공랭식 엔터프라이즈 랙 설계를 희망하는 데이터센터를 보유한 조직에 적합합니다. 규모에 관계없이 모든 AI와 HPC 워크로드에 가속을 제공할 수 있는 유연한 구성을 갖추고 있습니다.

최근 조사에 따르면, 엔터프라이즈 랙의 약 70%가 20kW 이하이며, 공랭식을 사용하는 것으로 나타났습니다. 따라서 PCIe GPU가 필수인데요. PCIe GPU는 1개, 2개, 4개, 8개 등 세분화된 노드 배치를 제공해, 데이터센터가 더 작은 공간에 더 많은 컴퓨팅 성능을 구현할 수 있게 해줍니다. 기업은 기존 랙을 활용하고 필요에 맞는 적합한 GPU 수를 선택할 수 있습니다.

기업은 H200 NVL을 사용해 AI와 HPC 애플리케이션을 가속화하는 동시에 전력 소비를 줄여 에너지 효율성을 개선할 수 있습니다. H200 NVL은 NVIDIA H100 NVL 대비 메모리가 1.5배 증가하고, 대역폭이 1.2배 증가했습니다. 이를 통해 기업들은 몇 시간 내에 거대 언어 모델(Large Language Model, LLM)을 미세 조정하고, 최대 1.7배 빠른 추론 성능을 제공할 수 있죠. HPC 워크로드의 경우, 성능은 H100 NVL 대비 최대 1.3배, NVIDIA Ampere 아키텍처 세대 대비 2.5배까지 향상됩니다.

H200 NVL의 원시 성능을 보완하는 것은 NVIDIA NVLink 기술입니다. 최신 세대의 NVLink는 5세대 PCIe보다 7배 빠른 GPU 간 통신을 제공해 HPC, LLM 추론과 미세 조정의 요구 사항을 충족하는 더 높은 성능을 제공합니다.

NVIDIA H200 NVL은 기업이 AI에서 HPC에 이르는 애플리케이션을 가속화할 수 있는 강력한 소프트웨어 도구와 함께 제공됩니다. 또한, 프로덕션 AI의 개발과 배포를 위한 클라우드 네이티브 소프트웨어 플랫폼인 NVIDIA AI Enterprise 5년 구독도 함께 제공됩니다. NVIDIA AI Enterprise는 고성능 AI 모델 추론의 안전하고 신뢰할 수 있는 배포를 위한 NVIDIA NIM 마이크로서비스를 포함합니다.

H200 NVL을 활용하는 기업들

NVIDIA는 H200 NVL을 통해 기업들이 AI와 HPC 워크로드를 개발하고 배포할 수 있는 풀스택 플랫폼을 제공합니다.

고객들은 다양한 산업 분야의 AI와 HPC 사용 사례에서 상당한 효과를 보고 있습니다. 예를 들어, 고객 서비스용 비주얼 AI 에이전트와 챗봇, 금융을 위한 거래 알고리즘, 의료 분야의 이상 징후 감지 개선을 위한 의료 이미징, 제조업의 패턴 인식, 연방 과학 기관을 위한 지진 이미징 등이 있습니다.

드롭박스(Dropbox)는 서비스와 인프라에 NVIDIA 가속 컴퓨팅을 활용하고 있습니다.

드롭박스의 인프라 담당 부사장인 알리 자파르(Ali Zafar)는 “드롭박스는 대량의 콘텐츠를 처리하기 때문에 고급 AI와 머신 러닝 기능이 필요합니다. 우리는 서비스를 지속적으로 개선하고 고객에게 더 많은 가치를 제공하기 위해 H200 NVL을 검토하고 있습니다”고 말했죠.

뉴멕시코대학교(University of New Mexico)는 다양한 연구와 학술 애플리케이션에서 NVIDIA 가속 컴퓨팅을 사용하고 있습니다.

뉴멕시코대학교 고급 연구 컴퓨팅 센터의 책임자인 패트릭 브리지스(Patrick Bridges) 교수는 “우리는 공공 연구 대학으로서 AI에 대한 헌신으로 과학과 기술 발전의 최전선에 설 수 있었습니다. 이제 H200 NVL로 전환함에 따라 데이터 사이언스 이니셔티브, 생물정보학과 유전체학 연구, 물리학과 천문학 시뮬레이션, 기후 모델링 등 다양한 애플리케이션을 가속화할 수 있을 것”이라고 말했습니다.

에코시스템 전반에서 사용 가능한 H200 NVL

델 테크놀로지스(Dell Technologies), 휴렛팩커드 엔터프라이즈(Hewlett Packard Enterprise), 레노버(Lenovo), 슈퍼마이크로(Supermicro)는 H200 NVL을 지원하는 다양한 구성을 제공할 예정입니다.

또한 H200 NVL은 에이브레스(Aivres), 애즈락랙(ASRock Rack), 에이수스(ASUS), 기가바이트(GIGABYTE), 인그라시스(Ingrasys), 인벤텍(Inventec), MSI, 페가트론(Pegatron), QCT, 위스트론(Wistron), 위윈(Wiwynn)의 플랫폼에서 사용할 수 있습니다.

일부 시스템은 NVIDIA MGX 모듈형 아키텍처를 기반으로, 컴퓨터 제조업체가 방대한 데이터센터 인프라 설계를 빠르고 비용 효율적으로 구축할 수 있도록 합니다.

H200 NVL을 탑재한 플랫폼은 12월부터 NVIDIA의 글로벌 시스템 파트너를 통해 제공될 예정입니다. 주요 글로벌 파트너의 공급을 보완하기 위해 NVIDIA는 H200 NVL 시스템을 위한 Enterprise Reference Architecture도 개발 중입니다.

이 레퍼런스 아키텍처에는 NVIDIA의 전문성과 설계 원칙을 통합해 파트너와 고객이 H200 NVL을 기반으로 고성능 AI 인프라를 대규모로 설계하고 배포할 수 있도록 합니다. 여기에는 최적의 서버, 클러스터, 네트워크 구성에 대한 자세한 지침과 함께 풀스택 하드웨어와 소프트웨어 권장 사항이 포함되죠. 네트워킹은 NVIDIA Spectrum-X 이더넷 플랫폼을 통해 최고의 성능을 발휘하도록 최적화됩니다.

NVIDIA는 11월 22일까지 조지아 월드 콩그레스 센터(Georgia World Congress Center)에서 열리는 SC24에서 NVIDIA 기술을 선보입니다. 자세한 내용은 스페셜 연설 온디맨드 세션을 통해 확인할 수 있습니다.

소프트웨어 제품 정보 관련 공지도 참조하세요.