이번에 열리는 Hot Chips 컨퍼런스 참가자들에게는 AI 연산과 추론, 그리고 네트워킹이 가장 중요한 관심사가 될 것입니다. 업계와 학계의 프로세서 및 시스템 아키텍트를 위한 주요 포럼 중 하나인 Hot Chips은(현지 시간으로 8월 24~26일, 스탠포드 대학교에서 개최)는 AI 팩토리 혁신과 수조 달러 규모의 데이터센터 컴퓨팅 시장의 매출 성장을 이끌 최신 기술들을 선보일 예정인데요.

컨퍼런스에서 NVIDIA는 구글과 마이크로소프트 등 업계 리더들과 함께 데이터센터를 위한 랙 스케일 아키텍처 설계를 논의하는 ‘튜토리얼’ 세션을 진행할 예정인데요, 이와 더불어, NVIDIA 전문가들은 4개의 세션과 1개의 튜토리얼에서 다음과 같은 내용을 자세히 발표할 예정입니다.

- NVIDIA ConnectX-8 SuperNIC을 포함한 NVIDIA 네트워킹 기술은 랙 및 데이터센터 규모에서 AI 연산을 제공합니다. (네트워크 어댑터 및 시스템온칩 수석 아키텍트 Idan Burstein 발표)

- NVIDIA Blackwell 아키텍처와 GeForce RTX 5090 GPU로 구동되는 뉴럴 렌더링 기술과 대규모 AI 추론 혁신은 차세대 그래픽 및 시뮬레이션 기능을 실현합니다. (아키텍처 부문 시니어 디렉터 Marc Blackstein 발표)

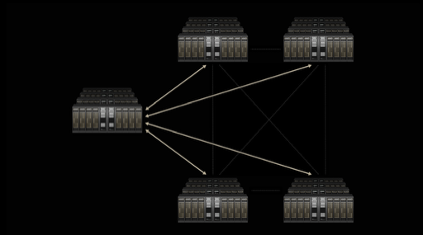

- 집적 실리콘 포토닉스(Co-packaged Optics, CPO) 스위치와 광섬유 기반의 고속 연결은 기존 구리선 대비 더 빠르고 적은 전력으로 정보를 전송해 효율적이고 고성능의 기가와트 급 AI 팩토리 구현을 가능하게 합니다. 이 발표에서는 여러 데이터센터를 하나의 AI 슈퍼팩토리로 통합하는 신규 기술인 NVIDIA Spectrum-XGS 이더넷도 소개됩니다. (네트워킹 담당 시니어 부사장 Gilad Shainer 발표)

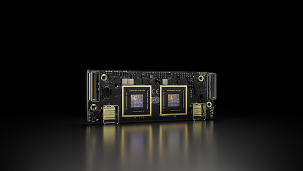

- NVIDIA GB10 슈퍼칩은 NVIDIA DGX Spark 데스크탑 슈퍼컴퓨터의 핵심 엔진 역할을 합니다. (수석 엔지니어 Andi Skende 발표)

위 모든 과정이 바로 NVIDIA의 최신 기술들이 모든 곳, 모든 규모에서 AI 혁신을 이끌기 위해 추론을 가속화하는 방법들입니다.

대규모 AI 혁신을 촉진하는 NVIDIA 네트워킹

AI 추론, 즉 인공지능 시스템이 여러 번의 AI 추론 과정을 거치며 복잡한 문제를 분석하고 해결하려면 랙 규모의 성능이 필요하며, 이를 통해 최적의 사용자 경험을 효율적으로 제공하게 되는데요.

오늘날 AI 워크로드를 구동하는 데이터센터에서는 네트워킹이 모든 구성 요소(서버, 스토리지 장치 및 기타 하드웨어)를 하나의 강력한 컴퓨팅 유닛으로 연결하는 중심 신경망 역할을 하게 됩니다.

Burstein의 Hot Chips 세션에서는 NVIDIA 네트워킹 기술, 특히 NVIDIA ConnectX-8 SuperNIC이 시장을 선도하는 고속·저지연·멀티-GPU 통신을 통해 대규모 AI 추론 성능을 어떻게 구현하는지 다룰 예정이죠.

NVIDIA 네트워킹 플랫폼에서는 NVLink, NVLink Switch, NVLink Fusion이 초저지연·고대역폭 데이터 교환을 위해 서버 내외부의 GPU와 컴퓨트 요소를 연결하는 확장형 연결성을 제공합니다.

NVIDIA Spectrum-X Ethernet은 전체 클러스터를 연결하는 스케일-아웃 패브릭을 제공하여, 방대한 데이터셋을 빠르게 AI 모델에 스트리밍하고 데이터센터 내에서 GPU 간 통신을 조율합니다. 또한, Spectrum-XGS Ethernet 스케일-어크로스 기술은 여러 분산 데이터센터를 하나로 연결하여 기가-스케일 AI 슈퍼팩토리 구현을 지원합니다.

Spectrum-X Ethernet의 핵심에는 CPO(Co-packaged Optics) 스위치가 있어, 대규모 AI 인프라의 성능과 효율성을 극대화하며, 이 부분은 Shainer의 세션에서 자세히 다룰 예정입니다.

NVIDIA GB200 NVL72는 단일 랙에 엑사스케일 컴퓨팅을 제공하는 시스템으로, 각각 두 개의 NVIDIA B200 GPU와 하나의 NVIDIA Grace CPU가 탑재된 36개의 NVIDIA GB200 슈퍼칩이 포함되어 있습니다. NVLink Switch는 130테라바이트/초의 저지연 GPU 통신을 제공하며, AI 및 고성능 컴퓨팅 워크로드에 최적화되어 있습니다.

NVIDIA Blackwell 아키텍처로 설계된 GB200 NVL72 시스템은 AI 추론 성능에서 획기적인 도약을 실현합니다

수백 만명의 개발자에게 AI를 제공하는 NVIDIA Blackwell과 CUDA

NVIDIA GeForce RTX 5090 GPU(Blackwell 기반, Blackstein의 세션에서 다룰 예정)는 NVIDIA DLSS 4 기술로 최신 게임에서 성능을 두 배로 높여줍니다.

NVIDIA GeForce RTX 5090 GPU는 뉴럴 렌더링 기술을 게임에 적용하여 최대 10배의 성능, 10배의 발자취 확대, 10배의 디자인 주기 단축을 이끌어 내며, 컴퓨터 그래픽과 시뮬레이션의 사실감을 크게 높여주는데요, 이를 통해 낮은 에너지 소비로 부드럽고 반응성이 뛰어난 시각 경험과 실제에 가까운 효과 및 캐릭터 시뮬레이션을 제공합니다.

NVIDIA CUDA는 세계에서 가장 널리 사용되는 컴퓨팅 인프라로, 사용자가 NVIDIA Blackwell을 기반으로 어디서나 AI 모델을 배포하고 실행할 수 있게 합니다. 수억 대의 GPU가 전 세계에서 CUDA를 구동 중입니다. NVIDIA GB200 NVL72 랙 스케일 시스템, GeForce RTX 및 NVIDIA RTX PRO 기반 PC와 워크스테이션, 곧 출시될 NVIDIA GB10 기반 DGX Spark(이 내용은 Skende의 세션에서 소개 예정) 등이 이 에코시스템에 포함되죠.

알고리즘부터 AI 슈퍼컴퓨터까지 — LLM(거대 언어 모델)에 최적화

컴팩트한 구성으로 강력한 성능과 기능을 제공하는 DGX Spark를 통해 개발자, 연구자, 데이터 과학자, 학생들은 데스크톱 환경에서 생성형 AI의 한계를 확장하고 업계 전반의 워크로드를 가속화할 수 있습니다.

DGX Spark는 Blackwell 플랫폼의 일부로서, 대형 언어 모델 등 에이전틱 AI 추론 효율화를 위해 저정밀 수치 형식 NVFP4를 지원하는데요, NVFP4에 관한 더 많은 내용은 NVIDIA 공식 기술 블로그에서 확인할 수 있습니다.

오픈소스 협업으로 추론 혁신 추진

NVIDIA는 오픈소스 라이브러리와 프레임워크(예: TensorRT-LLM, Dynamo, TileIR, Cutlass, NVIDIA Collective Communication Library, NIX 등)를 가속화하여 LLM 및 분산 추론 AI 워크로드의 최적화를 지원합니다.

개발자는 FlashInfer, PyTorch, SGLang, vLLM 등 선호하는 프레임워크로 모델 최적화를 할 수 있고, NVIDIA는 여기에 주요 오픈 프레임워크 파트너와 협력해 지원체계를 제공하고 있는데요, 특히 NVIDIA NIM 마이크로서비스는 OpenAI의 gpt-oss, Llama 4 등 인기 오픈 모델을 위한 관리형 API를 제공하므로, 개발자가 선호하는 인프라 위에서 직접 모델을 자가 호스팅하면서 안전하고 유연하게 운용할 수 있답니다.

Hot Chips에서 들려온 추론 및 가속 컴퓨팅 분야의 최신 소식을 직접 확인해보세요.