과거에는 거대한 슈퍼컴퓨터에서 시작된 컴퓨팅 성능이 시간이 지나면서 점차 작은 칩으로 확산되는 흐름이 일반적이었습니다.

그러나 지난 15년간 혁신의 흐름이 바뀌었습니다. 게임에서 탄생해 가속 컴퓨팅으로 확장된 GPU는 슈퍼컴퓨팅을 재편하며, AI 혁명을 과학 컴퓨팅의 가장 전문적인 시스템까지 확산시키고 있는 것입니다.

독일 율리히 연구소(Forschungszentrum Jülich)의 주피터(JUPITER)는 새로운 시대를 상징하는 대표적인 슈퍼컴퓨터입니다.

주피터는 와트당 63.3 기가플롭스(gigaflops)를 기록하며 가장 효율적인 슈퍼컴퓨터 중 하나로 꼽히며, AI 성능에서도 탁월한 성능을 보여주죠. 주피터는 2025년 ISC 하이 퍼포먼스(ISC High Performance) 기준 92 AI 엑사플롭스(exaflops)에서 크게 향상된 116 AI 엑사플롭스의 성능을 기록했습니다.

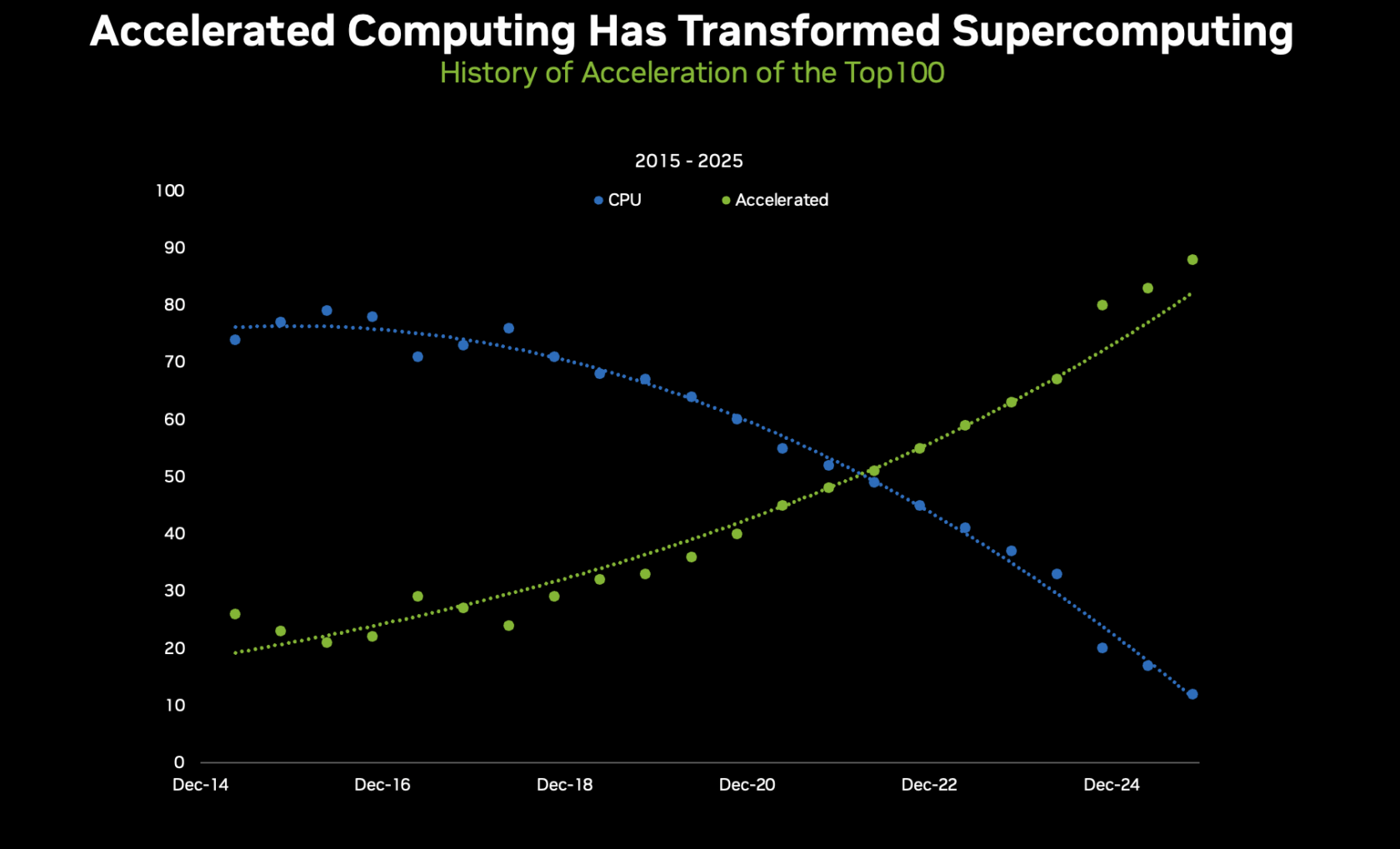

이는 패러다임의 전환을 보여주는 좋은 사례죠. 2019년만 해도 상위 100개 고성능 컴퓨팅 시스템의 약 70%가 CPU 전용이었으나, 오늘날 이 비중은 15% 이하로 떨어졌습니다. 상위 100개 시스템 중 88개가 가속 방식을 택하고 있으며, 그 중 80%는 NVIDIA GPU를 활용하고 있습니다.

상위 500개 시스템 중에서는 총 388개, 약 78%에 해당하는 시스템이 NVIDIA 기술을 사용하고 있는데요. 그 중 218개는 GPU 가속 시스템이며, 이는 전년 대비 34개 증가한 수치입니다. 또한 362개 시스템은 고성능 NVIDIA 네트워킹으로 연결돼 있습니다. 이처럼 가속 컴퓨팅은 사실상 업계 표준이 됐습니다.

그러나 진정한 혁신은 AI 성능에서 나타납니다. NVIDIA Hopper와 Blackwell 아키텍처, 그리고 주피터와 같은 시스템 덕분에 연구자들은 이전보다 훨씬 더 방대한 AI 컴퓨팅 자원을 활용할 수 있게 됐죠.

AI 플롭스(AI FLOPS)는 이제 새로운 기준이 됐으며, 기후 모델링, 신약 개발, 양자 시뮬레이션 등 규모와 효율성을 동시에 요구하는 과제 해결에 기여하고 있습니다.

NVIDIA 젠슨 황 CEO는 오늘날 생성형 AI 열풍이 불기 훨씬 이전인 SC16에서 이미 이러한 흐름을 예견했는데요. 당시 그는 AI가 머지않아 세계에서 가장 강력한 컴퓨팅 시스템을 재편할 것이라고 내다봤죠.

젠슨 황 CEO는 “몇 년 전, 딥러닝은 마치 하늘에서 떨어지는 토르의 망치처럼 등장해 세계에서 가장 어려운 문제를 해결할 수 있는 강력한 도구를 우리에게 선사했습니다”고 말했습니다.

컴퓨팅 전력 소비를 수치로 계산한 결과, GPU로의 전환은 이미 불가피한 흐름이었습니다.

그러나 GPU를 기반으로 구축된 NVIDIA CUDA-X 컴퓨팅 플랫폼이 촉발한 AI 혁명은 이러한 시스템들의 성능을 극적으로 확장했습니다.

이제 슈퍼컴퓨터는 이중 정밀도(FP64)는 물론 FP32, FP16을 비롯한 혼합 정밀도, 나아가 INT8과 그 이상의 초고효율 포맷에서도 의미 있는 과학 연구를 지원할 수 있으며, 이는 오늘날 AI의 핵심 기반을 제공합니다.

이러한 유연성 덕분에 연구자들은 이전보다 훨씬 효율적으로 전력을 활용할 수 있게 됐습니다. 즉, 더 크고 복잡한 시뮬레이션을 수행하고, 더 깊은 신경망을 훈련하며, 동시에 와트당 성능을 극대화할 수 있게 된 것인데요.

하지만 AI가 본격화되기 전부터 이미 수치 자체가 문제를 드러내고 있었습니다. 사용 가능한 전력은 한정돼 있었고, NVIDIA 내부와 커뮤니티 전반의 슈퍼컴퓨터 연구자들은 다가올 미래를 직시했습니다. 그 미래의 중심에는 GPU가 있었습니다.

엑사스케일 성능을 달성하면서 막대한 전기 요금을 피하려면 ‘가속화’가 필요했습니다. GPU는 CPU보다 와트당 훨씬 더 많은 작업을 처리할 수 있었죠. 이는 AI가 본격화되기 전부터 이미 알려진 것입니다. 덕분에 대규모 GPU 시스템은 AI 열풍이 불었을 때 일찍이 추진력을 갖출 수 있었습니다.

2012년, 오크리지 국립연구소(Oak Ridge National Laboratory)의 ‘타이탄(Titan)’으로 그 씨앗이 뿌려졌습니다. 타이탄은 전례 없는 규모로 CPU와 GPU를 결합한 미국 최초의 대형 시스템 중 하나로, 계층적 병렬 처리가 얼마나 큰 애플리케이션 성능 향상을 이끌어낼 수 있는지를 보여줬습니다.

2013년 유럽에서는 피즈 데인트(Piz Daint)가 성능과 효율성 모두에서 새로운 기준을 세웠고, 기상 예측을 위한 코스모(COSMO) 모델처럼 실제 애플리케이션에서 그 가치를 확실히 증명했습니다.

2017년에 이르자 변화의 흐름은 부정할 수 없게 됐습니다. 오크리지 국립연구소의 서밋(Summit)과 로렌스 리버모어 국립연구소(Lawrence Livermore Laboratory)의 시에라(Sierra)는 리더십급 시스템의 새로운 표준을 열었는데, 그것은 바로 ‘가속 중심’이었습니다. 이들은 단지 더 빠르게 실행되는 데서 그치지 않고, 기후 모델링, 유전체학, 소재 연구 등 과학이 던질 수 있는 질문 자체를 바꿔 놓았죠.

이러한 시스템은 훨씬 적은 자원으로 훨씬 더 많은 일을 해낼 수 있습니다. 가장 효율적인 시스템을 순위화한 그린500(Green500) 리스트에서 상위 8개 시스템은 모두 NVIDIA 가속 기술을 사용하고 있습니다. 그리고 상위 10개 중 7개는 NVIDIA Quantum InfiniBand로 연결돼 있습니다.

이러한 인상적인 수치 뒤에는 AI 역량이 새로운 기준이 되었다는 흐름이 있습니다. 주피터는 1 엑사플롭스의 FP64 연산 성능과 함께 116 엑사플롭스의 성능을 제공하죠. 이는 과학이 이제 시뮬레이션과 AI를 어떻게 융합하고 있는지를 명확하게 보여주는 신호입니다. 전력 효율성은 단지 엑사스케일을 실현 가능하게 만든 것에 그치지 않고, 엑사스케일 수준의 AI를 실질적으로 구현할 수 있게 했습니다. 그리고 과학이 대규모 AI를 갖추게 된 순간, 성장 곡선은 급격히 상승하기 시작했죠.

다음 단계의 의미

이것은 단순히 벤치마크가 아닌, 실제 과학에 관한 이야기입니다.

- 더 빠르고 정밀한 기상, 기후 모델

- 신약 개발과 유전체학 분야의 혁신

- 핵융합로와 양자 시스템 시뮬레이션

- 모든 학문 분야에서 펼쳐지는 AI 기반 연구의 새로운 지평

이 변화는 전력 효율이라는 필수 과제에서 시작해, 아키텍처적 우위로 발전했으며, 이제는 시뮬레이션과 AI를 결합해 전례 없는 규모로 과학을 가속하는 ‘과학적 초능력’으로 거듭났습니다.

모든 것은 과학 컴퓨팅에서 시작됐으며, 이제 컴퓨팅의 나머지 영역도 그 뒤를 따르게 될 것으로 기대됩니다.