NVIDIA가 MLPerf 벤치마크에서 최상의 AI 훈련 성능을 제공하고 있습니다.

이번 MLPerf에서 NVIDIA 파트너가 제출한 제출물이 전체의 90%를 차지합니다. 이는 NVIDIA AI 플랫폼의 선도적인 다기능성과 광범위한 생태계를 보여주는 것이죠. 또한 NVIDIA AI 플랫폼은 MLPerf 트레이닝 2.0 라운드에서 8가지 벤치마크를 모두 다뤘습니다.

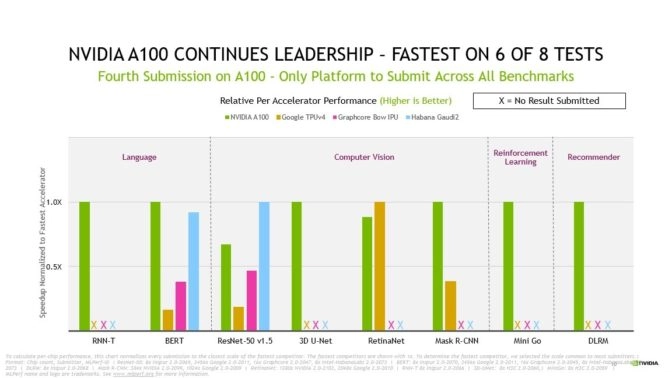

음성 인식, 자연어 처리, 추천 시스템, 객체 감지, 이미지 분류 등 인기 있는 AI 사용 사례를 나타내는 모든 벤치마크를 실행한 것은 NVIDIA가 유일합니다. NVIDIA는 2018년 12월 AI 벤치마크 업계 표준인 MLPerf의 1차 라운드에 제출한 이후 지속적으로 발전했습니다.

최고의 벤치마크 결과 – 가용성

4회 연속 MLPerf 트레이닝 제출에서 NVIDIA Ampere 아키텍처 기반 NVIDIA A100 Tensor Core GPU는 꾸준히 우수한 성능을 보였습니다.

각 제출자 플랫폼별 각 네트워크에서 가장 빠른 훈련 시간

NVIDIA AI 슈퍼컴퓨터인 Selene은 8개 테스트 중 4개에서 훈련하는 데 가장 빠른 시간을 보였습니다. 여기서 Selene은 모듈식 NVIDIA DGX SuperPOD 기반 NVIDIA A100 GPU, 소프트웨어 스택 및 NVIDIA InfiniBand 네트워킹으로 구동됩니다.

또한 NVIDIA A100은 칩당 선두를 유지하며, 8개의 테스트 중 6개의 테스트에서 가장 빠른 성능을 입증했습니다.

총 16개 회사가 NVIDIA AI 플랫폼을 사용해 이번 라운드의 결과를 제출했는데요. 여기에는 에이수스(ASUS), 바이두(Baidu), CASIA (Institute of Automation, Chinese Academy of Sciences),델 테크놀로지스(Dell Technologies), 후지쯔(Fujitsu), 기가바이트(GIGABYTE), H3C, HPE(Hewlett Packard Enterprise), 인스퍼(Inspur), 레노버(Lenovo), 네트릭스(Nettrix) 및 슈퍼마이크로(Supermicro) 등이 포함됩니다.

대부분의 NVIDIA OEM 파트너는 NVIDIA에서 검증된 서버인 NVIDIA Certified Systems을 사용했고, 이를 통해 엔터프라이즈 구축을 위한 뛰어난 성능, 관리성, 보안과 확장성을 제공할 수 있었습니다.

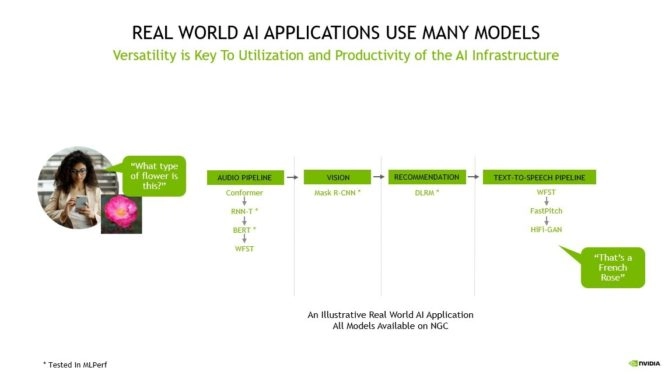

많은 모델들이 실제 AI 애플리케이션을 지원한다

AI 애플리케이션은 사용자의 음성 요청을 이해하고, 이미지를 분류하고, 추천하고, 음성 메시지로 응답을 전달해야 하죠.

따라서 여러 종류의 AI 모델이 필요하고, 사용자는 이러한 모델을 빠르고 유연하게 설계, 교육, 배치 및 최적화해야 합니다.

이에 NVIDIA AI 플랫폼이 제공하는 선도적인 성능과 더불어 다양한 기능이 실제 AI에 필수적입니다.

AI를 통한 ROI 제공

고객에게 데이터 사이언스 및 엔지니어링 팀은 중요한데, 이들의 생산성이 AI 인프라에 대한 투자 수익을 결정하기 때문이죠.

AI 연구원의 생산성은 새로운 아이디어를 신속하게 테스트하는 능력에 달려 있으며, 어떤 모델이든 훈련할 수 있는 다재다능함과 해당 모델을 최대 규모로 훈련할 때 제공되는 속도 모두 필요합니다.

또한 AI 인프라의 활용은 단일 플랫폼에서 데이터 준비부터 훈련, 추론에 이르기까지 전체 AI 워크플로우를 가속화할 수 있는 기능 또는 호환성에 의존합니다.

NVIDIA AI를 통해 고객은 전체 AI 파이프라인에 동일한 인프라를 사용하여 데이터 준비, 교육과 추론 등의 다양한 요구에 맞게 용도 변경할 수 있으며, 활용도가 크게 향상되어 매우 높은 ROI로 이어집니다.

또한 연구원들이 새로운 AI의 돌파구를 발견함에 따라, 최신 모델 혁신을 지원하는 것이 AI 인프라의 사용 수명을 극대화하는 핵심인데요.

NVIDIA AI는 모든 모델에 대해 보편적이고 성능이 뛰어나며, 데이터 준비, 훈련, 추론에 이르기까지 모든 크기에 맞게 확장되고 AI를 엔드 투 엔드로 가속화하므로 달러당 최고의 생산성을 제공합니다.

이번 결과는 지금까지 모든 MLPerf 훈련, 추론, HPC 라운드에서 보여지는 NVIDIA의 광범위하고 심층적인 AI 전문 지식을 입증합니다.

3년 반 만에 23배 향상된 성능

MLPerf에 A100을 처음 제출한 이후 2년 간 NVIDIA 플랫폼은 6배 더 향상된 성능을 제공했습니다. 소프트웨어 스택에 대한 지속적인 최적화는 성능을 증가시키는 데 도움이 됐죠.

NVIDIA AI 플랫폼은 GPU, 소프트웨어, 대규모 개선에 걸친 풀스택 혁신의 결과로 3년 반 만에 23배 향상된 성능을 제공했습니다.

여기에 3월에 발표된 NVIDIA Hopper 아키텍처는 더 큰 발전을 약속했습니다.

구현방법

NVIDIA Ampere 아키텍처에서 더 많은 성능을 제공하면서 소프트웨어 혁신은 계속됩니다.

예를 들어, 많은 가속기에서 실행되는 작업에 대한 시작 오버헤드를 최소화하는 데 도움이 되는 소프트웨어 CUDA 그래프는 제출 문서 전반에 걸쳐 광범위하게 사용됩니다.

GPU에 대한 딥 러닝을 가속화하기 위한 라이브러리인 cuDNN에 대한 최적화는 대규모 ResNet-50 처리량을 4% 이상 높이고, 단일 노드 3D U-Net 제출 속도를 5% 이상 향상시켰습니다.

또한 많은 오디오, 이미지 또는 비디오 데이터를 빠르게 로드하기 위한 라이브러리인 NVIDIA DALI의 향상된 기능은 RNN-T 성능을 향상시키는데 도움이 됐죠.

NVIDIA가 사용하는 모든 소프트웨어는 MLPerf 저장소에서 사용할 수 있으므로 모든 사람이 세계적 수준의 결과를 얻을 수 있습니다. NVIDIA는 GPU 애플리케이션용 소프트웨어 허브인 NGC에 다양한 최적화 사항을 지속적으로 추가하고, NVIDIA AI 엔터프라이즈를 제공하여 NVIDIA가 완벽하게 지원하는 최적화된 소프트웨어를 제공합니다.

A100이 출시된 지 2년이 지난 지금까지 NVIDIA AI 플랫폼은 MLPerf 2.0에서 가장 높은 성능을 지속적으로 제공하고 있으며, 모든 벤치마크에서 제출할 수 있는 유일한 플랫폼입니다. NVIDIA의 차세대 Hopper 아키텍처는 향후 MLPerf 라운드에서 또 다른 큰 도약을 약속합니다.

NVIDIA 플랫폼은 모든 규모의 모든 모델과 프레임워크에 사용 가능하며, AI 워크로드의 모든 부분을 처리할 수 있는 호환성을 제공합니다. 뿐만 아니라 모든 클라우드와 모든 주요 서버 제조업체에서 사용할 수 있습니다.