NVIDIA는 고객에게 생성형 AI 서비스를 제공하고자 하는 클라우드 제공업체를 위한 새로운 레퍼런스 아키텍처를 발표했습니다.

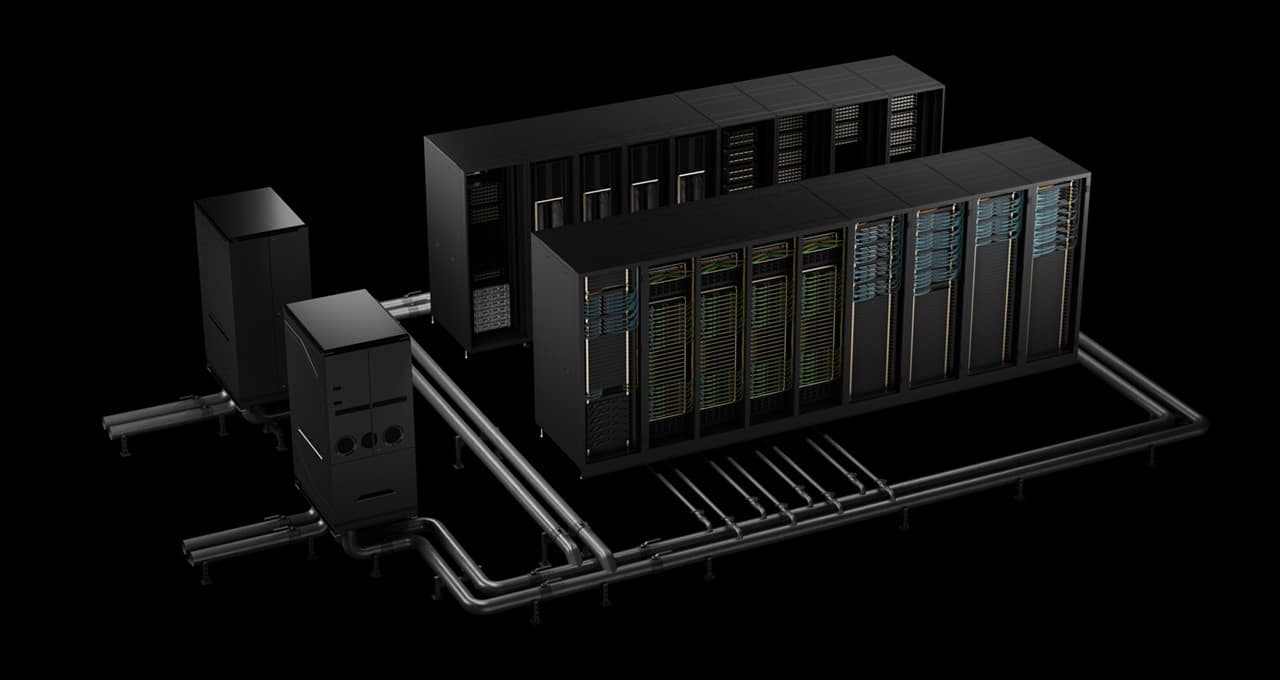

NVIDIA 클라우드 파트너 레퍼런스 아키텍처는 생성형 AI와 거대 언어 모델(LLM)을 처리할 수 있는 고성능, 확장성, 보안성을 갖춘 데이터센터를 구축하기 위한 청사진입니다.

이 레퍼런스 아키텍처를 통해 NVIDIA 파트너 네트워크에 속한 NVIDIA 클라우드 파트너는 다양한 하드웨어 및 소프트웨어 구성 요소 간의 호환성 및 상호 운용성을 보장하면서 AI 솔루션을 배포하는 데 드는 시간과 비용을 줄일 수 있습니다.

또한 이 아키텍처는 클라우드 제공업체가 자체 인프라에 투자하지 않고도 생성형 AI와 LLM의 성능을 활용하고자 하는 모든 규모와 업종의 조직에서 증가하는 AI 서비스에 대한 수요를 충족시키는 데 도움이 될 것입니다.

생성형 AI와 LLM은 조직이 복잡한 문제를 해결하고 새로운 가치를 창출하는 방식을 혁신하고 있습니다. 이러한 기술은 딥 뉴럴 네트워크를 사용하여 주어진 입력 또는 컨텍스트를 기반으로 텍스트, 이미지, 오디오 및 비디오와 같은 사실적이고 새로운 결과물을 생성합니다. 생성형 AI와 LLM은 코파일럿, 챗봇, 그리고 기타 콘텐츠 제작과 같은 다양한 애플리케이션에 사용할 수 있습니다.

그러나 생성형 AI와 LLM은 이러한 워크로드를 지원하기 위한 인프라와 소프트웨어를 제공해야 하는 클라우드 제공업체에게도 상당한 과제를 안겨줍니다. 이러한 기술에는 막대한 양의 컴퓨팅 성능, 스토리지 및 네트워크 대역폭은 물론 성능과 효율성을 최적화하기 위한 특수한 하드웨어와 소프트웨어가 필요합니다.

예를 들어, LLM 트레이닝에는 많은 GPU 서버가 함께 작동하며 서로 간에 그리고 스토리지 시스템과 지속적으로 통신합니다. 이는 데이터 센터의 동서 및 남북 트래픽으로 이어지며, 빠르고 효율적인 통신을 위해 고성능 네트워크가 필요합니다.

마찬가지로, 대규모 모델을 사용하는 생성형 AI 추론은 단일 쿼리를 처리하기 위해 여러 개의 GPU가 함께 작동해야 합니다.

또한 클라우드 제공업체는 다양한 니즈와 기대치를 가진 여러 고객에게 서비스를 제공하기 때문에 인프라가 안전하고 안정적이며 확장 가능한지 확인해야 합니다. 또한 클라우드 제공업체는 업계 표준과 모범 사례를 준수하고 서비스에 대한 지원과 유지보수를 제공해야 합니다.

NVIDIA 클라우드 파트너 레퍼런스 아키텍처는 클라우드 제공업체가 다양한 활용 사례를 위한 AI 서비스와 워크플로우를 제공할 수 있도록 포괄적인 풀스택 하드웨어 및 소프트웨어 솔루션을 제공하여 이러한 과제를 해결합니다. 내부적으로나 고객을 위해 대규모 배포를 설계하고 구축한 수 년간의 경험을 바탕으로 한 이 레퍼런스 아키텍처에는 다음이 포함됩니다:

- AI 워크로드를 위한 탁월한 컴퓨팅 파워와 성능을 제공하는 NVIDIA의 최신 GPU 아키텍처(예: Hopper와 Blackwell)가 탑재된 NVIDIA 및 제조 파트너의 GPU 서버.

- 인증된 파트너의 스토리지 제품: AI와 LLM 워크로드에 최적화된 고성능 스토리지를 제공합니다. 이 제품에는 NVIDIA DGX SuperPOD와 NVIDIA DGX 클라우드에 대한 테스트와 검증을 거친 제품도 포함됩니다. 안정성과 효율성, 확장성이 입증된 제품입니다.

- GPU 서버 간의 빠르고 효율적인 통신을 위한 고성능 동서 네트워크를 제공하는 NVIDIA Quantum-2 InfiniBand와 Spectrum-X 이더넷 네트워킹.

- 고성능 남북 네트워크 연결을 제공하고 데이터 스토리지 가속화, 탄력적인 GPU 컴퓨팅 및 제로 트러스트 보안을 지원하는 NVIDIA BlueField-3 DPU.

- AI 데이터센터 인프라를 프로비저닝, 모니터링 및 관리하기 위한 도구와 서비스를 제공하는 NVIDIA 및 관리 파트너의 인/아웃오브밴드 관리 솔루션.

- 다음을 포함한 NVIDIA AI 엔터프라이즈 소프트웨어

- 클라우드 제공업체가 서버를 프로비저닝하고 관리하는 데 도움이 되는 NVIDIA Base Command Manager Essentials.

- 클라우드 제공업체가 생성 AI 모델을 트레이닝하고 미세 조정하는 데 도움이 되는 NVIDIA NeMo 프레임워크.

- 기업 전반에서 생성형 AI의 배포를 가속화하도록 설계된 사용하기 쉬운 마이크로서비스 세트인 NVIDIA NIM.

- 음성 서비스용 NVIDIA Riva.

- Spark 워크로드 가속화를 위한 Spark용 NVIDIA RAPIDS 가속기.

NVIDIA 클라우드 파트너 레퍼런스 아키텍처는 클라우드 공급업체에게 다음과 같은 주요 이점을 제공합니다:

- 구축, 훈련, 그리고 이동: NVIDIA 인프라 전문가는 이 아키텍처를 사용하여 클러스터를 물리적으로 설치하고 프로비저닝하여 클라우드 제공업체의 빠른 롤아웃을 지원합니다.

- 속도: 이 아키텍처는 NVIDIA 및 파트너 공급업체의 전문 지식과 모범 사례를 통합하여 클라우드 공급업체가 AI 솔루션 배포를 가속화하고 시장에서 경쟁 우위를 확보할 수 있도록 지원합니다.

- 고성능: 아키텍처는 업계 표준 벤치마크를 통해 조정 및 벤치마킹되어 AI 워크로드를 위한 최적의 성능을 보장합니다.

- 확장성: 이 아키텍처는 클라우드 네이티브 환경을 위해 설계되어 유연성을 제공하고 최종 사용자의 증가하는 수요에 맞춰 원활하게 확장할 수 있는 확장 가능한 AI 시스템 개발을 용이하게 합니다.

- 상호 운용성: 아키텍처의 다양한 구성 요소 간의 호환성을 보장하여 구성 요소 간의 통합과 커뮤니케이션이 원활하게 이루어집니다.

- 유지 관리 및 지원: NVIDIA 클라우드 파트너는 배포 중 및 배포 후에 발생할 수 있는 예기치 않은 문제를 해결하는 데 도움을 줄 수 있는 NVIDIA 전문가에 문의할 수 있습니다.

NVIDIA 클라우드 파트너 레퍼런스 아키텍처는 클라우드 제공업체가 AI 데이터센터를 위한 확장 가능한 고성능 인프라를 구축하고 관리할 수 있는 입증된 청사진을 제공합니다.

소프트웨어 제품 정보에 관한 공지를 참조하세요.