생성형 AI 기반의 노트북과 PC로 인해 게임, 콘텐츠 제작, 생산성, 개발 등에서 눈부신 발전이 이루어지고 있습니다. 오늘날 600여 개의 Windows 앱과 게임들이 전 세계에서 이미 1억 대 이상의 GeForce RTX AI PC를 사용하여 로컬에서 AI를 실행하면서 빠르고 안정적인 저지연 성능을 제공하고 있습니다.

Microsoft Ignite에서 NVIDIA와 Microsoft는 Windows 개발자가 RTX AI PC에서 AI 기반의 앱을 신속히 구축하여 최적화하는 데 유용한 여러 도구를 발표했으며, 이는 로컬 AI를 더 쉽게 이용하는 데 도움이 됩니다. 이러한 새로운 도구 덕분에 애플리케이션 및 게임 개발자는 강력한 RTX GPU를 활용하여 AI 에이전트, 앱 비서, 디지털 휴먼 등의 애플리케이션을 위한 복잡한 AI 워크플로우를 가속화할 수 있습니다.

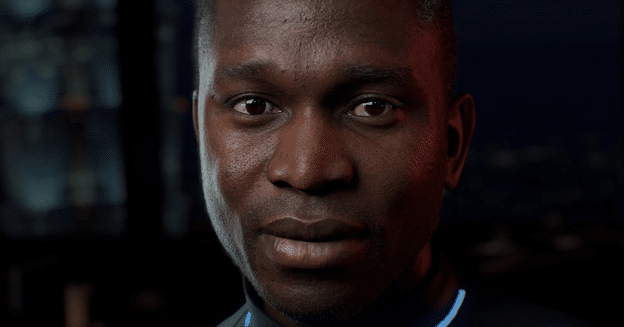

RTX AI PC가 멀티 모달 소형 언어 모델로 디지털 휴먼 지원

NVIDIA ACE는 에이전트, 비서, 아바타 등에 생명을 불어넣는 일련의 디지털 휴먼 기술입니다. 디지털 휴먼이 이해의 수준을 더 높여 훨씬 더 정확한 맥락으로 응답하기 위해서는 세상을 시각적으로 사람처럼 인식할 수 있어야 합니다.

디지털 휴먼 인터랙션을 더욱 사실적으로 향상하려면 보다 섬세한 뉘앙스로 주변을 인식하고 이해할 수 있게 해주는 기술이 필요합니다. 이를 달성하기 위해 NVIDIA는 텍스트와 이미지를 모두 처리할 수 있고, 롤플레잉에 뛰어나며, 빠른 응답 시간에 최적화된 멀티 모달 소형 언어 모델을 개발했습니다.

곧 출시 예정인 NVIDIA Nemovision-4B-Instruct 모델은 최신 NVIDIA VILA 및 NVIDIA NeMo 프레임워크를 사용하여 정제하고, 가지치기하며, 양자화함으로써 개발자들이 원하는 정확성은 유지하면서 RTX GPU에서 실행되기에 충분할 만큼 용량을 줄입니다. 이 모델을 사용하는 디지털 휴먼은 실제 세상과 화면의 시각적 이미지를 이해하여 적절한 응답을 제공할 수 있습니다. 멀티 모달 기능은 에이전트형 워크플로우의 기반 역할을 하며 미래를 살짝 엿보게 해줍니다. 즉, 미래에는 디지털 휴먼이 사용자에게 최소한의 도움만 받으면서 스스로 판단하고 행동할 수 있습니다.

NVIDIA가 소개하는 또 다른 Mistral NeMo Minitron 128k Instruct는 더 넓은 범위의 맥락을 이해할 수 있는 일련의 소형 언어 모델로서, 효율적이고 최적화된 디지털 휴먼 인터랙션을 위해 설계되었으며 곧 출시될 예정입니다. 매개변수가 80억, 40억 또는 20억 개인 버전으로 제공되는 이러한 모델은 RTX AI PC에서 속도와 메모리 사용량 및 정확성 간에 균형을 맞출 수 있도록 유연한 옵션을 제공합니다. 이러한 모델은 대규모 데이터세트를 단일 패스로 처리할 수 있으므로 데이터를 분할했다가 다시 조립할 필요가 없습니다. GGUF 형식으로 구축된 이들 모델은 저전력 장치에서 효율성을 향상하고 여러 프로그래밍 언어와 호환될 수 있게 해줍니다.

Windows용 NVIDIA TensorRT Model Optimizer로 생성형 AI 성능 강화

PC 환경에 모델을 도입할 때 개발자들은 AI를 로컬로 실행하기에 메모리와 컴퓨팅 리소스가 제한적이라는 문제를 겪습니다. 이들은 또한 정확성 손실을 최소화하면서 모델을 최대한 많은 사람들에게 제공하고 싶어 합니다.

최근 NVIDIA가 발표한 NVIDIA TensorRT Model Optimizer(ModelOpt) 업데이트는 Windows 개발자들에게 ONNX Runtime 배포를 위해 모델을 최적화하는 더욱 향상된 방법을 제공합니다.

최신 업데이트가 적용된 TensorRT ModelOpt는 모델이 CUDA, TensorRT, DirectML 등의 GPU 실행 프로바이더를 사용하여 ONNX 런타임 환경에 배포되도록 개발자들이 모델을 ONNX 체크포인트로 최적화할 수 있게 해줍니다.

TensorRT-ModelOpt에는 INT4-Activation Aware Weight Quantization(AWQ)과 같은 고급 양자화 알고리즘이 포함되어 있습니다. Olive 등의 다른 도구와 비교할 때 이 새로운 방법은 모델의 메모리 사용량을 더욱 줄이고 RTX GPU에서 처리 성능을 향상해 줍니다.

배포 과정에서 이 모델은 메모리 사용량을 FP16 모델에 비해 최대 2.6배 줄일 수 있습니다. 그 결과 정확성 저하는 최소화하면서 처리 속도를 높일 수 있어 더욱 광범위한 PC에서 실행할 수 있습니다.

Windows RTX AI PC부터 NVIDIA Blackwell 기반의 Azure 서버까지, Microsoft 시스템에서 개발자들이 어떻게 사용자들의 일상적인 AI 상호 작용 방식을 혁신하고 있는지 자세한 내용을 확인해 보세요.