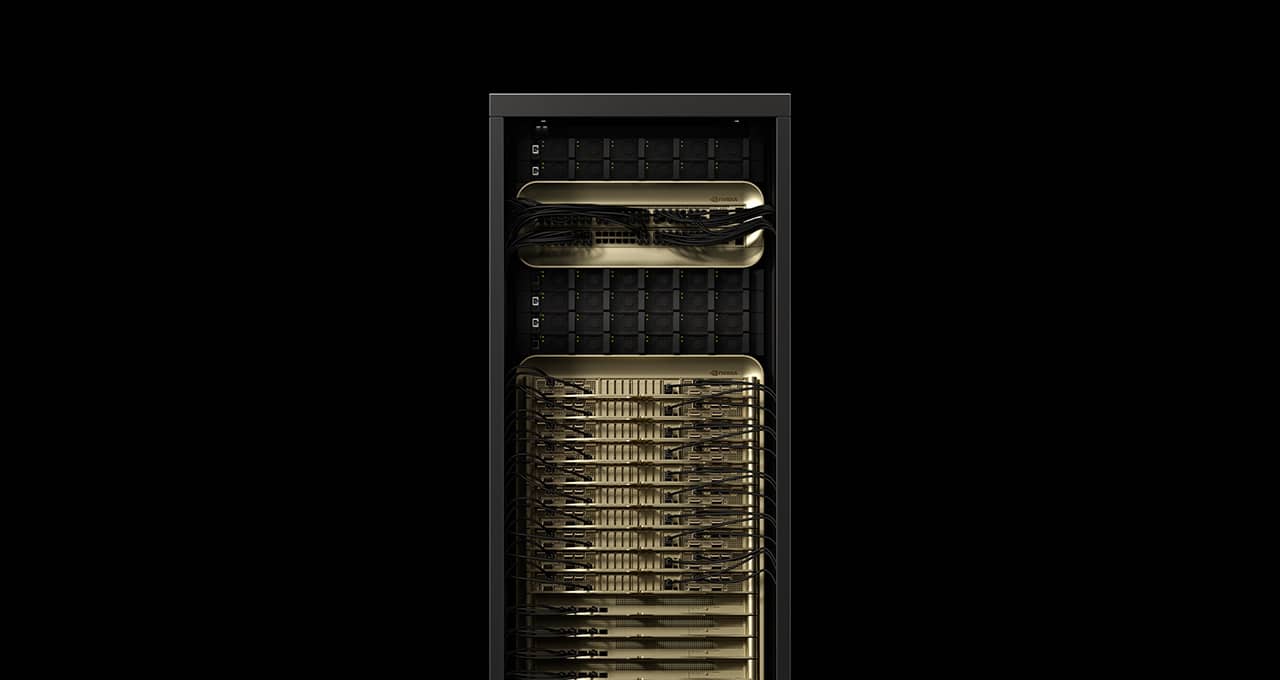

가장 까다로운 추론 시나리오를 기반으로 평가하는 최신 MLPerf 추론 V5.0 벤치마크에서 NVIDIA Blackwell 플랫폼이 놀라운 기록을 세웠습니다! 랙 규모의 솔루션이자, AI 추론을 위해 특별히 설계된 NVIDIA GB200 NVL72 시스템은 NVIDIA 최초의 MLPerf 출품작으로 기록되었습니다.

오늘 날에는 최첨단 AI 기술 혁신을 이루기 위해서는 AI 팩토리라는 새로운 종류의 컴퓨팅 인프라가 필요한데요, 기존 데이터센터와 달리 AI 팩토리는 단순히 데이터를 저장하고 처리하는 데 그치지 않고 원시 데이터를 실시간 인사이트로 변환시켜 대규모로 인텔리전스를 생산하게 됩니다. 여기서 AI 팩토리의 목표는 간단한데요. 바로 쿼리에 대한 정확한 답변을 가장 낮은 비용으로 최대한 많은 사용자에게 신속하게 제공하는 것이죠.

하지만 이를 실현하기 위해서는 상당한 복잡성이 뒤따르는데요. 더 스마트한 답변을 제공하기 위해 AI 모델이 수십억, 수조 개의 파라미터로 성장함에 따라 각 토큰을 생성하는 데 필요한 컴퓨팅이 증가합니다. 이러한 요구 사항은 AI 팩토리에서 생성할 수 있는 토큰의 수를 줄이고 토큰당 비용을 증가시키게 되는데요, 추론 처리량을 높이고 토큰당 비용을 낮게 유지하려면 실리콘, 네트워크 시스템, 소프트웨어 등 전체 기술 스택에 걸쳐서 빠른 혁신이 필요로 하게 됩니다.

추론 성능에 대한 업계 벤치마크 중 하나인 MLPerf Inference의 최신 업데이트에는 가장 크고 실행하기 까다로운 오픈 웨이트 모델 중 하나인 Llama 3.1 405B가 추가되었는데요, 새로운 Llama 2 70B 인터랙티브 벤치마크는 기존 Llama 2 70B 벤치마크에 비해 훨씬 더 엄격한 지연 시간 요구 사항을 적용하였습니다. 이는 최상의 사용자 경험 제공을 위해 프로덕션 배포의 제약 조건을 보다 더 반영하기 위해 업데이트가 이루어졌기 때문입니다.

Blackwell 플랫폼과 더불어 NVIDIA Hopper 플랫폼은 전반적으로 뛰어난 성능을 보여주었으며, 풀스택 최적화 덕분에 지난해에 비해 Llama 2 70B에서 성능이 크게 향상되었습니다.

NVIDIA Blackwell, 신기록을 세우다

72개의 NVIDIA Blackwell GPU를 연결하여 하나의 거대한 GPU처럼 작동하는 GB200 NVL72 시스템은 이번 라운드에 제출된 NVIDIA H200 NVL8보다 Llama 3.1 405B 벤치마크에서 최대 30배 더 높은 연산량을 기록했습니다. 이 성과는 GPU당 3배 이상의 성능과 9배 더 큰 NVIDIA NVLink 인터커넥트 도메인을 통해 달성되었죠.

많은 기업들이 성능을 측정하기 위해 하드웨어에서 MLPerf 벤치마크를 실행했지만, 오직 NVIDIA와 그 파트너사만이 Llama 3.1 405B 벤치마크에 대한 결과를 제출하고 발표했습니다.

프로덕션 추론 배포에는 두 가지 주요 지표에 대한 지연 시간 제약이 있는 경우가 많습니다. 첫 번째는 첫 번째 토큰에 도달하는 시간(TTFT), 즉 사용자가 거대 언어 모델에 주어진 쿼리에 대한 응답을 보기 시작하는 데 걸리는 시간입니다. 두 번째는 출력 토큰당 시간(TPOT), 즉 토큰이 사용자에게 얼마나 빨리 전달되는지입니다.

새로운 Llama 2 70B 인터랙티브 벤치마크는 TPOT가 5배 더 짧고 TTFT가 4.4배 더 낮아 더욱 반응성이 뛰어난 사용자 환경을 모델링하는데요, 이 테스트에서 NVIDIA는 8개의 Blackwell GPU가 탑재된 NVIDIA DGX B200 시스템을 사용해 제출한 결과, 8개의 NVIDIA H200 GPU를 사용한 것보다 3배 높은 성능을 기록하여 이보다 까다로운 버전의 Llama 2 70B 벤치마크에서 높은 기록을 세웠습니다.

이처럼 Blackwell 아키텍처와 최적화된 소프트웨어 스택의 결합은 새로운 수준의 추론 성능을 제공하여 AI 팩토리가 더 높은 지능, 향상된 연산량, 그리고 더 빠른 토큰 속도를 제공할 수 있는 기반을 마련해줍니다.

NVIDIA Hopper AI 팩토리 가치의 지속적 증가

2022년에 도입된 NVIDIA Hopper 아키텍처는 현재 전 세계의 많은 AI 추론 팩토리들을 구동하고 있으며, 모델 트레이닝 역시 지속적으로 지원하고 있습니다. 지속적인 소프트웨어 최적화를 통해 NVIDIA는 Hopper 기반 AI 팩토리의 연산량을 늘려 더 큰 가치를 창출하고 있습니다.

1년 전 MLPerf 추론 v4.0에서 처음 소개된 Llama 2 70B 벤치마크에서 H100 GPU 연산량은 이전 대비 1.5배 증가했습니다. 더 크고 빠른 GPU 메모리를 갖춘 동일한 Hopper GPU 아키텍처에 기반한 H200 GPU는 그 증가폭을 1.6배로 확장했죠.

또한 Hopper 는 새로 추가된 Llama 3.1 405B, Llama 2 70B 인터랙티브 및 그래프 신경망 테스트를 포함한 모든 벤치마크를 진행했습니다. 이러한 다용도성 덕분에 Hopper는 다양한 워크로드를 실행할 수 있으며 모델과 사용 시나리오가 점점 더 까다로워짐에 따라 이에 보조를 맞출 수 있습니다.

놀라운 생태계

이번 MLPerf 라운드에는 ASUS, Cisco, CoreWeave, Dell Technologies, Fujitsu, Giga Computing, Google Cloud, Hewlett Packard Enterprise, Lambda, Lenovo, Oracle Cloud Infrastructure, Quanta Cloud Technology, Supermicro, Sustainable Metal Cloud, 그리고 VMware까지 무려 15개 파트너가 NVIDIA 플랫폼에서 뛰어난 결과를 선보였는데요,

전 세계 모든 클라우드 서비스 제공업체와 서버 제조업체에서 사용할 수 있는 NVIDIA 플랫폼의 광범위한 적용 범위를 반증하는 결과이기도 합니다.

최신 AI 개발에 발맞추고 생태계에 엄격한 벤치마크를 거친 성능 데이터를 제공하기 위해 MLPerf 추론 벤치마크 제품군을 지속적으로 발전시키는 MLCommons의 노력은 IT 의사 결정권자가 최적의 AI 인프라를 선택하는 데 필수적입니다.

MLPerf에 대해 자세히 알아보세요.

실리콘밸리의 Equinix 데이터 센터에서 촬영한 이미지 및 비디오.