NVIDIA Grace CPU, NVIDIA 네트워킹과 인프라를 갖춘 다양한 NVIDIA Blackwell 아키텍처 기반 시스템을 공개합니다! 이는 세계 최고의 컴퓨터 제조업체들과 협력해 차세대 생성형 AI 혁신을 주도할 AI 팩토리와 데이터센터 구축을 위해 기업들이 사용할 수 있죠.

컴퓨텍스(COMPUTEX) 키노트에서 NVIDIA 창립자 겸 CEO 젠슨 황(Jensen Huang)은 다음의 기업들이 NVIDIA GPU와 네트워킹을 사용해 클라우드, 온프레미스, 임베디드와 엣지 AI 시스템을 제공한다고 발표했습니다.

애즈락 랙(ASRock Rack), 에이수스(ASUS), 기가바이트(GIGABYTE), 인그라시스(Ingrasys), 인벤텍(Inventec), 페가트론(Pegatron), QCT, 슈퍼마이크로(Supermicro), 위스트론(Wistron), 위윈(Wiwynn)

젠슨 황 CEO는 “차세대 산업 혁명이 시작됐습니다. 수조 달러 규모의 기존 데이터센터를 가속 컴퓨팅으로 전환하고 새로운 유형의 데이터센터인 AI 팩토리를 구축해 새로운 상품인 인공지능(AI)을 생산하기 위해 기업과 국가들이 NVIDIA와 협력하고 있습니다. 서버, 네트워킹, 인프라 제조업체부터 소프트웨어 개발자에 이르기까지, 업계 전체가 Blackwell을 통해 모든 분야에서 AI 기반 혁신을 가속화할 준비를 하고 있습니다”고 말했습니다.

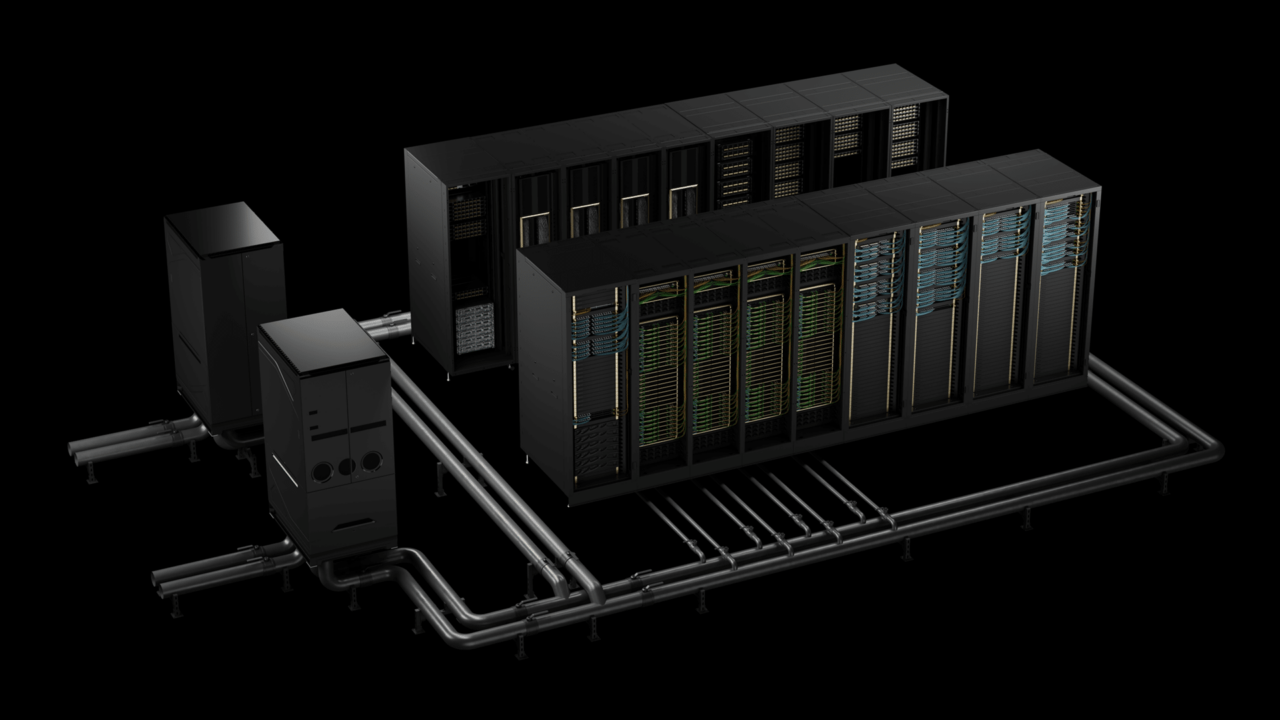

모든 유형의 애플리케이션에 대응하기 위해 단일 GPU부터 멀티 GPU, x86 기반 프로세서부터 Grace 기반 프로세서, 공냉식부터 수냉식 기술까지 다양한 제품을 제공할 예정입니다.

또한 다양한 크기와 구성의 시스템 개발 속도를 높이기 위해 NVIDIA MGX™ 모듈형 레퍼런스 디자인 플랫폼은 이제 NVIDIA Blackwell 제품을 지원합니다. 여기에는 메인스트림 거대 언어 모델(LLM) 추론, 검색 증강 생성과 데이터 처리를 위한 탁월한 성능을 제공하도록 설계된 새로운 NVIDIA GB200 NVL2 플랫폼이 포함되죠.

GB200 NVL2는 기업들이 매년 수백억 달러를 지출하는 데이터 분석과 같은 신흥 시장 기회에 적합하게 설계됐습니다. NVLink®-C2C 인터커넥트와 Blackwell 아키텍처의 전용 압축 해제 엔진이 제공하는 고대역폭 메모리 성능을 활용하면 데이터 처리 속도가 최대 18배 빨라지고, x86 CPU를 사용할 때보다 에너지 효율이 8배 향상됩니다.

가속 컴퓨팅을 위한 모듈식 레퍼런스 아키텍처

NVIDIA MGX는 컴퓨터 제조업체에 100가지 이상의 시스템 디자인 구성을 빠르고 비용 효율적으로 구축할 수 있는 레퍼런스 아키텍처를 제공한다. 이는 전 세계 데이터센터의 다양한 가속 컴퓨팅 요구 사항을 충족하기 위함 입니다.

제조업체는 서버 섀시를 위한 기본 시스템 아키텍처로 시작한 다음 다양한 워크로드를 처리하기 위해 GPU, DPU, CPU를 선택합니다. 현재까지 25개 이상의 파트너사에서 90개 이상의 시스템이 출시됐거나 개발 중이며, 이는 작년 6개 파트너사의 14개 시스템에서 증가한 수치이죠. MGX를 사용하면 개발 비용을 최대 4분의 3까지 절감하고 개발 시간을 최대 3분의 2 줄인 6개월까지 단축할 수 있습니다.

AMD와 인텔(Intel)은 처음으로 자체 CPU 호스트 프로세서 모듈 설계를 제공할 계획으로 MGX 아키텍처를 지원하고 있습니다. 여기에는 차세대 AMD 튜린(Turin) 플랫폼과 이전에 그래나이트 래피즈(Granite Rapids)라는 코드명으로 더 익숙했던 인텔® 제온(Xeon)® 6 프로세서의 P-코어가 포함되는데요. 모든 서버 시스템 빌더는 이러한 레퍼런스 디자인을 사용해 개발 시간을 절약하는 동시에 설계와 성능의 일관성을 보장할 수 있습니다.

NVIDIA 최신 플랫폼인 GB200 NVL2 역시 MGX와 Blackwell을 활용합니다. 스케일아웃, 단일 노드 설계를 통해 다양한 시스템 구성과 네트워킹 옵션을 지원해 가속 컴퓨팅을 기존 데이터센터 인프라에 원활하게 통합할 수 있습니다.

GB200 NVL2는 NVIDIA Blackwell Tensor 코어 GPU, GB200 Grace Blackwell Superchip, GB200 NVL72를 포함하는 Blackwell 제품 라인업에 합류했습니다.

통합 에코시스템

NVIDIA의 포괄적인 파트너 에코시스템에는 세계 최고의 반도체 제조업체이자 NVIDIA 파운드리 파트너인 TSMC를 비롯해 AI 팩토리 구축을 위한 핵심 구성요소를 제공하는 글로벌 전자제품 제조업체가 포함됩니다. 여기에는 서버 랙, 전원 공급 장치, 냉각 솔루션 등 제조 혁신 기술을 보유한 암페놀(Amphenol), 아시아 바이털 컴포넌트(Asia Vital Components, AVC), 쿨러 마스터(Cooler Master), CPC(Colder Products Company), 댄포스(Danfoss), 델타 일렉트로닉스(Delta Electronics), 라이트온(LITEON) 등의 회사가 포함됩니다.

그 결과, 전 세계 기업의 요구를 충족하는 새로운 데이터센터 인프라를 신속하게 개발하고 배포할 수 있으며, 선도적인 시스템 제조업체인 델 테크놀로지스(Dell Technologies), 휴렛 팩커드 엔터프라이즈(Hewlett Packard Enterprise, HPE), 레노버(Lenovo)의 서버에서 Blackwell 기술, NVIDIA Quantum-2 또는 Quantum-X800 InfiniBand 네트워킹, NVIDIA Spectrum™-X 이더넷 네트워킹, NVIDIA BlueField®-3 DPU로 더욱 가속화할 수 있게 됐습니다.

또한 기업들은 NVIDIA NIM™ 추론 마이크로서비스가 포함된 NVIDIA AI Enterprise 소프트웨어 플랫폼을 활용해 프로덕션급 생성형 AI 애플리케이션을 제작하고 실행할 수 있습니다.

대만 기업들의 Blackwell 도입

젠슨 황 CEO는 키노트에서 대만의 선도 기업들이 AI의 힘을 자사 비즈니스에 활용하기 위해 Blackwell을 빠르게 도입하고 있다고 발표했습니다.

대만의 대표적인 의료기관인 CGMH(Chang Gung Memorial Hospital)은 NVIDIA Blackwell 컴퓨팅 플랫폼을 사용해 생물의학 연구를 발전시키고, 영상과 언어 애플리케이션을 가속화해 임상 워크플로우를 개선하며, 궁극적으로 환자 치료를 향상시킬 계획입니다.

세계 최대 전자제품 제조업체 중 하나인 폭스콘(Foxconn)은 NVIDIA Grace Blackwell을 사용해 AI 기반 전기 자동차와 로봇 플랫폼을 위한 스마트 솔루션 플랫폼을 개발하고, 고객에게 보다 개인화된 경험을 제공하기 위한 언어 기반 생성형 AI 서비스를 확대할 계획입니다.

NVIDIA Blackwell과 MGX 플랫폼에 대한 보다 자세한 내용은 젠슨 황 CEO의 컴퓨텍스 키노트에서 확인할 수 있습니다.

NVIDIA 기술에 대한 기업들의 인용

- 암페놀 대표 겸 CEO인 아담 노위트(R. Adam Norwitt): “NVIDIA의 획기적인 AI 시스템에는 최신 인터커넥트 솔루션이 필요하며, 암페놀은 핵심 부품을 공급하게 된 것을 자랑스럽게 생각합니다. NVIDIA의 풍부한 에코시스템의 중요한 파트너로서 우리는 Blackwell 가속기를 위한 매우 복잡하고 효율적인 인터커넥트 제품을 제공해 최첨단 성능을 제공할 수 있습니다.”

- AVC 회장 겸 CEO인 스펜서 셴(Spencer Shen): “최신 Grace Blackwell Superchip을 비롯한 AI 하드웨어에 효율적인 냉각을 제공하는 AVC는 NVIDIA 제품에서 핵심적인 역할을 담당하고 있습니다. AI 모델과 워크로드가 계속 증가함에 따라 집약적인 AI 컴퓨팅을 처리하기 위해서는 안정적인 열 관리가 중요하며, 우리는 모든 단계에서 NVIDIA와 함께하고 있습니다.”

- 에이수스 회장인 조니 시(Jonney Shih): “에이수스는 컴퓨텍스에서 선보일 강력한 서버 라인업을 통해 엔터프라이즈 AI를 새로운 차원으로 끌어올리기 위해 NVIDIA와 협력하고 있습니다. NVIDIA의 MGX와 Blackwell 플랫폼을 사용해 교육, 추론, 데이터 분석, HPC 전반에 걸쳐 고객의 워크로드를 처리하도록 구축된 맞춤형 데이터센터 솔루션을 구축할 수 있습니다.”

- 도버 코퍼레이션(Dover Corporation)의 CPC 대표인 자넬 위트마이어(Janel Wittmayer): “CPC의 혁신적인 특수 커넥터 기술은 AI 시스템에서 수냉식 NVIDIA GPU를 쉽고 안정적으로 연결할 수 있게 해줍니다. 성능과 품질에 대한 비전을 공유하는 CPC는 NVIDIA의 놀라운 성장과 발전을 뒷받침하는 핵심 기술 부품을 공급할 수 있는 역량과 전문성을 갖추고 있습니다. CPC의 커넥터는 온도에 민감한 제품의 무결성을 유지하는 데 핵심적인 역할을 하며, 이는 AI 시스템이 컴퓨팅 집약적인 작업을 실행할 때 중요합니다. NVIDIA 에코시스템의 일원이 돼 새로운 애플리케이션에 우리의 기술을 제공하게 돼 기쁘게 생각합니다.”

- 쿨러 마스터 CEO 앤디 린(Andy Lin): “가속 컴퓨팅에 대한 수요가 계속 급증함에 따라 최첨단 가속기를 활용하는 기업을 위한 에너지 표준을 효과적으로 충족하는 솔루션에 대한 수요도 증가하고 있습니다. 열 관리 솔루션의 선구자인 쿨러 마스터는 고객에게 놀라운 성능을 제공할 수 있는 NVIDIA Blackwell 플랫폼의 잠재력을 최대한 발휘할 수 있도록 돕고 있습니다.”

- 댄포스 CEO 킴 파우징(Kim Fausing): “댄포스의 혁신적인 고성능 퀵 디스커넥트와 유체 동력 설계에 중점을 둔 커플링은 데이터센터의 효율적이고 안정적이며 안전한 운영에 일조하고 있습니다. NVIDIA AI 에코시스템의 중요한 일원으로서 환경에 미치는 영향을 최소화하면서 급증하는 AI 수요를 충족할 수 있는 데이터센터를 구현하기 위해 협업하고 있습니다.”

- 델타 일렉트로닉스 CEO 핑 쳉(Ping Cheng): “컴퓨팅 성능에 대한 광범위한 수요는 새로운 가속 성능 시대를 열었습니다. 델타는 첨단 냉각과 전력 시스템을 통해 NVIDIA의 Blackwell 플랫폼이 에너지와 열 효율을 유지하면서 최고 성능 수준으로 작동할 수 있는 혁신적인 솔루션을 개발했습니다.”

- 기가바이트 부사장 겸 총괄 매니저 이테이 리(Etay Lee): “거의 30년에 걸친 협력을 통해 기가바이트는 GPU, CPU, DPU, 고속 네트워킹 전반에 걸쳐 NVIDIA 기술을 지원하기 위해 최선을 다하고 있습니다. 기업들이 컴퓨팅 집약적인 워크로드에서 더욱 뛰어난 성능과 에너지 효율성을 달성할 수 있도록 다양한 Blackwell 기반 시스템을 시장에 출시하고 있습니다.”

- 혼하이 테크놀로지 그룹(Hon Hai Technology Group) 회장 겸 CEO인 류양웨이(Young Liu): “생성형 AI가 산업을 혁신함에 따라 폭스콘은 가장 다양하고 까다로운 컴퓨팅 요구 사항을 충족할 수 있는 최첨단 솔루션을 준비하고 있습니다. 우리는 자체 서버에 최신 Blackwell 플랫폼을 사용할 뿐만 아니라 NVIDIA에 핵심 구성요소를 제공해 고객의 시장 출시 기간을 단축하고 있습니다”

- 인벤텍 대표 잭 차이(Jack Tsai): “거의 반세기 동안 인벤텍은 전자 제품과 부품을 설계하고 제조해 왔으며, 이는 우리의 핵심 사업입니다. NVIDIA Grace Blackwell Superchip으로 구동되는 NVIDIA MGX 랙 기반 솔루션을 통해 인벤텍은 고객이 새로운 AI 역량과 성능의 영역으로 진입할 수 있도록 돕고 있습니다.”

- 라이트온 테크놀로지 대표 앤슨 치우(Anson Chiu): “보다 친환경적이고 지속 가능한 데이터센터를 추구하는 트렌드에 따라 전력 관리와 냉각 솔루션이 주목받고 있습니다. NVIDIA Blackwell 플랫폼의 출시와 함께 라이트온은 NVIDIA 파트너들이 고효율, 친환경 데이터센터의 미래를 열어갈 수 있도록 다양한 액체 냉각 솔루션을 출시하고 있습니다.”

- 콴타 컴퓨터 회장 배리 램(Barry Lam): “우리는 전례 없이 혁신이 가속화되고 있는 AI 기반 세상의 중심에 서 있습니다. NVIDIA Blackwell은 단순한 엔진이 아니라 이 산업 혁명에 불을 붙이는 불꽃입니다. 차세대 생성형 AI의 시대를 정의하는 이 놀라운 여정에 콴타가 NVIDIA와 함께 할 수 있는 것이 자랑스럽습니다. 우리는 함께 AI의 새로운 장을 형성하고 정의할 것입니다.”

- 슈퍼마이크로 대표 겸 CEO인 찰스 리앙(Charles Liang): “슈퍼마이크로의 빌딩 블록 아키텍처와 랙 규모의 수냉식 솔루션은 자사의 엔지니어링 역량과 월 5,000개의 랙을 생산하는 글로벌 생산 능력과 결합해 전 세계 AI 팩토리에 다양한 NVIDIA AI 플랫폼 기반 제품을 신속하게 제공할 수 있게 해줍니다. NVIDIA Blackwell 아키텍처 기반의 모든 제품에 최적화된 랙 스케일 디자인의 수냉식 또는 공냉식 고성능 시스템을 통해 고객은 차세대 컴퓨팅에 대한 요구 사항을 충족할 수 있는 놀라운 플랫폼 선택권을 갖게 될 뿐만 아니라 AI의 미래를 향한 큰 도약을 이룰 수 있습니다.”

- TSMC CEO C.C. 웨이: “TSMC는 NVIDIA와 긴밀히 협력해 반도체 혁신의 한계를 뛰어넘어 AI 비전을 실현하기 위해 노력하고 있습니다. TSMC의 업계 최고 반도체 제조 기술은 Blackwell 아키텍처 기반 GPU를 비롯한 NVIDIA의 획기적인 GPU를 만드는 데 기여했습니다.”

- 위스트론 CEO 제프 린(Jeff Lin): “NVIDIA의 핵심 제조 파트너인 위스트론은 GPU 컴퓨팅 기술과 AI 클라우드 솔루션을 고객에게 제공하는 놀라운 여정을 함께 해왔습니다. 이제 우리는 Blackwell, MGX와 같은 NVIDIA의 최신 GPU 아키텍처와 레퍼런스 설계를 통해 엄청난 새로운 AI 컴퓨팅 제품을 시장에 빠르게 출시할 수 있게 됐습니다.”

- 위윈 대표 윌리엄 린(William Lin): “위윈은 생성형 AI 시대에 대규모 컴퓨팅 성능과 고급 냉각 솔루션에 대한 고객의 수요 증가에 대응하는 데 주력하고 있습니다. NVIDIA Grace Blackwell과 MGX 플랫폼 기반의 최신 라인업을 통해 하이퍼스케일 클라우드 제공업체와 기업의 까다로운 워크로드에 맞게 최적화된 랙 수준의 수냉식 AI 서버를 구축하고 있습니다.”