코어위브(CoreWeave)가 NVIDIA GB200 NVL72 시스템을 대규모 고객 대상으로 온라인에 제공한 최초의 클라우드 제공업체 중 하나가 됐습니다. AI 선도기업인 코히어(Cohere), IBM, 미스트랄 AI(Mistral AI)는 이미 이 시스템을 활용해 차세대 AI 모델과 애플리케이션을 훈련하고 배포하고 있습니다.

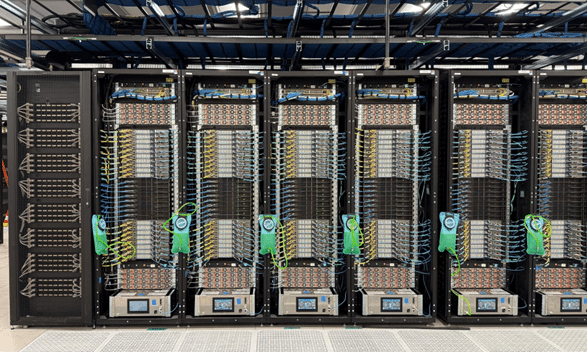

코어위브는 NVIDIA Grace Blackwell을 일반에 제공한 최초의 클라우드 제공 업체입니다. 코어위브는 추론과 AI 에이전트를 위해 설계된 강력한 랙 스케일 가속 컴퓨팅 플랫폼인 NVIDIA GB200 NVL72로 MLPerf 벤치마크에서 이미 놀라운 성과를 보여줬습니다. 이제 코어위브 고객들은 수천 개의 NVIDIA Blackwell GPU를 이용할 수 있습니다.

코어위브의 CEO인 마이클 인트레이터(Michael Intrator)는 “우리는 AI 모델 훈련과 추론 서비스를 위한 가장 강력한 최신 솔루션을 고객에게 신속하게 제공하기 위해 NVIDIA와 긴밀히 협력하고 있습니다. 새로운 Grace Blackwell 랙 스케일 시스템을 통해 많은 고객이 대규모로 운영되는 AI 혁신의 이점과 성능을 가장 먼저 경험하게 될 것”이라고 말했습니다.

이제 코어위브와 같은 클라우드 제공업체 고객들이 시스템을 본격적으로 활용할 수 있게 됐습니다. NVIDIA Grace Blackwell 기반 시스템이 본격적으로 생산에 들어가며, 클라우드 데이터센터는 AI 팩토리로 변모하고 있습니다. 이 시스템들은 대규모로 인텔리전스를 생산하고, 원시 데이터를 실시간 인사이트로 빠르고 정확하며 효율적으로 전환합니다.

현재 전 세계의 AI 선도 기업들은 AI 애플리케이션, 에이전틱 AI, 그리고 최첨단 모델 개발을 위해 GB200 NVL72의 기능을 활용하고 있습니다.

개인화된 AI 에이전트

코히어는 최첨단 연구와 모델 개발 기술을 기반으로 안전한 엔터프라이즈 AI 애플리케이션을 개발하는 데 도움을 주기 위해 Grace Blackwell 슈퍼칩을 사용하고 있습니다. 코히어의 엔터프라이즈 AI 플랫폼 노스(North)를 통해 개인화된 AI 에이전트를 구축해 엔터프라이즈 워크플로우를 안전하게 자동화하고 실시간 인사이트를 제공하는 등의 작업을 수행할 수 있습니다.

코히어는 이미 코어위브의 NVIDIA GB200 NVL72를 통해 이전 세대 NVIDIA Hopper GPU에 비해 1,000억 개 파라미터 모델 훈련에서 최대 3배 더 뛰어난 성능을 경험하고 있습니다. 이는 Blackwell 전용 최적화 없이도 이루어진 결과입니다.

코히어는 GB200 NVL72의 대용량 통합 메모리, FP4 정밀도, 모든 GPU가 연결돼 함께 작동하는 72-GPU NVIDIA NVLink 도메인을 활용한 추가 최적화를 실시했습니다. 이로써 첫 번째 토큰과 후속 토큰에 걸리는 시간을 단축해 처리량을 획기적으로 늘리고 있으며, 보다 성능이 뛰어나고 비용 효율적인 추론을 구현하고 있습니다.

코히어의 엔지니어링 부사장인 어텀 몰더(Autumn Moulder)는 “클라우드에서 최초로 NVIDIA GB200 NVL72 시스템을 사용하게 되면서, 우리 워크로드를 NVIDIA Grace Blackwell 아키텍처로 쉽게 이전할 수 있게 돼 매우 기쁩니다. 이를 통해 단일 Blackwell GPU에서 실행되는 수직 통합된 노스 애플리케이션부터 수천 대의 GPU에 걸쳐 훈련 작업을 확장하는 것까지 스택 전반에 걸친 놀라운 성능 효율을 실현할 수 있게 됐죠. 우리는 곧 추가 최적화를 통해 더 뛰어난 성능을 달성할 수 있기를 기대합니다”고 말했습니다.

엔터프라이즈용 AI 모델

IBM은 NVIDIA GB200 NVL72 시스템의 첫 번째 배포 중 하나를 사용해 코어위브에서 수천 개의 Blackwell GPU로 확장했으며 IBM의 차세대 그래니트(Granite) 모델을 훈련시키고 있습니다. 그래니트는 오픈소스 엔터프라이즈용 AI 모델 시리즈로, 최첨단 성능을 제공하는 동시에 안전성, 속도, 비용 효율성을 극대화합니다. 그래니트 모델 제품군은 선도적인 소프트웨어 기업들이 자사 기술에 거대 언어 모델(LLM)을 통합할 수 있도록 지원하는 강력한 파트너 생태계를 기반으로 합니다.

그래니트 모델은 IBM 왓슨x 오케스트레이트(watsonx Orchestrate)와 같은 솔루션의 토대를 제공합니다. 이 솔루션은 기업들이 강력한 AI 에이전트를 구축하고 배포해 기업 전반의 워크플로우를 자동화하고 가속화할 수 있도록 지원합니다.

또한, 코어위브의 IBM용 NVIDIA GB200 NVL72 배포는 AI를 위한 탁월한 고성능 스토리지를 제공하는 IBM 스토리지 스케일 시스템(IBM Storage Scale System)을 활용하고 있습니다. 코어위브 고객은 코어위브의 전용 환경과 AI 클라우드 플랫폼 내에서 IBM 스토리지 플랫폼에 액세스할 수 있죠.

IBM 리서치(IBM Research)의 AI 담당 부사장인 스리람 라가반(Sriram Raghavan)은 “우리는 NVIDIA GB200 NVL72가 그래니트 모델 제품군 훈련에 가져올 가속화에 대해 매우 기대하고 있습니다. IBM은 이번 코어위브와의 협업을 통해 IBM 왓슨x로 기업용과 에이전틱 AI 애플리케이션을 구동하는 고급, 고성능, 비용 효율적인 모델을 구축하는 역량을 강화할 수 있을 것”이라고 이야기했습니다.

대규모 컴퓨팅 리소스

미스트랄 AI는 차세대 오픈소스 AI 모델 구축을 위해 Blackwell GPU 천 개를 도입한다고 밝혔습니다.

프랑스 파리에 본사를 둔 오픈소스 AI 분야의 선두주자인 미스트랄 AI는 GB200 NVL72가 탑재된 코어위브의 인프라를 사용해 언어 모델 개발 속도를 높이고 있죠. 미스트랄은 강력한 추론 기능을 제공하는 미스트랄 라지(Large)와 같은 모델을 개발하기 위해 빠른 대규모 컴퓨팅 리소스를 필요로 합니다.

이러한 모델을 효과적으로 훈련하고 배포하기 위해 미스트랄 AI는 NVIDIA Quantum InfiniBand 네트워킹과 안정적인 인프라 관리와 함께 대규모 고성능 GPU 클러스터를 제공하는 클라우드 제공 업체가 필요합니다. 코어위브는 코어위브 미션 컨트롤(Mission Control)과 같은 도구를 통해 업계 최고의 안정성과 복원력을 갖춘 대규모 NVIDIA GPU를 구축한 경험을 바탕으로 이러한 요구 사항을 충족했습니다.

미스트랄 AI의 공동 창립자이자 CTO인 티모테 라크루아(Thimothee Lacroix)는 “우리는 추가 최적화 없이 바로 고밀도 모델 훈련 성능이 2배가 향상되는 것을 확인했습니다. NVIDIA GB200 NVL72의 흥미로운 점은 모델 개발과 추론에 새로운 가능성을 열어준다는 점”이라고 말했습니다.

증가하는 Blackwell 인스턴스 수

코어위브는 장기적인 고객 솔루션 외에도, 72개의 NVIDIA Blackwell GPU와 36개의 NVIDIA Grace CPU를 NVIDIA NVLink를 통해 랙 스케일로 연결한 인스턴스를 제공합니다. 이는 NVIDIA Quantum-2 InfiniBand 네트워킹을 통해 최대 11만 개의 GPU까지 확장할 수 있습니다.

이러한 인스턴스는 NVIDIA GB200 NVL72 랙 스케일 가속 컴퓨팅 플랫폼으로 가속화돼, 차세대 AI 추론 모델과 에이전트를 구축하고 배포하는 데 필요한 규모와 성능을 제공합니다.