모든 분야의 과학자와 엔지니어는 NVIDIA GB200와 GH200 슈퍼칩으로 구동하는 NVIDIA CUDA-X 라이브러리를 통해 어려운 문제를 훨씬 더 빠르게 해결할 수 있습니다.

NVIDIA는 GTC에서 이제 개발자들은 CPU와 GPU 리소스 간의 보다 긴밀한 통합과 조정을 활용할 수 있다고 발표했습니다. 이를 통해 기존 가속 컴퓨팅 아키텍처를 사용할 때보다 계산 엔지니어링 툴 속도를 최대 11배, 계산 규모를 최대 5배까지 높일 수 있습니다.

또한, 엔지니어링 시뮬레이션, 설계 최적화 등의 워크플로우를 크게 가속화하고 개선해, 과학자와 연구자가 획기적인 결과를 더욱 빨리 얻을 수 있도록 지원합니다.

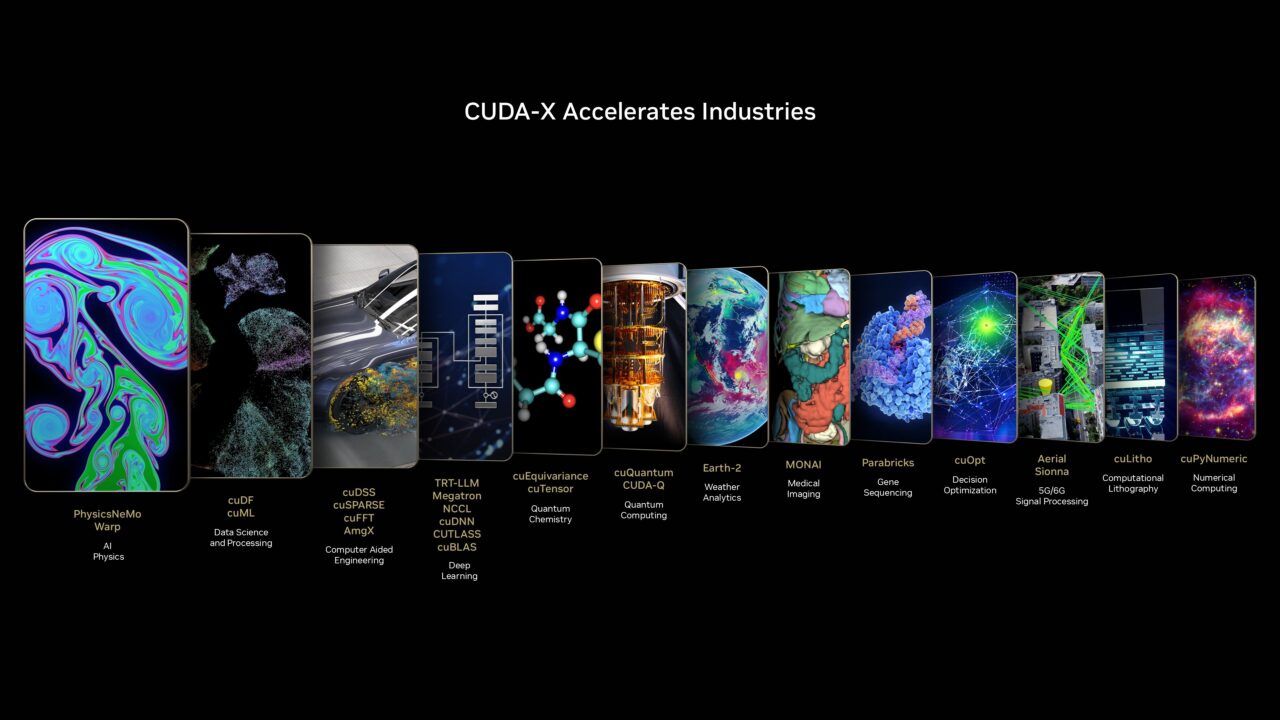

NVIDIA는 2006년 CUDA를 출시해 가속 컴퓨팅 성능을 활용할 수 있는 애플리케이션의 세계를 열었습니다. 이후 900개 이상의 도메인별 NVIDIA CUDA-X 라이브러리와 AI 모델을 구축해 가속 컴퓨팅 도입 장벽을 낮추고 놀라운 과학적 혁신을 이끌어 왔죠. 이제 CUDA-X는 천문학, 입자 물리학, 양자 물리학, 자동차, 항공우주, 반도체 설계를 포함한 광범위한 새로운 엔지니어링 분야에 가속 컴퓨팅을 지원합니다.

NVIDIA Grace CPU 아키텍처는 전력 소비를 줄이면서 메모리 대역폭을 크게 향상시킵니다. 또한 NVIDIA NVLink-C2C 인터커넥트는 GPU와 CPU가 메모리를 공유할 수 있는 높은 대역폭을 제공하죠. 이로써 개발자가 특화되지 않은 코드를 작성하고, 더 큰 작업을 실행하며, 애플리케이션 성능을 향상시킬 수 있도록 지원합니다.

NVIDIA cuDSS로 엔지니어링 솔버 가속

NVIDIA의 슈퍼칩 아키텍처를 활용하면 CPU와 GPU 처리 기능을 보다 효율적으로 활용해, 동일한 기본 GPU에서 더 큰 성능을 이끌어낼 수 있습니다.

NVIDIA cuDSS 라이브러리는 설계 최적화, 전자기 시뮬레이션 워크플로우 등 애플리케이션에서 희소 행렬을 포함하는 대규모 엔지니어링 시뮬레이션 문제 해결에 사용됩니다. Grace GPU 메모리와 고대역폭 NVLink-C2C 인터커넥트를 사용해 일반적으로 장치 메모리에 맞지 않는 대규모 행렬을 분해하고 해결하죠. 따라서 큰 규모의 문제를 짧은 시간 내에 해결할 수 있습니다.

GPU와 Grace GPU 간 일관된 공유 메모리는 데이터 이동을 최소화해 대규모 시스템의 오버헤드를 크게 낮춥니다. 다양한 대규모 계산 엔지니어링 문제에 Grace CPU 메모리와 슈퍼칩 아키텍처를 활용함으로써 cuDSS 하이브리드 메모리와 함께 동일한 GPU로도 무거운 솔루션 단계를 최대 4배까지 가속화할 수 있습니다.

앤시스(Ansys)는 전자기 시뮬레이션에 유의미한 성능 향상을 제공하는 cuDSS를 자사 HFSS 솔버에 통합했습니다. HFSS 소프트웨어는 cuDSS를 통해 매트릭스 솔버의 속도를 최대 11배까지 향상시킬 수 있죠.

알테어 옵티스트럭트(Altair OptiStruct)는 cuDSS 다이렉트 스파스 솔버(Direct Sparse Solver) 라이브러리를 도입해 유한 요소 해석 워크로드를 대폭 가속화했습니다.

이러한 성능 향상은 GPU에서 주요 작업을 최적화하고, 공유 메모리와 이기종 CPU·GPU 실행을 위해 CPU를 지능적으로 사용함으로써 달성할 수 있는데요. cuDSS는 CPU 활용도가 추가적인 이점을 제공하는 영역을 자동으로 감지해 효율성을 더욱 향상시킵니다.

슈퍼칩 메모리 기반 초고속 스케일업

GB200와 GH200 아키텍처의 NVLink-CNC 인터커넥트는 CPU와 GPU 메모리 일관성을 제공합니다. 이를 사용하면 단일 GPU에서 메모리 제한 애플리케이션을 확장할 수 있습니다.

많은 엔지니어링 시뮬레이션은 규모 제한이 있으며, 항공기 엔진 등 구성 요소가 복잡한 장비 설계에 필요한 해상도 생성을 위해 대규모 시뮬레이션을 요구하는데요. CPU와 GPU 메모리 간 원활한 읽기, 쓰기 기능을 활용하면 아웃오브코어(out-of-core) 솔버를 쉽게 구현해 더 큰 데이터를 처리할 수 있습니다.

일례로 오토데스크(Autodesk)는 데이터 생성과 공간 컴퓨팅 애플리케이션 가속화를 위한 파이썬(Python) 기반 프레임워크인 NVIDIA Warp를 사용했습니다. Warp를 기반으로 8개의 GH200 노드를 사용해 최대 480억 셀의 시뮬레이션을 수행했는데, 이는 NVIDIA H100 노드 8개로 수행 가능한 시뮬레이션보다 5배 이상 큰 규모입니다.

NVIDIA cuQuantum으로 양자 컴퓨팅 연구 지원

양자 컴퓨터는 많은 과학과 산업 분야의 핵심적인 과제를 가속할 수 있는 잠재력을 갖췄습니다. 실용적인 양자 컴퓨팅 도달 시간을 단축하는 것은 극도로 복잡한 양자 시스템 시뮬레이션 역량에 좌우되죠.

오늘날 연구자들은 시뮬레이션을 통해 미래 양자 컴퓨터에 적합한 규모로 실행될 새로운 알고리즘을 개발할 수 있습니다. 이러한 알고리즘은 새로운 큐비트 설계 성능과 노이즈 특성에 대한 복잡한 시뮬레이션을 실행해 양자 프로세서를 개선하는 데에도 핵심적인 역할을 합니다.

양자 알고리즘의 상태 벡터 시뮬레이션은 메모리에 저장해야 하는 기하급수적으로 큰 벡터 객체에 대해 행렬 연산을 수행해야 합니다. 반면 Tensor 네트워크 시뮬레이션은 Tensor 축약을 통해 양자 알고리즘을 시뮬레이션하며, 특정 핵심 애플리케이션 유형에 대해 수백 또는 수천 개의 큐비트를 시뮬레이션할 수 있습니다.

NVIDIA cuQuantum 라이브러리는 이러한 워크로드를 가속화합니다. 모든 주요 양자 컴퓨팅 프레임워크와 통합돼 있어, 양자 연구자가 코드 변경 없이 시뮬레이션 성능을 활용할 수 있습니다.

양자 알고리즘의 시뮬레이션은 일반적으로 메모리 요구 사항에 따라 규모가 제한됩니다. GB200와 GH200 아키텍처는 성능 병목 현상 없이 대용량 CPU 메모리를 사용할 수 있어 양자 시뮬레이션 확장에 적합한 플랫폼입니다. GH200 시스템은 양자 컴퓨팅 벤치마크에서 x86을 사용하는 H100 시스템보다 최대 3배 빠릅니다.

NVIDIA 창립자 겸 CEO 젠슨 황(Jensen Huang)의 GTC 키노트를 통해 CUDA-X 라이브러리에 대해 자세히 알아보세요. 그리고 수학 라이브러리가 NVIDIA Blackwell GPU에서 애플리케이션 가속화에 도움이 되는 방법도 확인하세요.