NVIDIA Blackwell 플랫폼은 Baseten, DeepInfra, Fireworks AI, Together AI 등 주요 추론(inference) 제공업체들에 의해 폭넓게 도입되어, 토큰당 비용을 최대 10배 절감하는 데 기여하고 있습니다. 이제 NVIDIA Blackwell Ultra 플랫폼은 이러한 성과를 기반으로 에이전틱 AI 영역으로 그 영향력을 확대하고 있습니다.

OpenRouter의 State of Inference 보고서에 따르면, AI 에이전트와 코딩 어시스턴트의 부상으로 소프트웨어 프로그래밍 관련 AI 쿼리가 지난해 11%에서 약 50%로 급증한 것으로 나타났는데요, 이런 애플리케이션은 복잡한 다단계 워크플로우에서 실시간 반응성을 유지하고, 전체 코드베이스를 아우르는 추론을 수행하기 위해 저지연성과 긴 문맥 처리 능력을 필수로 요구합니다.

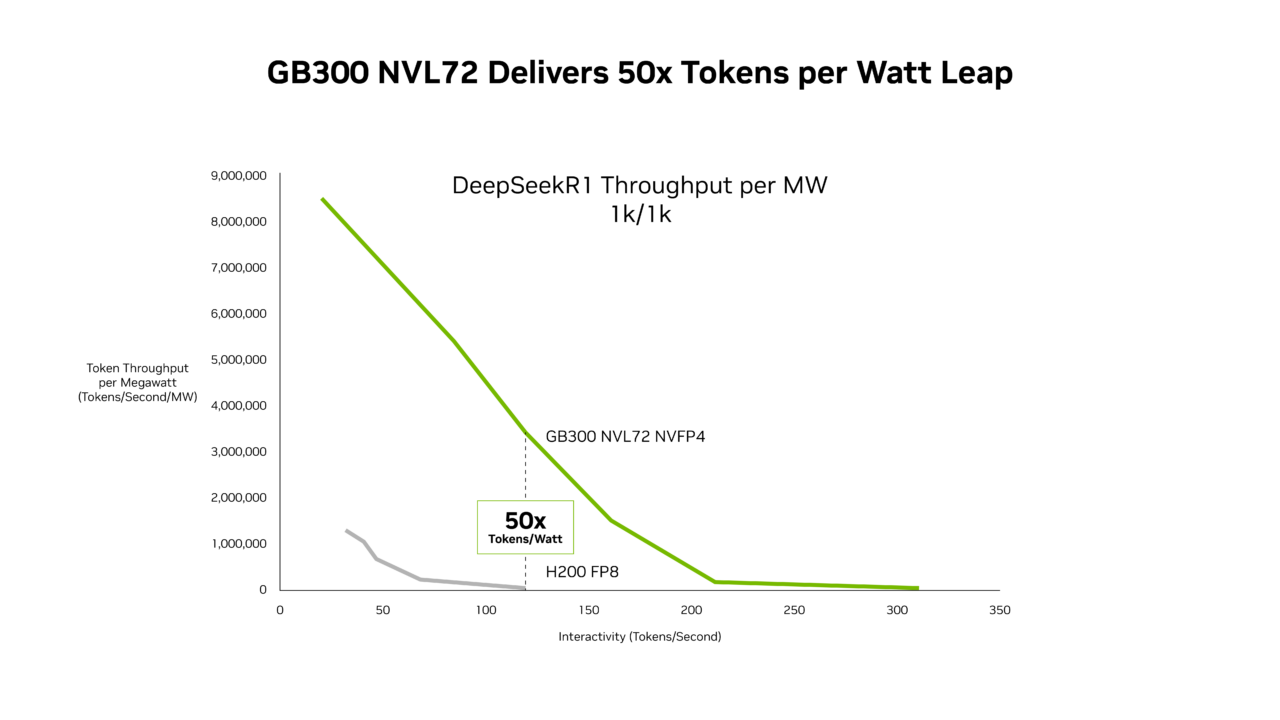

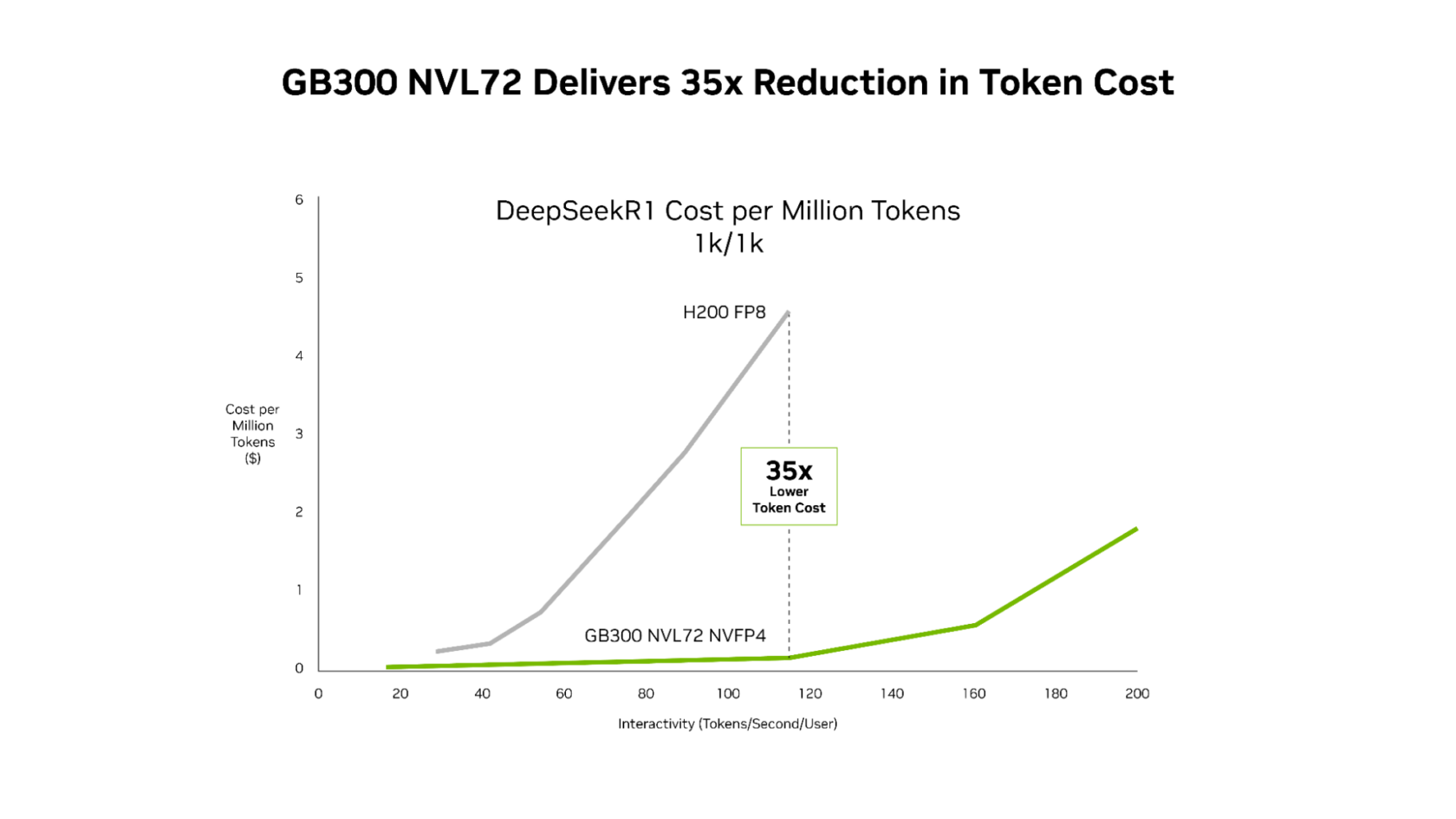

SemiAnalysis InferenceX의 최신 성능 데이터에 따르면, NVIDIA의 소프트웨어 최적화 기술과 차세대 Blackwell Ultra 플랫폼의 결합을 통해 두 영역 모두에서 획기적인 진전이 이루어졌습니다. NVIDIA GB300 NVL72 시스템은 이제 메가와트당 처리량을 최대 50배 향상시키고, NVIDIA Hopper 플랫폼 대비 토큰당 비용을 35배 절감하는 성과를 달성했습니다.

이 같이 칩, 시스템 아키텍처, 소프트웨어 전반에 걸친 혁신을 통해 NVIDIA는 성능과 비용 효율성을 동시에 끌어올리고 있습니다. 이는 에이전틱 코딩부터 대화형 코딩 어시스턴트에 이르기까지 다양한 AI 워크로드의 성능을 가속화하면서, 대규모 인프라 단위에서도 비용 절감을 실현하고 있습니다.

GB300 NVL72, 저지연 워크로드 성능 최대 50배 향상

Signal65의 최근 분석에 따르면, 극한의 하드웨어·소프트웨어 코디자인을 적용한 NVIDIA GB200 NVL72는 NVIDIA Hopper 플랫폼 대비 와트당 토큰 처리량을 10배 이상 높이며, 토큰당 비용을 10분의 1 수준으로 절감했습니다. 이러한 성능 향상은 기반 기술 스택이 발전함에 따라 계속 확대되고 있습니다.

NVIDIA TensorRT-LLM, NVIDIA Dynamo, Mooncake, SGLang 팀의 지속적인 최적화는 모든 지연 시간 목표에서 Blackwell NVL72의 MoE(Mixture-of-experts) 추론 처리량을 크게 향상시키고 있는데요, 예를 들어, NVIDIA TensorRT-LLM 라이브러리의 개선만으로도 불과 4개월 전 대비 GB200에서 저지연 워크로드 성능이 최대 5배 향상되었습니다.

- 효율성과 저지연을 위해 최적화된 고성능 GPU 커널은 Blackwell의 막대한 연산 성능을 극대화하며 처리량을 높입니다.

- 또한, NVIDIA NVLink Symmetric Memory는 GPU 간 직접 메모리 접근을 가능하게 해 더 효율적인 통신을 지원합니다.

- 아울러, Programmatic Dependent Launch 기능은 이전 커널이 완전히 종료되기 전에 다음 커널의 설정 단계를 시작해 유휴 시간을 최소화합니다.

이러한 소프트웨어 혁신을 기반으로, Blackwell Ultra GPU를 탑재한 GB300 NVL72는 Hopper 플랫폼 대비 메가와트당 처리량을 50배까지 끌어올리며 새로운 성능 한계를 제시하게 됩니다.

그 결과, NVIDIA GB300은 지연 시간 전 범위에서 Hopper 플랫폼 대비 더 우수한 비용 효율성을 실현하게 되는데, 특히 에이전틱 애플리케이션이 작동하는 저지연 환경에서는 Hopper 플랫폼 대비 100만 토큰당 비용을 최대 35배 절감하는 놀라운 성과를 보여줍니다.

에이전틱 코딩과 대화형 어시스턴트 같이 여러 단계의 워크플로우에서 밀리초(ms) 단위 지연이 누적되는 워크로드의 경우, 지속적인 소프트웨어 최적화와 차세대 하드웨어의 결합은 AI 플랫폼이 실시간 인터랙티브 경험을 훨씬 더 많은 사용자에게 확장할 수 있도록 지원합니다.

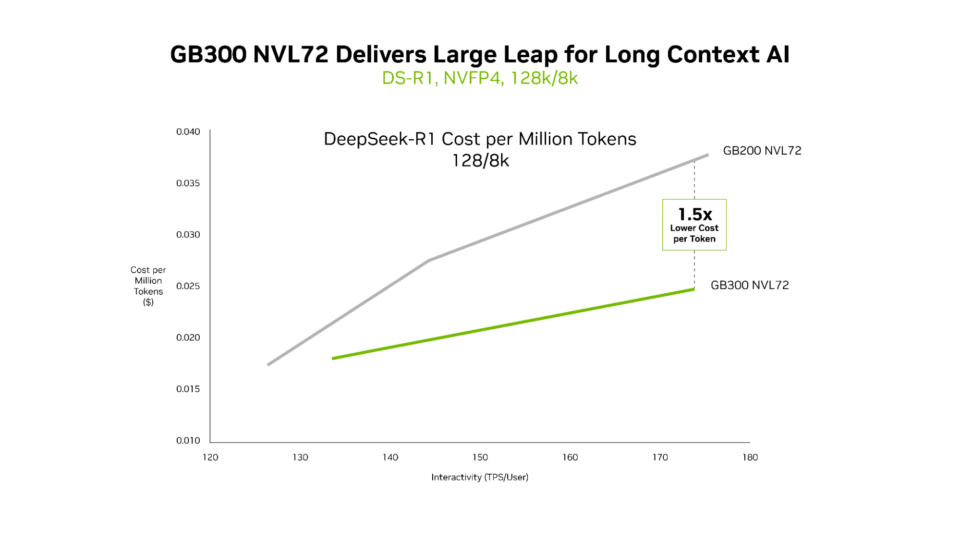

GB300 NVL72, 장문맥 워크로드에서 탁월한 비용 효율성 제공

GB200 NVL72와 GB300 NVL72 모두 초저지연 성능을 효율적으로 제공하지만, GB300 NVL72의 차별화된 강점은 장문맥(Long-Context) 환경에서 특히 두드러집니다. 예를 들어, 128,000 토큰 입력과 8,000 토큰 출력을 처리하는 워크로드 — 즉, 코드베이스 전반에 걸쳐 추론하는 AI 코딩 어시스턴트와 같은 경우 — 에서 GB300 NVL72는 GB200 NVL72 대비 토큰당 비용을 최대 1.5배 절감합니다.

에이전트가 더 많은 코드를 읽을수록 문맥(context)은 확장됩니다. 이는 코드베이스를 더 깊이 이해할 수 있게 해주지만, 동시에 훨씬 더 많은 연산(compute)을 필요로 하는데요, Blackwell Ultra는 NVFP4 연산 성능이 1.5배, 어텐션 처리 속도가 2배 빨라, 에이전트가 전체 코드베이스를 효율적으로 이해할 수 있도록 지원합니다.

에이전틱 AI를 위한 인프라

주요 클라우드 서비스 제공업체와 AI 혁신 기업들은 이미 NVIDIA GB200 NVL72를 대규모로 도입했으며, 현재 GB300 NVL72 역시 실제 프로덕션 환경에 배포하고 있습니다.

Microsoft, CoreWeave, OCI 등은 에이전틱 코딩과 코딩 어시스턴트와 같은 저지연·장문맥 활용 사례를 위해 GB300 NVL72를 적용하고 있죠. 특히, 토큰 비용을 절감함으로써 GB300 NVL72는 대규모 코드베이스를 실시간으로 추론할 수 있는 새로운 형태의 애플리케이션을 가능하게 합니다.

CoreWeave 엔지니어링 총괄 부사장 Chen Goldberg는 다음과 같이 밝혔습니다. “추론이 AI 프로덕션의 중심으로 이동함에 따라, 장문맥 성능과 토큰 효율성이 핵심이 되고 있습니다. Grace Blackwell NVL72는 이러한 도전 과제를 직접 해결하며, CKS와 SUNK를 포함한 CoreWeave의 AI 클라우드는 GB200의 성공을 기반으로 GB300 시스템의 개선된 성능과 비용 효율성을 예측 가능한 형태로 제공합니다. 그 결과 고객은 대규모 추론 워크로드에서 더 나은 토큰 경제성과 활용성을 얻을 수 있습니다.”

NVIDIA Vera Rubin NVL72, 차세대 성능 시대를 여는 플랫폼

NVIDIA Blackwell 시스템이 대규모로 배포되면서, 지속적인 소프트웨어 최적화를 통해 설치된 인프라 전반에서 성능 향상과 비용 절감이 계속될 것으로 기대되고 있습니다. 특히 앞으로 출시될 NVIDIA Rubin 플랫폼은 여섯 개의 새로운 칩을 통합해 하나의 AI 슈퍼컴퓨터를 구성하며, 또 한 번의 대규모 성능 도약을 예고하고 있는데요, MoE 추론에서는 Blackwell 대비 메가와트당 처리량이 최대 10배 향상, 100만 토큰당 비용이 10분의 1 수준으로 줄어들게 됩니다. 또한 차세대 프런티어 AI 모델 학습에서는 Blackwell 대비 GPU 사용량을 4분의 1 수준으로 크게 줄여 대형 MoE 모델을 훈련할 수 있습니다.

NVIDIA Rubin 플랫폼과 Vera Rubin NVL72 시스템에 대한 더 자세한 내용은 공식 웹페이지에서 확인할 수 있습니다.