DeepSeek-R1은 최첨단 추론 기능을 갖춘 오픈 모델입니다. DeepSeek-R1과 같은 추론 모델은 직접적인 답변을 제공하는 대신 쿼리에 대해 여러 번의 추론 패스(Inference Passes)를 수행하여 연쇄 사고, 합의, 그리고 검색 방법을 수행하여 최상의 답변을 생성합니다.

이러한 일련의 추론 패스를 수행하여 최적의 답변에 도달하기 위해 추론을 사용하는 것을 테스트 타임 스케일링(Test-Time Scaling)이라고 합니다. DeepSeek-R1은 이 스케일링 법칙의 완벽한 예로, 에이전틱 AI 추론의 요구 사항에서 가속 컴퓨팅이 왜 중요한지 보여줍니다.

모델이 문제를 반복적으로 ‘사고’할 수 있게 되면 더 많은 출력 토큰과 더 긴 생성 주기가 생성되므로 모델 품질이 계속 확장됩니다. DeepSeek-R1과 같은 추론 모델에서 실시간 추론과 고품질 응답을 모두 구현하려면 상당한 테스트 시간 컴퓨팅이 중요하므로 더 큰 규모의 추론 배포가 필요합니다.

R1은 논리적 추론, 추론, 수학, 코딩 및 언어 이해가 필요한 작업에 대해 최고의 정확도를 제공하는 동시에 높은 추론 효율성을 제공합니다.

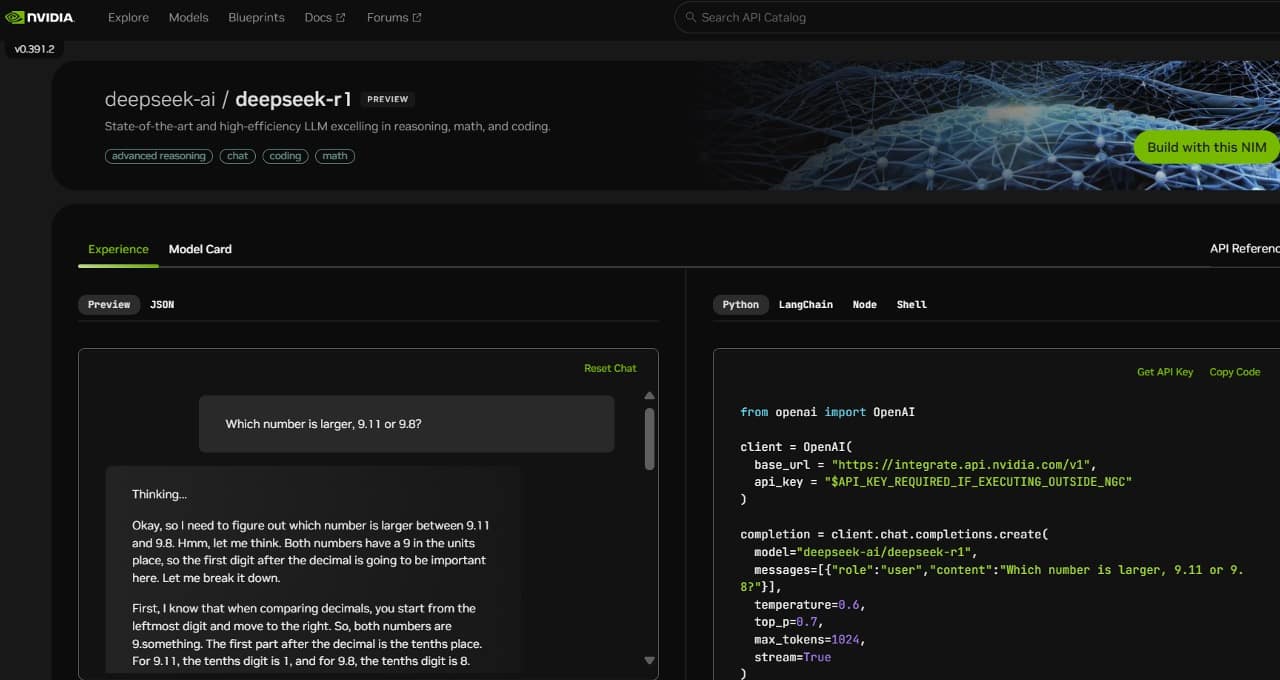

개발자가 이러한 기능을 안전하게 실험하고 자신만의 전문 에이전트를 구축할 수 있도록 6,710억 개의 파라미터로 구성된 DeepSeek-R1 모델은 현재 build.nvidia.com에서 NVIDIA NIM 마이크로서비스 프리뷰로 제공되고 있습니다. DeepSeek-R1 NIM 마이크로서비스는 단일 NVIDIA HGX H200 시스템에서 초당 최대 3,872개의 토큰을 전송할 수 있습니다.

개발자들은 이제 애플리케이션 프로그래밍 인터페이스(API)를 테스트하고 실험할 수 있으며, 이는 NVIDIA AI Enterprise 소프트웨어 플랫폼의 일부인 NIM 마이크로서비스로 제공될 예정입니다.

DeepSeek-R1 NIM 마이크로서비스는 업계 표준 API를 지원하여 배포를 간소화 시켜주고 있습니다. 엔터프라이즈 기업들은 가속 컴퓨팅 인프라에서 NIM 마이크로서비스를 실행하여 보안 및 데이터 프라이버시를 극대화할 수 있습니다. 또한, 기업은 NVIDIA NeMo 소프트웨어와 함께 NVIDIA AI Foundry를 사용하여 특별한 AI 에이전트를 위한 맞춤형 DeepSeek-R1 NIM 마이크로서비스를 생성할 수 있습니다.

DeepSeek-R1 – 테스트 타임 스케일링(Test-Time Scaling)의 완벽한 예시

DeepSeek-R1은 거대 MoE(Mixture-Of-Experts)입니다. 다른 인기 있는 오픈 소스 LLM보다 10배 많은 6,710억 개의 파라미터를 통합하여 128,000개의 토큰이라는 거대한 인풋 컨텍스트 길이(input context length)를 지원합니다. 또한 이 모델은 레이어당 극단적으로 많은 수의 Expert를 사용합니다. R1의 각 레이어에는 256명의 Experts가 있으며, 각 토큰은 평가를 위해 8명의 각각의 Experts에게 병렬로 라우팅됩니다.

R1에 실시간 답변을 제공하려면 추론을 위해 모든 Experts에게 신속한 토큰을 라우팅하기 위해 높은 대역폭과 짧은 지연 시간의 통신으로 연결된 높은 컴퓨팅 성능을 갖춘 많은 GPU가 필요합니다. NVIDIA NIM 마이크로서비스에서 제공되는 소프트웨어 최적화와 결합하여 NVLink와 NVLink Switch를 사용하여 연결된 8개의 H200 GPU가 있는 단일 서버는 초당 최대 3,872개의 토큰으로 6,710억 개의 파라미터로 구성된 전체 DeepSeek-R1 모델을 실행할 수 있습니다. 이러한 처리량은 모든 레이어에서 NVIDIA Hopper 아키텍처의 FP8 트랜스포머 엔진과 MoE 전문가 통신을 위한 900GB/s의 NVLink 대역폭을 사용함으로써 가능합니다.

실시간 추론에는 GPU에서 모든 초당 부동 소수점 연산(FLOPS)의 성능을 끌어내는 것이 매우 중요합니다. 차세대 NVIDIA Blackwell 아키텍처는 최대 20페타플롭의 피크 FP4 컴퓨팅 성능을 제공할 수 있는 5세대 Tensor 코어와 추론에 특별히 최적화된 72-GPU NVLink 도메인을 통해 DeepSeek-R1과 같은 추론 모델의 테스트 시간 확장을 크게 향상시킬 것입니다.

지금 DeepSeek-R1 NIM 마이크로서비스를 시작하세요

개발자는 이제 build.nvidia.com에서 DeepSeek-R1 NIM 마이크로서비스를 체험할 수 있습니다. 작동 방식을 살펴보세요.

NVIDIA NIM을 통해 기업은 DeepSeek-R1을 쉽게 배포하고 에이전틱 AI 시스템에 필요한 높은 효율성을 확보할 수 있습니다.

소프트웨어 제품 정보에 관한 공지는 여기에서 참조하세요.