로스콘(ROSCon)은 덴마크에서 가장 오래된 도시 중 하나이자 자동화의 중심지인 오덴세(Odense)에서 진행됐습니다. 이번 발표에서 NVIDIA는 로봇 생태계 파트너들과 함께 로봇운영체제(ROS) 개발자를 위한 생성형 AI 툴, 시뮬레이션, 인식 워크플로우를 공개했습니다.

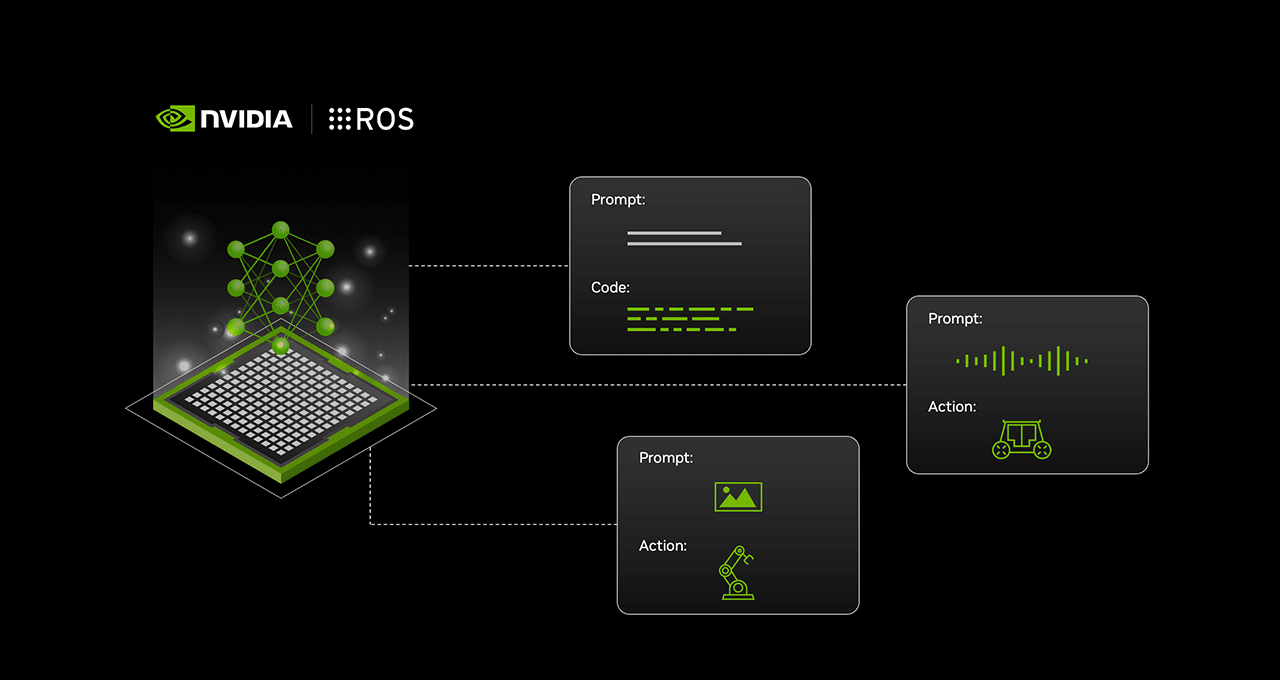

여기에는 엣지 AI와 로보틱스용 NVIDIA Jetson 플랫폼을 배포에 활용하는 ROS 개발자를 위한 새로운 생성형 AI 노드와 워크플로우가 포함됐습니다. 생성형 AI를 통해 로봇은 주변 환경을 인식하고 이해하며, 인간과 자연스럽게 소통하고, 자율적으로 상황에 맞는 결정을 내릴 수 있죠.

ROS 커뮤니티에 등장한 생성형 AI

ROS 2를 기반으로 구축된 ReMEmbR는 생성형 AI를 사용해 로봇의 추론과 행동을 향상시킵니다. 이는 거대 언어 모델(Large Language Model, LLM), 비전 언어 모델(Vision Language Model, VLM), 검색 증강 생성(retrieval-augmented generation, RAG)을 결합하죠. 따라서 로봇은 장기적인 의미 기억을 구축, 쿼리하며 환경을 탐색하고 상호 작용하는 능력을 향상시킬 수 있습니다.

음성 인식 기능은 WhisperTRT ROS 2 노드에 의해 구동됩니다. 이 노드는 NVIDIA TensorRT를 사용해 오픈AI(OpenAI)의 위스퍼(Whisper) 모델을 최적화하고, NVIDIA Jetson에서 지연 시간이 짧은 추론을 가능하게 함으로써 인간과 로봇의 즉각적인 상호 작용을 가능하게 합니다.

음성 제어 기능을 갖춘 ROS 2 로봇 프로젝트는 NVIDIA Riva ASR-TTS 서비스를 사용해 로봇이 음성 명령을 이해하고 이에 응답할 수 있도록 합니다. 나사 제트추진연구소(The NASA Jet Propulsion Laboratory)는 ROS용 AI 기반 에이전트인 로사(ROSA)를 독자적으로 선보였는데요. 이 에이전트는 네뷸라-SPOT(Nebula-SPOT) 로봇과 NVIDIA Isaac Sim의 NVIDIA Nova Carter 로봇에서 작동했습니다.

로스콘에서 캐노니컬(Canonical)은 NVIDIA Jetson Orin Nano 시스템 온 모듈에서 실행되는 제로샷(zero-shot) 물체 감지 모델인 나노OWL(NanoOWL)을 시연합니다. 이 모델을 사용하면 로봇이 사전 정의된 범주에 의존하지 않고도 광범위한 물체를 실시간으로 식별할 수 있죠.

개발자는 이제 로봇 기능을 향상하기 위해 NVIDIA Jetson에 최적화된 LLM과 VLM을 제공하는 생성형 AI용 ROS 2 노드를 사용할 수 있습니다.

‘심 퍼스트(Sim-First)’ 접근 방식으로 ROS 워크플로우 향상

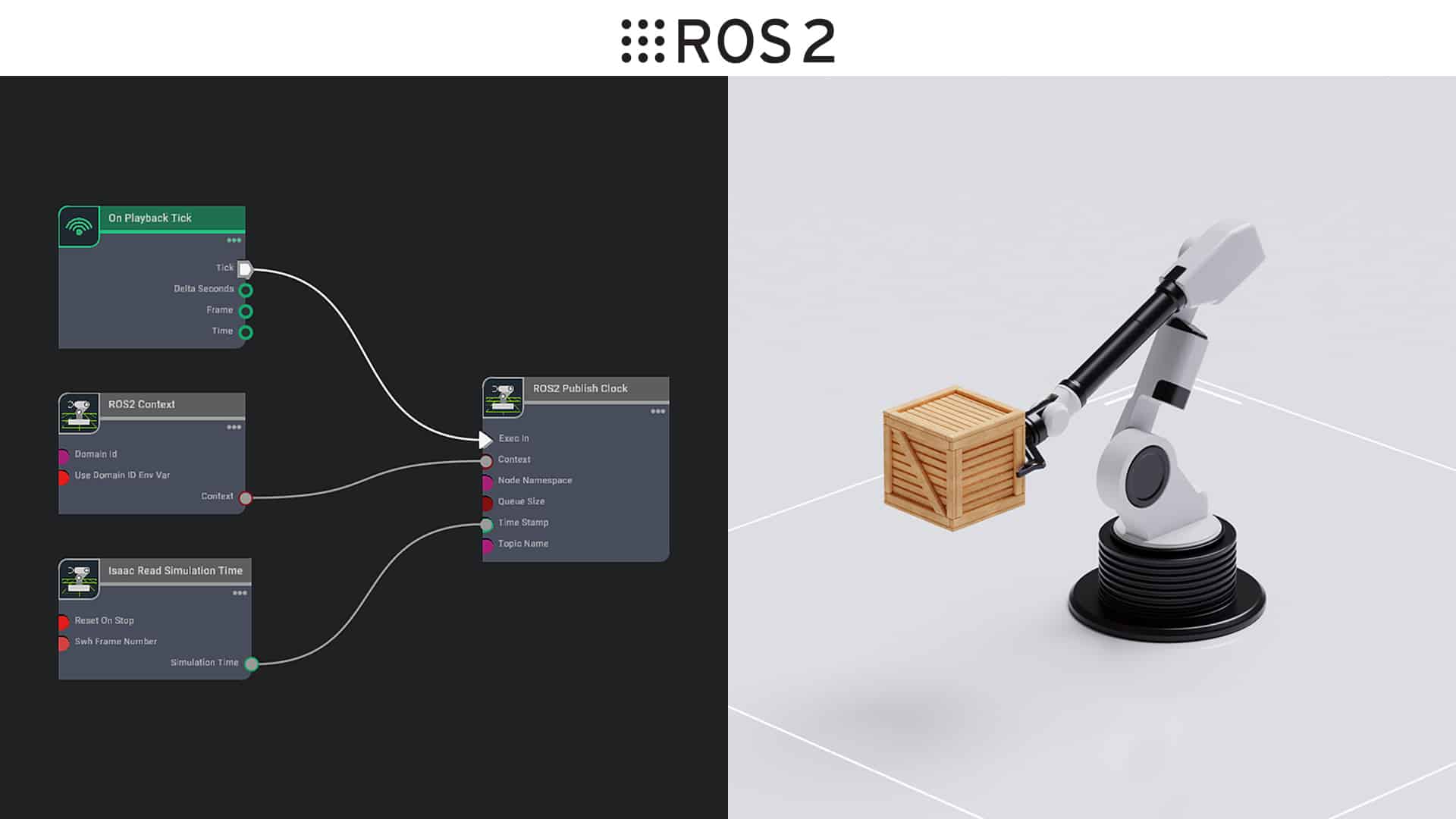

시뮬레이션은 배포 전에 AI 지원 로봇을 안전하게 테스트하고 검증하는 데 매우 중요한 작업입니다. 오픈USD(OpenUSD)를 기반으로 구축된 로봇 시뮬레이션 플랫폼인 NVIDIA Isaac Sim은 ROS 개발자에게 로봇을 ROS 패키지에 쉽게 연결해 테스트할 수 있는 가상 환경을 제공하죠. 로봇 시뮬레이션과 테스트를 위한 엔드 투 엔드 워크플로우에 대한 설명을 새로운 ‘Isaac Sim을 사용한 ROS 2 워크플로우 초보자 가이드(Beginner’s Guide to ROS 2 Workflows With Isaac Sim)’에서 만나보세요.

스타트업을 위한 NVIDIA Inception 프로그램의 회원사인 폭스글러브(Foxglove)는 개발자가 Isaac Sim을 기반으로 구축된 맞춤형 확장 기능을 사용해 시뮬레이션 데이터를 실시간으로 시각화하고 디버깅하는 데 도움이 되는 통합 기술을 시연했습니다.

Isaac ROS 3.2의 새로운 기능

오픈 소스 ROS 2 소프트웨어 프레임워크를 기반으로 구축된 NVIDIA Isaac ROS는 로보틱스 개발을 위한 가속 컴퓨팅 패키지와 AI 모델의 모음입니다. 곧 출시될 3.2 버전은 로봇의 인식, 조작, 환경 매핑을 향상시킵니다.

NVIDIA Isaac Manipulator의 주요 개선 사항에는 파운데이션포즈(FoundationPose)와 cu모션(cuMotion)을 통합하는 새로운 레퍼런스 워크플로우가 포함됩니다. 이는 로보틱스에서 픽앤플레이스(pick-and-place)와 객체 추적 파이프라인의 개발을 가속화합니다.

또한 NVIDIA Isaac Perceptor도 개선됐습니다. 새로운 시각적 SLAM 레퍼런스 워크플로우, 향상된 다중 카메라 감지, 3D 재구성을 특징으로 자율 이동 로봇(autonomous mobile robot, AMR)의 환경 인식과 창고와 같은 동적인 환경에서의 성능을 개선합니다.

NVIDIA Isaac을 채택한 파트너사

로보틱스 기업들이 NVIDIA Isaac 가속 라이브러리와 AI 모델을 자사 플랫폼에 통합하고 있습니다.

- 테라다인 로보틱스(Teradyne Robotics)의 자회사인 유니버설 로봇(Universal Robots)은 AI 기반 코봇(cobot) 애플리케이션을 개발할 수 있는 새로운 AI 엑셀러레이터 툴킷(AI Accelerator toolkit)을 출시했습니다.

- 미소 로보틱스(Miso Robotics)는 Isaac ROS를 사용해 AI 기반 로봇 감자튀김 제조 플리피 프라이 스테이션(Flippy Fry Station)의 속도를 높이고 식품 서비스 자동화의 효율성과 정확성을 향상시키고 있습니다.

- 휠미(Wheel.me)는 알고 로보틱스(RGo Robotics), NVIDIA와 협력해 Isaac Perceptor를 통한 생산에 바로 사용할 수 있는 AMR을 개발하고 있습니다.

- 메인 스트리트 오토노미(Main Street Autonomy)는 센서 보정을 간소화하기 위해 Isaac Perceptor를 사용하고 있습니다.

- 오르벡(Orbbec)은 Isaac Perceptor를 위한 즉시 사용 가능한 AMR 솔루션인 퍼셉터 디밸로퍼 키트(Perceptor Developer Kit)를 발표했습니다.

- 립스 코퍼레이션(LIPS Corporation)은 향상된 AMR 내비게이션을 위한 멀티 카메라 인식 개발 키트를 출시했습니다.

- 캐노니컬은 ROS 개발자를 위해 완전히 인증된 우분투(Ubuntu) 환경을 강조하며 장기적인 지원을 즉시 제공합니다.

로스콘에서 만나는 파트너사

캐노니컬, 에쿠멘(Ekumen), 폭스글러브, 인트린직(Intrinsic), 오픈 내비게이션(Open Navigation), 지멘스(Siemens), 테라다인 로보틱스 등 ROS 커뮤니티 회원과 파트너가 덴마크에서 워크샵, 강연, 부스 데모, 세션을 진행합니다.

- 오픈 내비게이션 LLC의 스티브 매켄스키(Steve Macenski)와 함께하는 소규모 그룹 세션 ‘내브2 사용자 밋업(Nav2 User Meetup)’

- BMW AG의 마이클 겐트너(Michael Gentner)와 지멘스 AG의 카르스텐 브라운로스(Carsten Braunroth)가 함께하는 ‘대규모 공장 자동화의 ROS(ROS in Large-Scale Factory Automation)’

- NVIDIA의 칼리안 바드레부(Kalyan Vadrevu)와 함께하는 소규모 그룹 세션 ‘로봇 조작 워크플로우에 AI 통합하기(Integrating AI in Robot Manipulation Workflows)’

- NVIDIA의 마르쿠스 우엔슈 (Markus Wuensch)와 함께하는 소규모 그룹 세션 ‘시뮬레이션에서 대규모 로봇 학습 가속화(Accelerating Robot Learning at Scale in Simulation)’

- 오픈 내비게이션 LLC의 스티브 매켄스키와 함께하는 “내브2 도킹 사용(On Use of Nav2 Docking)”

10월 22일에는 덴마크 오덴세에서 NVIDIA, 테라다인 로보틱스가 공동으로 점심과 저녁 리셉션을 주최했습니다.

오픈 소스 로보틱스 재단(The Open Source Robotics Foundation, OSRF)이 로스콘을 주최하고 있습니다. NVIDIA는 OSRF와 그 모든 이니셔티브를 위한 산하 조직인 오픈 로보틱스(Open Robotics)의 후원사입니다.

로스콘의 최신 소식을 확인해보세요.