10개의 동사 시제, 8개의 명사 사례, 3개의 문법적 성(性), 그리고 복합어에 강한 인도 고전언어 산스크리트어는 사람에게 가르치기 쉬운 언어가 아닙니다. 그러니 AI 모델을 가르치는 어려움은 말할 것도 없죠.

인도학자 올리버 헬위그(Oliver Hellwig) 박사는 4,000년 된 산스크리트어 문헌을 분석할 수 있는 딥 러닝 모델을 훈련시키기 위해 도전하고 있습니다. 단어 별로 구문 분석 작업이 되있는 산스크리트어 디지털 저장소는 연구자가 정보를 더 쉽게 검색하며, 병렬 문단을 통해 구문을 더 잘 구별할 수 있게 하죠.

AI는 일본 고전 문학은 물론 독일어와 이탈리아어로 된 역사 문헌 해석에도 활용되고 있습니다. 하지만 현존하는 대부분의 자연어처리(Natural Language Processing, NLP) 모델은 문법, 구두점, 서식의 유사한 규칙을 따르는 서양 언어에 맞춰져 있죠.

오른쪽에서 왼쪽으로 읽히는 원고를 기록하고 분석하는 소프트웨어를 개발하는 연구원들에게 표음식이 아닌 상형문자, 또는 산스크리트어처럼 종종 단어 사이에 문자열을 사용하지 않는 경우일 때 어려움은 가중됩니다.

영어와 달리 산스크리트어는 굴절어입니다. 즉, 문장에서 단어가 기능에 따라 형태가 바뀐다는 것을 의미합니다. 어떤 산스크리트어 동사는 문맥에 따라 200개 이상의 형태를 가지고 있죠. 또한 이 언어는 광범위한 어휘를 가지고 있는데요. 예를 들어 “해” 또는 “달”을 뜻하는 50개 이상의 단어를 가지고 있죠. 따라서 AI 모델 훈련은 방대하고 다양한 텍스트 데이터세트 준비가 반드시 선행돼야 하죠.

스위스 취리히 대학 박사 후 과정의 헬위그(Hellwig) 연구원은 15년 전에 컴퓨터 도구가 그의 언어학 연구를 위한 새로운 가능성을 열어 줄 수 있다는 것을 알았지만, 산스크리트어 문헌의 단지 일부만 기계 판독이 가능한 텍스트로 디지털화돼 있다는 것을 발견했죠.

그 이후, 매일같이 30분 동안 산스크리트어를 분석해 데이터베이스에 추가했고, 그 결과 이제 데이터베이스에는 수동으로 레이블을 붙인 450만 개의 단어가 생겼습니다.

헬위그 박사는 맨 처음 산스크리트어의 복합 문자열을 분리하기 위한 도구부터 만들기 시작했죠. 통계 모델로 시작해 광학 문자 인식과 자연어처리(NLP) 모델로 발전시켰습니다. 이제는 엔비디아 쿼드로GPU를 사용해 산스크리트어 문헌의 문자를 식별하고 단어의 끝을 찾을 수 있는 딥 러닝 모델을 훈련시키고 있습니다.

산스크리트어를 번역하는 AI 도구는 서사시, 종교서, 힌두교의 아유르베다 의술을 아우르는 방대한 역사적 필사본들을 디지털화하는데 도움을 줄 수 있습니다.

산스크리트어 해독하기

연구원들은 라틴 알파벳에 기초한 문헌에 대한 AI 모델을 훈련할 때, 뉴럴 네트워크가 한 단어가 끝나는 곳과 다른 단어가 시작되는 곳 사이의 빈 공간을 감지하도록 가르칠 수 있습니다.

그러나 산스크리트어로 된 원고는 해당되지 않습니다. 한 줄의 문장이 한 줄 또는 두 줄로 이어진 복합적인 단어들로 합쳐지기 때문인데요. ‘연결’이라는 뜻의 ‘샌드히(sandhi)‘라는 단어는 이 단어들을 함께 결합하는 음성학적 과정을 묘사하는 데 사용됩니다.

산스크리트어 텍스트에 대한 효과적인 자연어처리(NLP) 모델은 ‘샌드히’된 복합 문자열을 개별 단어로 분할할 수 있어야 하며, 이는 연구자들에게 상당히 어려운 문제를 안깁니다.

헬위그 박사는 “모든 알고리즘은 유효한 분할 형태를 생성하기 위해 텍스트 행의 의미를 어느 정도 이해해야 합니다”라며, “이는 영어에서는 사소할 수 있지만, 산스크리트어에서는 가장 문제가 되는 단계죠”라고 말했습니다.

산스크리트어의 복합 문자열을 개별 단어로 나누기 위해 헬위그 박사가 개발한 딥 러닝 툴은 기존 방식보다 10~15% 정도 더 정확합니다.

헬위그 박사는 “제가 개발한 딥 러닝 툴이 매우 잘 작동해서 놀랐습니다. 이 문헌의 원래 형태를 읽는 것은 심지어 사람에게도 아주 복잡한 작업이기 때문이죠”라고 말했습니다.

헬위그 박사는 엔비디아 GPU를 사용해 AI 모델을 10배 더 빠르게 교육할 수 있었습니다. 이 속도를 통해 오류를 더 빠르게 평가하고 보다 정확한 모델을 효율적으로 개발할 수 있었죠. 헬위그 박사가 개발한 딥 러닝 도구는 현재 GRETIL이라고 하는 커다란 산스크리트어 말뭉치에 사용되고 있습니다.

많은 역사가들은 산스크리트어로 쓰여진 주요 서적, 특히 ‘바가바드 기타’와 같은 종교적인 작품들의 시대에 대해 연구합니다. 헬위그는 뉴럴 네트워크와 엔비디아 GPU를 사용한 고대 산스크리트어 문헌의 문법 구조와 언어 형태 분석이 학술적 연구에 기여할 수 있기를 바라죠.

헬위그 박사는 이 언어학적 증거와 산스크리트어가 시간이 흘러감에 따라 어떻게 변했는지를 보여주는 모델을 연결함으로써, 몇 가지 주요 문헌들의 언제 자필됐는지 알아내는데 도움을 줄 수 있길 원합니다.

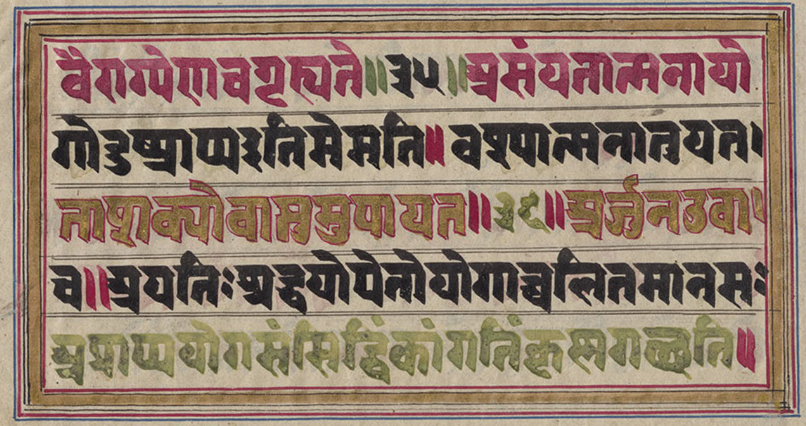

위의 이미지는 10만개의 연으로 된 산스크리트 서사시 마하바라타의 원고의 낱장으로, 힌두교의 기초 문헌인 바가바드 기타를 포함하고 있습니다. 이미지는 마이애미 대학교 도서관의 디지털 컬렉션 이미지이며, 공유 저작물입니다.