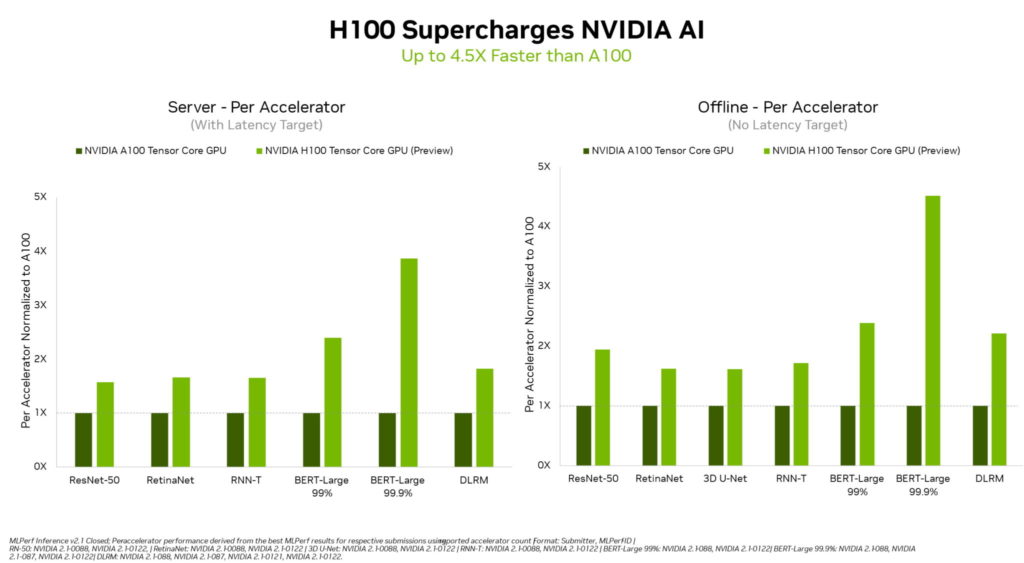

NVIDIA는 MLPerf 업계 표준 AI 벤치마크에서 NVIDIA H100 Tensor Core GPU를 발표했습니다. 이는 모든 워크로드에 대한 추론에서 세계 기록을 세웠으며, 이전 세대 GPU보다 최대 4.5배 더 높은 성능을 제공하죠.

이 결과는 Hopper가 고급 AI 모델에서 최고의 성능을 요구하는 사용자를 위한 프리미엄 선택임을 보여줍니다.

더불어 AI 기반 로보틱스를 위한 NVIDIA A100 Tensor Core GPU와 NVIDIA Jetson AGX Orin 모듈은 이미지 및 음성 인식, 자연어 처리, 추천 시스템과 같은 모든 MLPerf 테스트에서 전반적인 리더십 추론 성능을 지속적으로 제공했습니다.

Hopper로 알려진 H100은 라운드의 모든 6개 신경망에서 가속기 당 성능 기준을 높였습니다. 별도의 서버와 오프라인 시나리오에서 처리량, 속도 모두에서 리더십을 보였죠.

NVIDIA Hopper 아키텍처는 MLPerf 결과에서 전반적인 리더십을 계속 제공하는 NVIDIA Ampere 아키텍처 GPU보다 최대 4.5배 더 높은 성능을 제공합니다.

부분적으로는 트랜스포머 엔진 덕분에 Hopper는 자연어 처리를 위한 인기 있는 BERT 모델에서 탁월했죠. 이는 MLPerf AI 모델 중 가장 크고 성능이 필요한 모델 중 하나입니다.

이러한 추론 벤치마크는 올해 말에 출시될 H100 GPU의 첫 공개 데모입니다. H100 GPU는 훈련을 위해 향후 MLPerf 라운드에 참여할 예정입니다.

A100 GPU의 리더십

현재 주요 클라우드 서비스 제공업체와 시스템 제조업체에서 제공하는 NVIDIA A100 GPU는 최신 테스트에서 AI 추론의 주류 성능에서 전반적인 리더십을 계속 보여줬습니다.

A100 GPU는 데이터센터, 엣지 컴퓨팅 범주와 시나리오에서 제출된 것보다 더 많은 테스트를 통과했는데요. A100은 지난 6월에 MLPerf 교육 벤치마크에서도 전반적인 리더십을 발휘해 AI 워크플로 전반에 걸쳐 능력을 입증했습니다.

2020년 7월 MLPerf에서 데뷔한 A100 GPU는 NVIDIA AI 소프트웨어의 지속적인 개선 덕분에 성능이 6배 향상됐습니다.

NVIDIA AI는 데이터센터와 엣지 컴퓨팅에서 모든 MLPerf 추론 워크로드, 시나리오를 실행하는 유일한 플랫폼입니다.

다양한 성능이 필요한 사용자

NVIDIA GPU는 모든 주요 AI 모델에서 최고의 성능을 제공하는 능력으로 사용자를 돕습니다. 실제 애플리케이션은 일반적으로 다양한 종류의 많은 신경망을 사용하죠.

예를 들어, AI 애플리케이션은 사용자의 음성 요청을 이해하고, 이미지를 분류하고 추천한 다음, 인간 목소리로 음성 메시지로 응답을 전달할 수 있습니다. 이때 각 단계마다 다른 유형의 AI 모델이 필요하죠.

MLPerf 벤치마크는 컴퓨터 비전, 자연어 처리, 추천 시스템, 음성 인식 등 널리 사용되는 AI 워크로드와 시나리오를 다룹니다. 테스트를 통해 사용자는 신뢰할 수 있고 유연하게 구현할 수 있는 성능을 얻을 수 있습니다.

사용자는 정보에 입각한 구매 결정을 내리기 위해 테스트가 투명하고 객관적인 MLPerf 결과에 의존합니다. 벤치마크는 아마존(Amazon), Arm, 바이두(Baidu), 구글(Google), 하버드(Harvard), 인텔(Intel), 메타(Meta), 마이크로소프트(Microsoft), 스탠포드(Stanford)와 토론토 대학교(University of Toronto)를 포함한 광범위한 그룹의 지원을 받습니다.

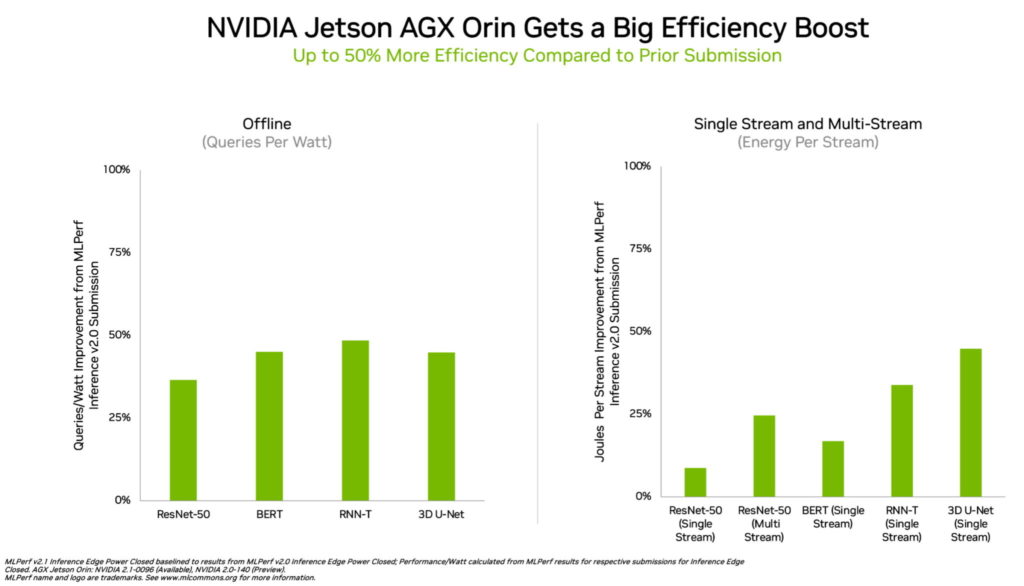

엣지에서 리드하는 Orin

엣지 컴퓨팅에서 NVIDIA Orin은 모든 MLPerf 벤치마크를 실행해 다른 어떤 저전력 시스템 온 칩(SoC)보다 더 많은 테스트를 통과했습니다. 그리고 지난 4월 MLPerf에서 처음으로 선보인 것보다 에너지 효율성이 최대 50% 향상됐죠.

이전 라운드에서 Orin은 이전 세대 Jetson AGX Xavier 모듈보다 최대 5배 더 빠르게 실행됐으며, 평균 두 배 더 나은 에너지 효율성을 제공했습니다.

Orin은 NVIDIA Ampere 아키텍처 GPU와 강력한 Arm CPU 코어 클러스터를 단일 칩에 통합합니다. 현재 NVIDIA Jetson AGX Orin 개발자 키트와 로보틱스 및 자율 시스템용 생산 모듈에서 사용할 수 있으며, 자율주행 차량(NVIDIA Hyperion), 의료 기기(Clara Holoscan)와 로보틱스(Isaac) 플랫폼을 포함한 전체 NVIDIA AI 소프트웨어 스택을 지원합니다.

광범위한 NVIDIA AI 생태계

MLPerf 결과에 따르면 NVIDIA AI는 머신 러닝 업계에서 가장 광범위한 생태계의 지원을 받고 있습니다.

이번 라운드에서 70개 이상의 제출물이 NVIDIA 플랫폼에서 실행됐습니다. 예를 들어 마이크로소프트 애저(Microsoft Azure)는 클라우드 서비스에서 NVIDIA AI를 실행한 결과를 제출했죠.

또한 이번 라운드에는 에이수스(ASUS), 델 테크놀로지(Dell Technologies), 후지쯔(Fujitsu), 기가바이트(GIGABYTE), 휴렛 팩커드 엔터프라이즈(Hewlett Packard Enterprise), 레노버(Lenovo), 슈퍼마이크로(Supermicro)를 포함한 10개의 시스템 제조업체에서 19개의 NVIDIA 인증 시스템이 등장했습니다.

이들의 작업은 사용자가 클라우드와 자체 데이터센터에서 실행되는 서버 모두에서 NVIDIA AI로 뛰어난 성능을 얻을 수 있음을 보여줍니다.

NVIDIA 파트너는 MLPerf가 AI 플랫폼과 공급업체를 평가하는 고객에게 유용한 도구라는 것을 알고 있기 때문에 MLPerf에 참여하는데요. 최신 라운드의 결과는 현재 사용자에게 제공되는 성능이 NVIDIA 플랫폼과 함께 성장할 것임을 보여줍니다.

이러한 테스트에 사용된 모든 소프트웨어는 MLPerf 저장소에서 사용할 수 있기 때문에 누구나 세계적 수준의 결과를 얻을 수 있습니다. 최적화는 GPU 가속 소프트웨어를 위한 NVIDIA 카탈로그인 NGC에서 사용할 수 있는 컨테이너로 계속 접혀집니다. 또한 AI 추론을 최적화하기 위해 이번 라운드의 모든 제출물에 사용되는 NVIDIA TensorRT도 찾을 수 있습니다.

NVIDIA 개발자 블로그에서 더 자세한 내용을 알아보세요.