NVIDIA는 오늘 개발자가 의료, 금융, 제조, 리테일 및 기타 모든 산업 분야의 상용 애플리케이션을 위한 거대 언어 모델(LLM)을 훈련하기 위한 합성 데이터를 생성하는 데 사용할 수 있는 개방형 모델 제품군인 Nemotron-4 340B를 발표했습니다.

고품질 학습 데이터는 맞춤형 LLM의 성능, 정확도 및 응답 품질에 중요한 역할을 하지만, 강력한 데이터 세트는 엄청나게 비싸고 접근하기 어려울 수 있습니다.

독특하게 허용되는 개방형 모델 라이선스를 통해 Nemotron-4 340B는 개발자에게 강력한 LLM을 구축하는 데 도움이 되는 합성 데이터를 무료로 확장 가능한 방식으로 생성할 수 있는 방법을 제공합니다.

Nemotron-4 340B 제품군에는 LLM의 훈련 및 개선에 사용되는 합성 데이터를 생성하는 파이프라인을 구성하는 기본, 인스트럭트 및 보상 모델이 포함되어 있습니다. 이 모델들은 데이터 큐레이션, 커스터마이징, 평가를 포함한 엔드투엔드 모델 트레이닝을 위한 오픈 소스 프레임워크인 NVIDIA NeMo와 함께 작동하도록 최적화되어 있습니다. 또한 오픈 소스 NVIDIA TensorRT-LLM 라이브러리를 사용한 추론에도 최적화되어 있습니다.

Nemotron-4 340B는 지금 NVIDIA NGC 카탈로그와 Hugging Face에서 다운로드할 수 있습니다. 개발자들은 곧 ai.nvidia.com에서 이 모델에 액세스할 수 있으며, 표준 애플리케이션 프로그래밍 인터페이스가 포함된 NVIDIA NIM 마이크로서비스로 패키징되어 어디서나 배포할 수 있게 될 것입니다.

합성 데이터 생성을 위한 Nemotron 탐색하기

LLM은 개발자가 대규모의 다양한 레이블이 지정된 데이터 세트에 대한 액세스가 제한된 시나리오에서 합성 훈련 데이터를 생성하는 데 도움이 될 수 있습니다.

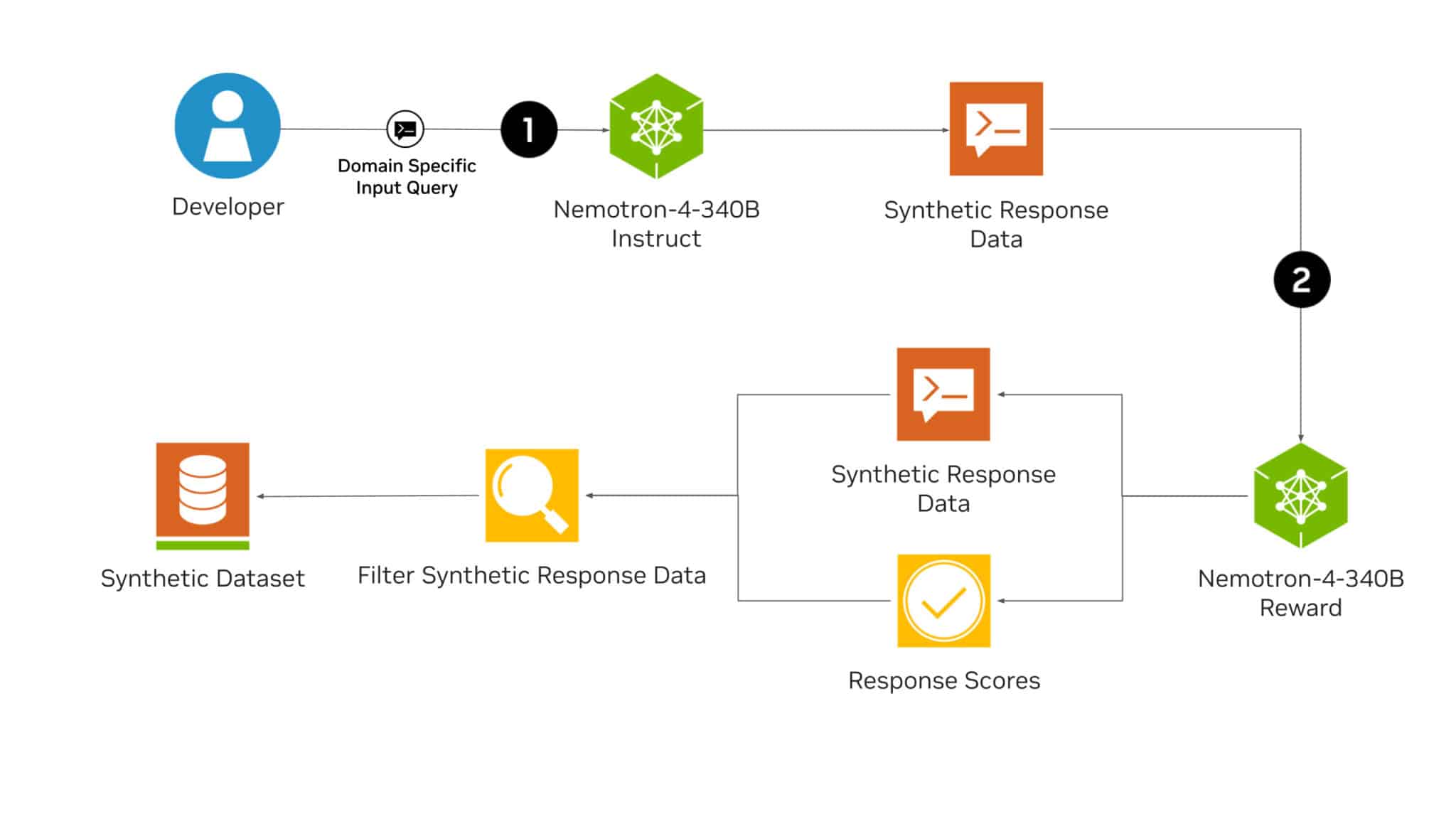

Nemotron-4 340B Instruct 모델은 실제 데이터의 특성을 모방한 다양한 합성 데이터를 생성하여 데이터 품질을 개선함으로써 다양한 도메인에서 맞춤형 LLM의 성능과 견고성을 높일 수 있도록 지원합니다.

그런 다음 개발자는 AI 생성형 데이터의 품질을 높이기 위해 Nemotron-4 340B Reward 모델을 사용하여 고품질 응답을 필터링할 수 있습니다. Nemotron-4 340B Reward는 유용성, 정확성, 일관성, 복잡성, 장황함의 다섯 가지 속성에 따라 응답의 등급을 매깁니다. 현재 AI2가 보상 모델의 기능, 안전성 및 함정을 평가하기 위해 만든 Hugging Face RewardBench 리더보드에서 1위를 차지하고 있습니다.

이 합성 데이터 생성 파이프라인에서는 (1) Nemotron-4 340B Instruct 모델이 먼저 합성 텍스트 기반 출력을 생성하는 데 사용됩니다. 그런 다음 평가자 모델인 (2) Nemotron-4 340B Reward가 이 생성된 텍스트를 평가하여 반복적인 개선을 안내하고 합성 데이터가 정확하고 관련성이 있으며 특정 요구사항에 부합하는지 확인하는 피드백을 제공합니다.

또한 연구자는 포함된 HelpSteer2 데이터 세트와 결합된 자체 데이터를 사용하여 Nemotron-4 340B 기본 모델을 사용자 지정하여 자체 지침 또는 보상 모델을 만들 수 있습니다.

NeMo를 통한 파인 튜닝, TensorRT-LLM을 통한 추론 최적화

개발자는 오픈 소스 NVIDIA NeMo 및 NVIDIA TensorRT-LLM을 사용하여 지시 및 보상 모델의 효율성을 최적화하여 합성 데이터를 생성하고 응답을 점수화할 수 있습니다.

모든 Nemotron-4 340B 모델은 개별 가중치 행렬을 여러 GPU와 서버에 분할하여 대규모로 효율적으로 추론할 수 있는 모델 병렬화의 일종인 Tensor 병렬화를 활용하도록 TensorRT-LLM으로 최적화되어 있습니다.

9조 개의 토큰으로 훈련된 Nemotron-4 340B Base는 특정 사용 사례나 도메인에 맞게 NeMo 프레임워크를 사용하여 사용자 정의할 수 있습니다. 이 파인 튜닝 프로세스는 광범위한 사전 학습 데이터를 활용하여 특정 다운스트림 작업에 대해 보다 정확한 결과물을 산출합니다.

감독형 파인 튜닝과 로우랭크 적응 또는 LoRA와 같은 파라미터 효율적인 파인 튜닝 방법 등 다양한 커스터마이징 방법을 NeMo 프레임워크를 통해 사용할 수 있습니다.

모델 품질을 향상시키기 위해 개발자는 NeMo Aligner와 Nemotron-4 340B Reward로 주석이 달린 데이터 세트를 사용하여 모델을 정렬할 수 있습니다. 얼라인먼트는 인간의 피드백을 통한 강화 학습(RLHF)과 같은 알고리즘을 사용하여 모델의 동작을 파인 튜닝하여 안전하고 정확하며 상황에 적합하고 의도한 목표와 일치하는 결과물을 보장하는 LLM 학습의 핵심 단계입니다.

프로덕션 환경에 대한 엔터프라이즈급 지원과 보안을 원하는 기업은 생성형 AI 파운데이션 모델을 위한 가속화된 효율적인 런타임을 제공하는 클라우드 네이티브 NVIDIA AI 엔터프라이즈 소프트웨어 플랫폼을 통해 NeMo 및 TensorRT-LLM에 액세스할 수도 있습니다.

모델 보안 평가 및 시작하기

Nemotron-4 340B Instruct 모델은 적대적 테스트를 포함한 광범위한 안전성 평가를 거쳤으며, 광범위한 위험 지표에서 우수한 성능을 보였습니다. 하지만 사용자는 합성적으로 생성된 데이터가 사용 사례에 적합하고 안전하며 정확한지 확인하기 위해 모델의 출력을 신중하게 평가해야 합니다.

모델 보안 및 안전성 평가에 대한 자세한 내용은 모델 카드를 참조하세요.

NVIDIA NGC 및 Hugging Face를 통해 Nemotron-4 340B 모델을 다운로드하세요. 자세한 내용은 모델 및 데이터 세트에 대한 연구 논문을 읽어보세요.

소프트웨어 제품 정보에 관한 공지를 참조하세요.