전 세계 곳곳에서 AI 팩토리가 등장하고 있습니다. 이 거대한 새로운 데이터 센터들은 단순히 웹페이지나 이메일 서비스를 위해 지어지는 것이 아니라, 그 자체로 ‘지능’을 학습하고 배포하기 위해 만들어진 것들인데요,

거대 인터넷 기업들은 고객들을 위해 클라우드 규모의 AI 인프라에 수십억 달러를 투자하고 있고, 수많은 기업들이 차세대 제품과 서비스를 탄생시킬 AI 파운드리 구축 경쟁에 뛰어들고 있습니다. 이 뿐만 아니라 최근에는 각국의 정부 역시 AI를 활용해 국민 맞춤형 의료, 언어 서비스를 실현하기 위해 투자를 아끼지 않고 있죠.

이제는 바야흐로 AI 팩토리 시대입니다. 새로운 시대에서는 새로운 규칙이 만들어지며, 배선부터가 이전의 인터넷과는 완전히 다릅니다. 기존의 하이퍼스케일 데이터 센터와는 전혀 다른 무언가가 나타나고 있죠. 수만에서 수십만 개의 GPU가 하나의 고성능 엔진으로 ‘단순히 조립’되는 수준이 아니라, 한 덩어리의 시스템처럼 ‘조율되고, 운영되며, 활성화’ 되는 것이 특징입니다. 그리고 이 조율(오케스트레이션)이야말로 AI 팩토리의 핵심이라 할 수 있죠.

이 거대한 데이터 센터는 이제 ‘컴퓨팅의 기본 단위’가 되었고, GPU들이 어떻게 연결되는지가 그 컴퓨팅 단위의 성능을 좌우합니다. 단일 네트워크 아키텍처로 감당할 수 있는 수준이 아니라, 최첨단 기술을 결합한 ‘레이어드 설계’가 필요합니다. 예컨대 한때 SF처럼 보였던 ‘코-팩키지드 옵틱(co-packaged optics)’ 기술 등입니다.

이 복잡함은 오류가 아니라 바로 특징이죠. AI 인프라는 기존의 모든 것과 빠르게 달라지고 있고, 만약 연결 방식을 재고하지 않는다면 결국 확장에 한계가 오게 되는데요, 네트워크 레이어를 잘못 설계하면 모든 시스템이 멈추고, 제대로 구축하면 엄청난 성능을 얻게 됩니다.

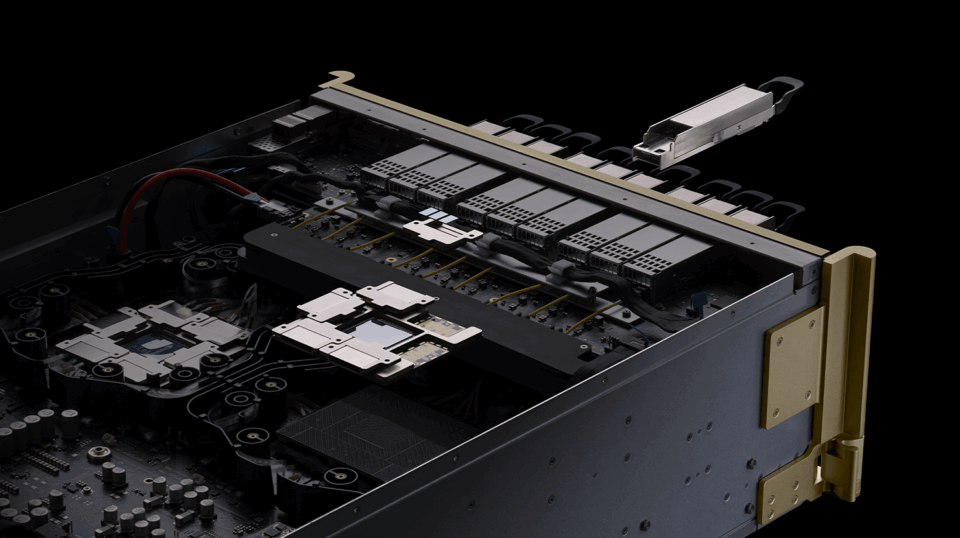

이러한 변화와 함께 실제로 ‘무게’도 따라오는데요, 10년 전만 해도 칩이란 세련되고 가벼운 것이 대세였습니다. 하지만 이제 최첨단 기술의 모습은 수백 파운드에 달하는 구리로 만든 서버랙의 중심축과 같습니다. 액체 냉각 매니폴드, 맞춤형 버스바, 구리 스파인(중심축) 등, AI는 이제 거대한 산업용 하드웨어를 요구하고 있습니다. 모델이 깊어질수록, 이러한 장비들은 점점 더 커지고, 확장되죠.

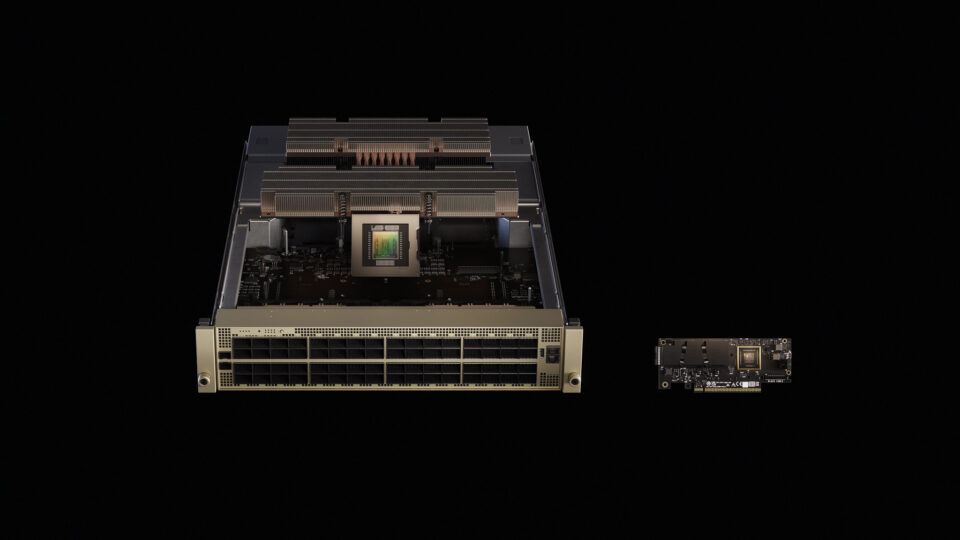

예를 들어, NVIDIA의 NVLink 스파인은 5,000개가 넘는 동축 케이블로 만들어져 있는데, 이들은 촘촘하게 감겨 정밀하게 배선됩니다. 이 NVLink는 초당 130TB의 GPU 간 대역폭을 제공하는데, 이는 사실상 인터넷 전체가 처리하는 데이터와 맞먹는 수준이죠. 이것은 GPU와 GPU가 완전히 메쉬(망상) 구조로 연결됩니다.

단순히 빠르다는 의미에 그치는 것이 아닙니다. AI의 ‘슈퍼 고속도로’가 이제 랙(rack) 내부에 존재하게 된 것입니다.

데이터 센터가 곧 컴퓨터

최신 대형 언어 모델(LLM)을 학습시키는 일은 단일 머신에서 연산을 반복하는 것이 아닙니다. 이 작업은 AI 연산의 핵심 역할을 하는 수십만 개에 달하는 GPU의 작업을 조율하는 것에 가깝죠.

이러한 시스템은 분산 컴퓨팅에 의존하는데요, 즉, 거대한 계산을 여러 노드(각각의 서버)에 분할하여, 각 노드가 전체 작업 일부를 담당하게 됩니다. 학습 과정에서는 그 ‘부분’들이, 보통은 대규모 행렬로 표현된 수치 데이터들이, 주기적으로 병합되고 갱신됩니다. 이 병합 작업은 “올리듀스(all-reduce)”(모든 노드의 데이터를 결합해 다시 분배하는 방식), “올투올(all-to-all)”(각 노드가 모든 다른 노드와 데이터를 교환)과 같은 집단 연산에 의해 이루어집니다.

이런 과정은 네트워크의 속도와 응답성, 즉 엔지니어들이 말하는 ‘지연 시간(latency)’과 ‘대역폭(bandwidth)’에 매우 민감한데요, 네트워크가 느리면 학습이 멈추거나 느려집니다.

추론, 즉 학습된 모델을 이용해 답변이나 예측을 생성하는 과정에서는 상황이 더 복잡합니다. 검색 기능을 결합한 ‘Retrieval-augmented generation(검색 증강 생성)’ 시스템에서는 실시간 조회와 응답이 필수입니다. 또한 클라우드 환경에서 여러 고객의 추론 작업을 격리해 동시에 처리하려면, 압도적으로 빠르고 대용량이며 완벽한 분리 환경을 보장하는 네트워크가 필요합니다.

전통적인 이더넷(Ethernet)은, 단일 서버 작업을 염두에 두고 설계된 네트워크였습니다. 약간의 전송 지연이나 불일치는 허용될 만했으나, 분산 AI에는 엄청난 병목이 된다. 이더넷 스위치의 기본 설계는 일관적이고 예측 가능한 성능을 목표로 하지 않았고, 이런 한계가 최신 설계에도 영향을 미칩니다.

분산 컴퓨팅에는 지터(jitter) 없는 확장형 인프라, 극한의 처리량 폭주와 예측 가능한 낮은 지연, 그리고 RDMA(원격 직접 메모리 접근) 성능을 일관적으로 보장하고 노이즈를 완벽히 격리할 수 있는 네트워크가 필요하다. 이 때문에 InfiniBand는 고성능 컴퓨팅과 AI 팩토리의 ‘표준’이 되어 왔다.

NVIDIA Quantum InfiniBand에서는 집단 연산이 네트워크 내에서 직접 실행됩니다. SHARP(Scalable Hierarchical Aggregation and Reduction Protocol) 기술로 감축 작업 시 데이터 대역폭을 두 배로 끌어올리죠. 또, 적응적 라우팅과 텔레메트리 기반 혼잡 제어로, 데이터 흐름을 경로 전체에 고르게 분산시키고, 결정론적 대역폭과 노이즈 격리를 보장합니다.

InfiniBand만의 이런 최적화로, AI 통신을 정밀하게 확장할 수 있으므로, 세계 최강의 슈퍼컴퓨터 TOP500 중 대다수가 NVIDIA Quantum 인프라로 연결되어 있습니다. 그리고 단 2년 만에 35% 성장이 이루어졌죠.

여러 개의 랙(rack)에 걸친 클러스터에는 NVIDIA Quantum‑X800 InfiniBand 스위치가 InfiniBand의 한계를 넘어서게 됩니다. 이 스위치는 800Gbps의 속도를 가진 144개 포트를 제공하며, 하드웨어 SHARPv4, 적응형 라우팅, 텔레메트리 기반 혼잡 제어를 지원합니다. ‘코-팩키지드 실리콘 포토닉스(co-packaged silicon photonics)’ 통합으로 전자와 광소자 간 거리를 최소화하여 전력 소비와 지연 시간을 줄입니다.

NVIDIA ConnectX-8 SuperNIC과 연동해 GPU당 800Gbps를 제공, 이 구조가 조 단위 파라미터 모델을 연결하고 네트워크 내 연산을 담당하게 됩니다.

다만 하이퍼스케일러와 대기업들은 이더넷 소프트웨어 인프라에 이미 수십억 달러를 투자하고 있는데요, 이들은 기존 생태계를 활용하면서도 AI 작업을 빠르게 도입할 수 있는 해법이 필요합니다. 여기서 탄생한 것이 바로, 분산 AI를 위해 설계된 새로운 형태의 이더넷인 NVIDIA Spectrum‑X입니다.

Spectrum‑X 이더넷: AI를 엔터프라이즈에 도입

Spectrum‑X는 AI를 위해 이더넷을 새롭게 재해석한 기술입니다. 2023년에 출시된 Spectrum‑X는 손실 없는 네트워킹, 적응형 라우팅, 그리고 성능 격리를 보여주죠. 그리고 Spectrum‑4 ASIC 기반의 SN5610 스위치는 최대 800 Gb/s의 포트 속도를 지원하며, NVIDIA의 혼잡 제어 방식으로 대규모 환경에서도 95%의 데이터 처리량을 유지합니다.

Spectrum‑X는 완전히 표준에 기반한 이더넷입니다. Cumulus Linux뿐만 아니라 오픈소스 SONiC 네트워크 운영체제도 지원해, 고객에게 더 유연한 선택지를 제공합니다. 핵심 요소는 NVIDIA BlueField-3 또는 ConnectX-8 기반의 SuperNIC입니다. 이 NIC는 최대 800 Gb/s의 RoCE(이더넷을 통한 원격 직접 메모리 접근) 연결을 제공하며, 패킷 재정렬과 혼잡 관리도 하드웨어에서 오프로드됩니다.

Spectrum‑X는 InfiniBand의 핵심 혁신 기술(텔레메트리 기반 혼잡 제어, 적응적 로드 밸런싱, 직접 데이터 플레이스먼트 등)을 이더넷에 접목해, 기업 고객이 수십만 개의 GPU까지 확장할 수 있게 해주는데요,

Spectrum‑X 기반의 대규모 시스템(세계 최대 규모 AI 슈퍼컴퓨터 등)은 95%의 데이터 처리량과 0의 애플리케이션 지연 저하를 실현해줍니다. 기존의 일반 이더넷 패브릭은 네트워크 흐름 충돌로 인해 약 60% 수준의 처리량만 가능한 점을 고려하면 엄청난 차이이죠.

확장과 확산을 위한 포트폴리오

어떤 한 가지 네트워크로는 AI 팩토리의 모든 계층을 아우를 수 없는데요, NVIDIA의 전략은 각 계층마다 딱 맞는 패브릭을 선택하고, 그 모든 것을 소프트웨어와 실리콘으로 매끄럽게 연결하는 데 있습니다.

NVLink: 랙 내부의 확장

서버 랙 안에서 GPU들은 마치 하나의 칩 안에 있는 여러 코어처럼 서로 긴밀하게 통신해야 합니다. NVIDIA NVLink와 NVLink 스위치는 여러 노드에 걸쳐 GPU의 메모리와 대역폭을 확장할 수 있도록 설계되었는데요,

예를 들어, NVIDIA GB300 NVL72 시스템에서는 36개의 NVIDIA Grace CPU와 72개의 NVIDIA Blackwell Ultra GPU가 하나의 NVLink 도메인으로 연결돼, 총 130TB/s의 대역폭을 구현합니다. 여기에 NVLink 스위치 기술이 더해지면, 단일 GB300 NVL72 시스템에서 130TB/s의 GPU 대역폭을 제공하고, 단일 8-GPU 서버 대비 9배 더 많은 GPU를 클러스터로 구성할 수도 있죠.

NVLink 덕분에 랙 전체가 하나의 거대한 GPU처럼 작동하게 됩니다.

포토닉스, 네트워킹의 새로운 도약

수백만 개 GPU를 아우르는 AI 팩토리로 가기 위해서는, 네트워크가 기존 플러그형 광학(optics)의 전력과 밀도 한계를 뛰어넘어야 합니다. NVIDIA Quantum-X와 Spectrum-X 포토닉스 스위치는 실리콘 포토닉스 기술을 스위치 패키지에 직접 통합해서, 800Gb/s 속도의 128~512 포트를 제공하고, 총 대역폭은 100Tb/s에서 400Tb/s까지 확장할 수 있죠.

이 스위치는 기존 옵틱스(Optics) 대비 3.5배 더 우수한 전력 효율, 10배 더 뛰어난 복원력을 자랑하면서, 기가와트급 AI 팩토리 시대를 현실로 만드는 기반이 되어줍니다.

오픈 스탠다드의 약속을 현실로

Spectrum‑X와 NVIDIA Quantum InfiniBand는 모두 오픈 스탠다드를 기반으로 만들어졌습니다. Spectrum‑X는 완전히 표준 이더넷 위에서 작동하며, SONiC 같은 오픈 이더넷 스택도 지원하죠.

그리고 NVIDIA Quantum InfiniBand와 Spectrum-X 모두 InfiniBand Trade Association의 인피니밴드와 RoCE(RDMA over Converged Ethernet) 규격을 준수합니다. NVIDIA의 핵심 소프트웨어 스택(NCCL, DOCA 등)도 다양한 하드웨어에서 구동될 수 있도록 설계됐고, Cisco, Dell Technologies, HPE, Supermicro 같은 파트너들은 자사 시스템에 Spectrum-X를 통합하고 있습니다.

오픈 스탠다드는 상호운용성의 기반을 만들어 주지만, 실전 AI 클러스터에서는 전체 스택(GPU, NIC, 스위치, 케이블, 소프트웨어)이 유기적으로 최적화되어야 강력한 성능이 나옵니다. 엔드-투-엔드 통합에 투자하는 벤더일수록 더 좋은 지연 및 처리량을 기대할 수 있습니다. SONiC처럼 초대규모 데이터센터에서 다져진 오픈소스 네트워크 운영체제는 라이선스 부담이나 벤더 종속 없이 자유롭게 커스터마이즈할 수 있게 해주지만, 실제로는 AI 성능 요구를 만족시키려면 여전히 최적화된 하드웨어와 소프트웨어 번들을 선택하는 경우가 많습니다.

결국 오픈 스탠다드만으로는 예측 가능하고 안정적인 성능이 나오지 않으니, 그 위에 혁신 기술이 꼭 더해져야 합니다.

수백만 GPU 시대를 향해

AI 팩토리의 규모는 점점 더 빠르게 커지고 있습니다. 유럽 각국 정부는 7개의 국가 AI 팩토리를 구축 중이고, 일본, 인도, 노르웨이의 클라우드 사업자들과 대기업들 또한 NVIDIA 기반의 AI 인프라를 속속 도입하고 있습니다. 이제 다음 목표는 무려 ‘기가와트급 설비와 수백만 개 GPU’가 들어가는 대형 시설인데요, 여기에 도달하기 위해서는, 기존처럼 네트워크를 단순한 부가 요소가 아니라 AI 인프라의 핵심 축(pillar)으로 바라보는 진화가 필요합니다.

기가와트 데이터 센터 시대가 던지는 핵심 교훈은 간단합니다. 이제는 데이터 센터 자체가 하나의 컴퓨터라는 거죠. NVLink가 랙 내에서 GPU들을 하나로 엮고, NVIDIA Quantum InfiniBand가 그 확장을 담당합니다. Spectrum-X는 이 고성능을 더 넓은 시장으로 확산시키고, 실리콘 포토닉스는 그 기반을 지속가능하게 만들어줍니다. 중요한 점은 모두 개방형 표준(Open)으로 연결되고, 성능이 필요한 부분은 확실하게 최적화되는 것, 이것이 앞으로의 AI 팩토리 시대를 이끌게 될 핵심입니다.