10 년 전 아마존 웹 서비스(AWS)의 첫 번째 GPU 기반 인스턴스가 NVIDIA M2050과 함께 처음 출시됐습니다. 당시에는 AI와 딥 러닝이 부상하기 한참 전이라 CUDA 기반 애플리케이션은 주로 과학 시뮬레이션 가속화에 초점을 맞추었는데요.

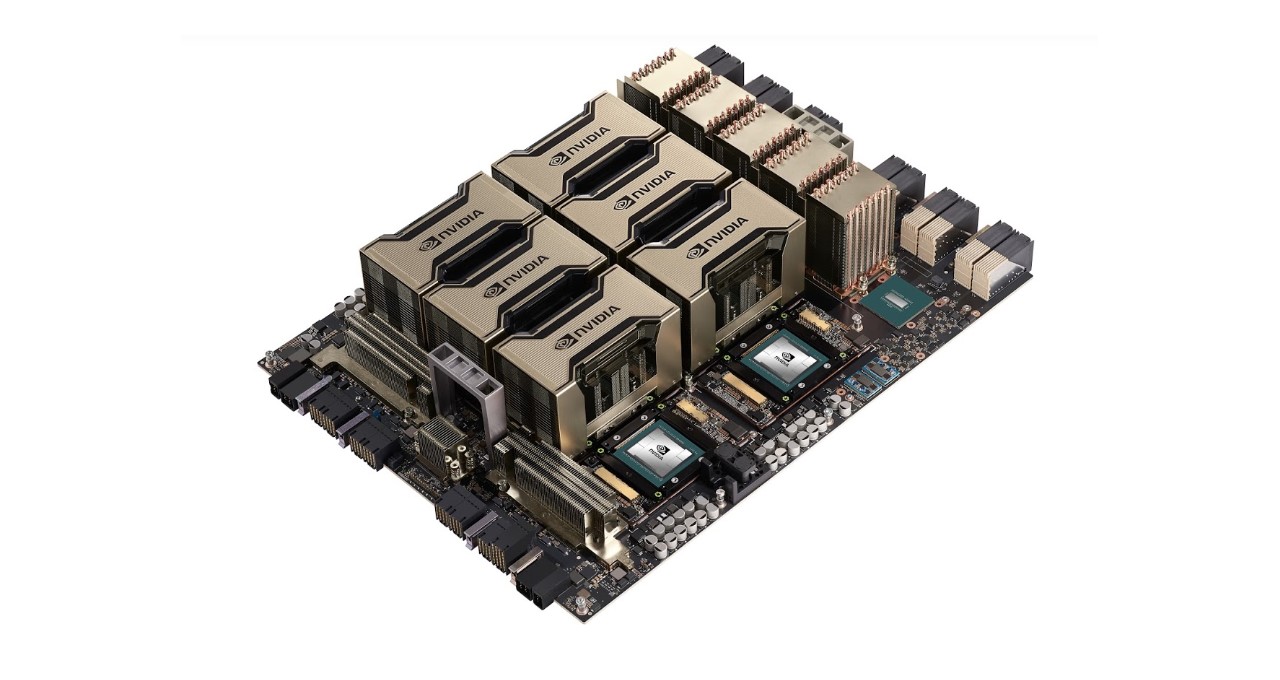

그 이후 AWS는 K80, K520, M60, V100 및 T4를 포함하는 안정적인 클라우드 GPU 인스턴스를 추가했습니다. 현재 상용화된 새로운 P4d 인스턴스를 통해 AWS는 최신 NVIDIA A100 Tensor Core GPU로 구동되는 가속 컴퓨팅의 또 다른 대담한 10년을 준비하고 있습니다.

새로운 P4d 인스턴스를 기반으로, 머신 러닝 및 고성능 컴퓨팅 애플리케이션을 지원하는 AWS의 GPU 기반 플랫폼이 탄생했습니다. 최고 성능과 비용 효율성을 제공하는 이 인스턴스는 FP16에서 최대 3배, TF32에서 최대 6배까지 머신 러닝 모델 훈련 시간을 단축합니다.

또한 뛰어난 추론 성능도 제공하는데요. 지난달 MLPerf 추론 벤치마크를 휩쓴 NVIDIA A100 GPU는 CPU보다 최대 237배 빠른 성능을 제공합니다.

각 P4d 인스턴스는 8 개의 NVIDIA A100 GPU를 탑재하며, AWS UltraClusters를 통해 고객은 AWS의 EFA(Elastic Fabric Adapter)를 사용하여 한 번에 4,000 개 이상의 GPU에 대한 온디맨드 및 확장 가능한 액세스를 얻을 수 있습니다. P4d는 400Gbps 네트워크를 제공하며 NVLink, NVSwitch, NCCL 및 GPUDirect RDMA와 같은 엔비디아 기술을 사용하여 딥러닝 학습 워크로드를 더욱 가속화합니다. EFA의 NVIDIA GPUDirect RDMA는 CPU와 시스템 메모리를 통과하지 않고도 서버 간 GPU에서 GPU로 데이터를 전달하여 저지연 네트워크를 보장합니다.

각 P4d 인스턴스는 8 개의 NVIDIA A100 GPU를 탑재하며, AWS UltraClusters를 통해 고객은 AWS의 EFA(Elastic Fabric Adapter)를 사용하여 한 번에 4,000 개 이상의 GPU에 대한 온디맨드 및 확장 가능한 액세스를 얻을 수 있습니다. P4d는 400Gbps 네트워크를 제공하며 NVLink, NVSwitch, NCCL 및 GPUDirect RDMA와 같은 엔비디아 기술을 사용하여 딥러닝 학습 워크로드를 더욱 가속화합니다. EFA의 NVIDIA GPUDirect RDMA는 CPU와 시스템 메모리를 통과하지 않고도 서버 간 GPU에서 GPU로 데이터를 전달하여 저지연 네트워크를 보장합니다.

또한 P4d 인스턴스는 Elastic Container Services, Elastic Kubernetes Service, AWS ParallelCluster 및 Amazon SageMaker를 포함한 AWS 소프트웨어를 활용합니다. 이 외에도 P4d 인스턴스는 HPC 애플리케이션, AI 프레임워크, 사전학습된 모델, Helm 차트 및 TensorRT와 Triton Inference Server 같은 추론 소프트웨어를 포함해 NGC에서 제공하는 최적화된 컨테이너형 소프트웨어를 모두 활용할 수 있습니다.

P4d 인스턴스는 현재 미국 동부와 서부에서 사용할 수 있으며, 곧 이용 가능 지역이 추가될 예정입니다. 인스턴스는 세이빙스 플랜(Savings Plans)과 예약 인스턴스(Reserved Instances)와 함께 온디맨드(On-Demand) 또는 스팟 인스턴스(Spot Instances)로 구매할 수 있습니다.

GPU 클라우드 컴퓨팅의 역사가 시작된 10년 동안 100 엑사플롭 이상의 AI 컴퓨팅이 시장에 출시되었습니다. NVIDIA A100 GPU로 구동되는 Amazon EC2 P4d 인스턴스의 출시와 함께 GPU 클라우드 컴퓨팅의 다음 10년이 힘차게 시작되었습니다.

NVIDIA와 AWS는 다양한 애플리케이션들이 AI의 경계를 계속 확장할 수 있도록 돕고 있습니다. 고객분들이 이를 활용해 어떠한 결과를 창출할지 무척 기대되네요!

지금 AWS를 방문하여 P4d instances를 시작하십시오.