NVIDIA가 음성, 추천 시스템, 하이퍼스케일 추론 등의 워크로드를 개선하기 위한 소프트웨어 스위트인 NVIDIA AI 플랫폼에 대한 주요 업데이트를 발표했습니다. 아마존(Amazon), 마이크로소프트(Microsoft), 스냅(Snap)과 같은 글로벌 업계 리더들이 이 소프트웨어를 채택하고 있습니다.

또한, NVIDIA의 소프트웨어 및 솔루션 파트너가 개발한 AI 애플리케이션의 성능과 신뢰성을 보장하는 NVIDIA AI 가속 프로그램도 발표했습니다. 이는 입증된 AI 가속 애플리케이션에 대한 가시성을 높여 기업이 NVIDIA AI 플랫폼에 안심하고 도입할 수 있도록 하죠. 어도비(Adobe), 레드햇(Red Hat), VMware는 출시 시점에 참여한 100개 이상의 파트너 중 하나입니다.

NVIDIA 설립자 겸 CEO인 젠슨 황(Jensen Huang)은 “NVIDIA AI는 AI 연구자와 데이터 사이언티스트부터 데이터 및 기계 학습 운영 팀에 이르는 전 세계 AI 커뮤니티의 소프트웨어 도구 상자입니다. GTC 2022에서 발표하는 내용은 아주 방대합니다. 보다 매력적인 챗봇과 가상 비서를 만들거나, 소비자가 더 나은 구매 결정을 내릴 수 있도록 도와주는 보다 스마트한 추천 시스템을 구축하거나, 대규모 AI 서비스를 조정하는 등 이러한 상황에서 필요한 것들이 바로 NVIDIA AI에 있습니다”라고 말했죠.

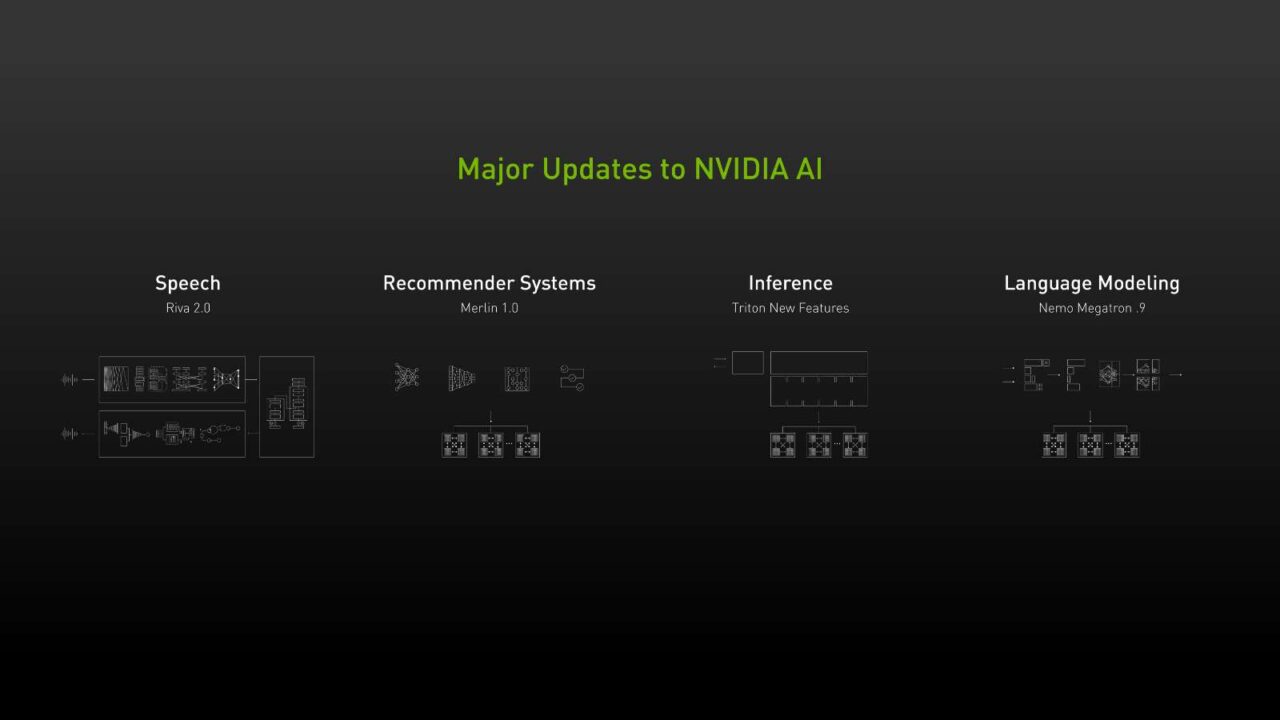

개발자가 자유롭게 이용할 수 있는 NVIDIA AI에는 음성 AI용 NVIDIA Riva와 스마트 추천용 NVIDIA Merlin이 포함됩니다. 모두 현재 정식 출시됐습니다. 또한 NVIDIA Triton, Nemo, Maxine 및 TAO Toolkit과 같은 도구를 포함하여 소프트웨어 제품군 전반에 걸쳐 업데이트가 진행됐습니다.

또한 NVIDIA AI Enterprise 2.0은 베어메탈 서버, 가상화 인프라스트럭처, CPU 전용 시스템 등 모든 주요 데이터센터 및 클라우드 플랫폼에서 최적화, 인증, 지원이 가능합니다. 이 제품군은 레드햇 오픈시프트(Red Hat OpenShift) 및 VMware vSphere 탄주(Tanzu)에서 지원됩니다.

업계 최고의 AI 애플리케이션을 구축하는 소프트웨어 도구

NVIDIA AI는 여러 노드에 걸친 AI 워크로드의 신속한 도입, 관리 및 확장을 가능하게 하는 주요 SDK와 툴로 구성되어, 복잡한 트레이닝과 머신 러닝 워크로드를 지원합니다. 다음 사항들이 포함됩니다:

- NVIDIA Triton – NVIDIA Triton은 범용 오픈 소스 하이퍼스케일 모델 추론 솔루션입니다. 최신 릴리스에는 최적화된 모델의 신속한 배포를 위한 모델 네비게이터, 쿠버네티스의 효율적인 확장을 위한 관리 서비스, 모든 애플리케이션에서 빠르고 최적화되고 확장 가능한 AI를 위한 설명 기능을 갖춘 트리(tree) 기반 모델에 대한 추론이 가능한 Forest Inference Library의 3가지 주요 업데이트가 포함됐습니다.

- NVIDIA Riva 2.0 – 세계 최고 수준의 음성 AI SDK로, 업계 최고 수준의 인식률로 사전 검증된 모델을 포함하고 있어 개발자가 일반 서비스보다 2배 높은 정확도로 실시간 음성 AI 애플리케이션을 사용자 정의할 수 있습니다. Riva 2.0은 7개 언어로 음성 인식 기능을 갖추고 있으며, 남성과 여성의 음성을 모두 지원하는 인간과 같은 딥 러닝 기반의 텍스트 투 스피치 기능과 NVIDIA TAO Toolkit을 통한 커스텀 튜닝 기능을 갖추고 있습니다. 또한 NVIDIA의 엔터프라이즈 지원을 포함한 유료 서비스인 NVIDIA Riva Enterprise도 발표했습니다.

- NVIDIA NeMo Megatron 0.9 – NeMo Megatron은 대규모 언어 모델(LLM)을 훈련하기 위한 프레임워크를 통해 연구자와 기업이 대화형 AI, 추천자 및 유전체학 등의 애플리케이션에 대해 수렴과 수조 개의 매개 변수까지 확장할 수 있도록 모든 모델의 훈련을 지원합니다. 최신 버전에는 엔드 투 엔드 개발과 교육 시간을 단축하고 클라우드 교육 지원을 추가하는 새로운 최적화 및 레시피가 포함돼 있습니다. NVIDIA 가속 컴퓨팅의 초기 LLM을 사용한 곳에는com, AI 스웨덴, 네이버, 플로리다 대학교 등이 있습니다.

- NVIDIA Merlin 1.0 – 두 개의 새로운 라이브러리인 Merlin Models과 Merlin Systems을 포함하는 고성능 추천기를 대규모로 구축하기 위한 가속화된 엔드 투 엔드 추천 AI 프레임워크입니다. 이를 통해 데이터 사이언티스트와 기계 학습 엔지니어는 사용 사례에 가장 적합한 기능과 모델을 결정하고 추천 파이프라인을 마이크로서비스로 배포할 수 있습니다.

- NVIDIA Maxine – AI와의 실시간 통신을 재창조하고 음향 반향 제거, 오디오 초해상도를 도입하는 오디오 및 비디오 품질 향상 SDK입니다. 두 가지 새로운 기능은 오디오 품질을 향상시켜 보다 선명한 커뮤니케이션 경험을 제공합니다.

고객들이 선택하는 NVIDIA AI

업계 선두업체들은 비용 효율성을 개선하고, 고객 만족도를 높이고, AI 애플리케이션 기능을 최적화하기 위해 NVIDIA AI를 사용합니다.

스냅(Snap)의 회화 AI 책임자인 앨런 베커(Alan Bekker)는 “스냅챗에서 우리 커뮤니티는 하루에 60억 번 이상 렌즈를 가지고 놉니다. 스냅은 NVIDIA Riva를 사용해 AI 베이스의 스피치 기능을 최적화하고, 이를 렌즈 스튜디오(Lens Studio) 크리에이터에게 제공하여 매력적인 신세대 AR 경험을 구축하고 있습니다”고 말했죠.

마이크로소프트(Microsoft)의 테크니컬 펠로우 및 애저(Azure) AI의 CTO인 슈에동 황(Xuedong Huang)은 “마이크로소프트 애저 코그니티브 서비스(Microsoft Azure Cognitive Service) 번역기의 문서 번역 기능은 원본 문서의 형식과 구조를 유지하며 문서를 번역해, 비즈니스 시 고객과 효율적으로 상호작용할 수 있도록 돕습니다. NVIDIA Triton을 통해 최신 Z-Code 모델을 활용해 지연 시간을 줄이고 문서의 번역 품질을 대폭 향상시켜, 사용자에게 타의 추종을 불허하는 뛰어난 번역 서비스를 제공할 수 있었습니다”라고 말했습니다.

NVIDIA AI 엔터프라이즈가 지원하는 데이터센터와 클라우드 전반에 걸친 컨테이너형 AI

엔드 투 엔드 클라우드 네이티브 AI 및 데이터 분석 도구 및 프레임워크 제품군인 NVIDIA AI Enterprise 2.0 소프트웨어 제품군은 산업을 위한 AI 개발과 배포를 가속화합니다. 업계 최고의 엔터프라이즈 쿠버네티스 플랫폼인 레드햇 오픈시프트에 대한 인증을 통해 고객은 컨테이너화된 머신 러닝 도구를 사용하여 VMware vSphere를 통해 베어메탈 또는 가상화된 시스템에서 모델을 보다 쉽게 구축, 확장 및 공유할 수 있죠.

레드햇의 파트너 에코시스템 성공 담당 수석 부사장인 스테파니 치라스(Stefanie Chiras)는 “NVIDIA AI Enterprise용 레드햇 오픈시프트 인증과 NVIDIA LaunchPad에서의 오픈시프트 제공은 AI 개발을 위한 최고의 툴을 일관된 하이브리드 클라우드 기반과 통합합니다. 이제 IT 팀과 데이터 사이언티스트가 레드햇 오픈시프트를 기반으로 NVIDIA AI를 구축 및 관리할 수 있습니다. 또한 기업이 운영 환경에서 인텔리전트 애플리케이션을 신속하게 제공할 수 있습니다”라고 언급했죠.

NVIDIA AI Enterprise 2.0은 훈련과 추론 지원을 위해 더 많은 NVIDIA AI 소프트웨어 컨테이너를 도입했습니다. 엔터프라이즈 개발자는 NVIDIA Tao Toolkit 지원을 통해 사전 훈련된 AI 모델을 미세 조정 및 최적화할 수 있으며, AI 전문 지식이나 대규모 훈련 데이터 없이도 생산 가능한 커스텀 모델을 쉽게 만들 수 있습니다. NVIDIA Inference Server의 최신 릴리스도 소프트웨어 스위트에 포함돼 있습니다.

NTT 그룹 내 정보통신 테크놀로지 솔루션을 제공하는 글로벌 프로바이더 NTT 커뮤니케이션스는 NVIDIA AI Enterprise를 채택해 NLP 및 인텔리전트 비디오 분석 애플리케이션 구축을 가속화하고 있습니다.

NTT 커뮤니케이션스 이노베이션 센터 테크놀로지 부문 디렉터인 쇼이치로 헨미(Shoichiro Henmi)는 “많은 애플리케이션 개발자가 현재 가속 컴퓨팅을 사용하고 있으며, 이들은 사용하기 쉽고 비용 효율적인 GPU 지원 환경을 제공하는 내부 인프라를 필요로 합니다. 우리는 NVIDIA AI Enterprise가 VMware vSphere, 쿠버네티스, 클라우드 인프라에서 대규모 개발을 지원하는 AI 지원 플랫폼으로서 이상적인 솔루션을 제공할 것이라고 확신합니다”라고 말했습니다.

고객은 시스코(Cisco), 델 테크놀로지(Dell Technologies), H3C, HPE(Hewlett Packard Enterprise), 인스퍼(Inspur), 레노버(Lenovo), 넷트릭스(Nettrix), 슈퍼마이크로(Supermicro) 등 NVIDIA GPU가 없는 주요 제조사의 동일한 서버 모델 또는 NVIDIA-Certified Systems에서 NVIDIA AI Enterprise를 실행할 수 있습니다.

기업 또한 전 세계 에퀴닉스(Equinix) 국제 비즈니스 거래소(IBM, International Business Exchange) 데이터센터를 배치할 수 있는데요. 구글 클라우드(Google Cloud)와 마이크로소프트 애저(Microsoft Azure) 등 글로벌 공급업체의 클라우드 인스턴스도 지원됩니다. NVIDIA AI Enterprise는 NVIDIA DGX 시스템에 포함돼 있습니다.

이용 정보

NVIDIA AI 소프트웨어 컬렉션은 NVIDIA Developer Program의 일부로 개발자에게 제공됩니다.

기업은 전 세계 9개의 에퀴닉스 IBX 데이터 센터에서 에퀴닉스 메탈 서비스를 통해 제공되는 호스팅 프로그램인 NVIDIA LaunchPad의 IT 팀과 AI 개발자를 위한 큐레이티드 랩에서 NVIDIA AI 소프트웨어를 무료로 체험할 수 있습니다. 새로운 LaunchPad 랩에는 Riva용 음성 AI 랩 뿐만 아니라 레드햇 오픈시프트, 탄주(Tanzu) 지원 VMware vSphere, TAO Toolkit 및 FIL 백엔드를 지원하는 Triton Inference Server가 포함돼 있습니다.