NVIDIA는 NVIDIA H100 Tensor Core GPU를 탑재한 새로운 제품 및 서비스를 출시합니다. 이 H100 GPU는 주요 파트너들과 함께 빠르게 증가하는 생성형 AI 트레이닝(generative AI training)과 추론의 수요에 대응하기 위한 세계에서 가장 강력한 AI용 GPU입니다.

오라클 클라우드 인프라스트럭처(Oracle Cloud Infrastructure)는 H100 GPU를 탑재한 새로운 OCI 컴퓨트 베어메탈 GPU 인스턴스(Compute bare-metal GPU instances)를 제한적으로 제공한다고 발표했는데요. 또한 아마존 웹 서비스(Amazon Web Services)는 아마존 EC2 P5 인스턴스의 EC2 울트라클러스터를 곧 발표할 예정입니다. 이는 최대 20,000개의 상호 연결된 H100 GPU까지 규모를 확장할 수 있죠. 이러한 소식들은 지난주 마이크로소프트 애저(Microsoft Azure)가 H100 가상 머신인 ND H100 v5에 대한 비공개 프리뷰를 발표한 데 이어 발표된 것입니다.

또한 메타(Meta)는 현재 AI 생산 및 연구팀을 위해 내부에 H100 기반 그랜드 테톤(Grand Teton) AI 슈퍼컴퓨터를 구축했습니다.

NVIDIA 창립자 겸 CEO 젠슨 황(Jensen Huang)은 GTC 2023 키노트에서 NVIDIA DGX H100 AI 슈퍼컴퓨터가 본격 생산 중이며, 곧 전 세계 기업들에게 제공될 것이라고 발표했습니다.

젠슨 황은 “생성형 AI의 놀라운 잠재력은 사실상 모든 산업에서 비즈니스 전략과 이를 달성하는 데 필요한 기술을 재구상하도록 영감을 주고 있습니다. NVIDIA와 파트너들은 우리가 생활하고, 일하고, 즐기는 방식을 근본적으로 변화시킬 애플리케이션을 개발하는 이들에게 세계에서 가장 강력한 AI 컴퓨팅 플랫폼을 제공하기 위해 빠르게 움직이고 있습니다”고 말했습니다.

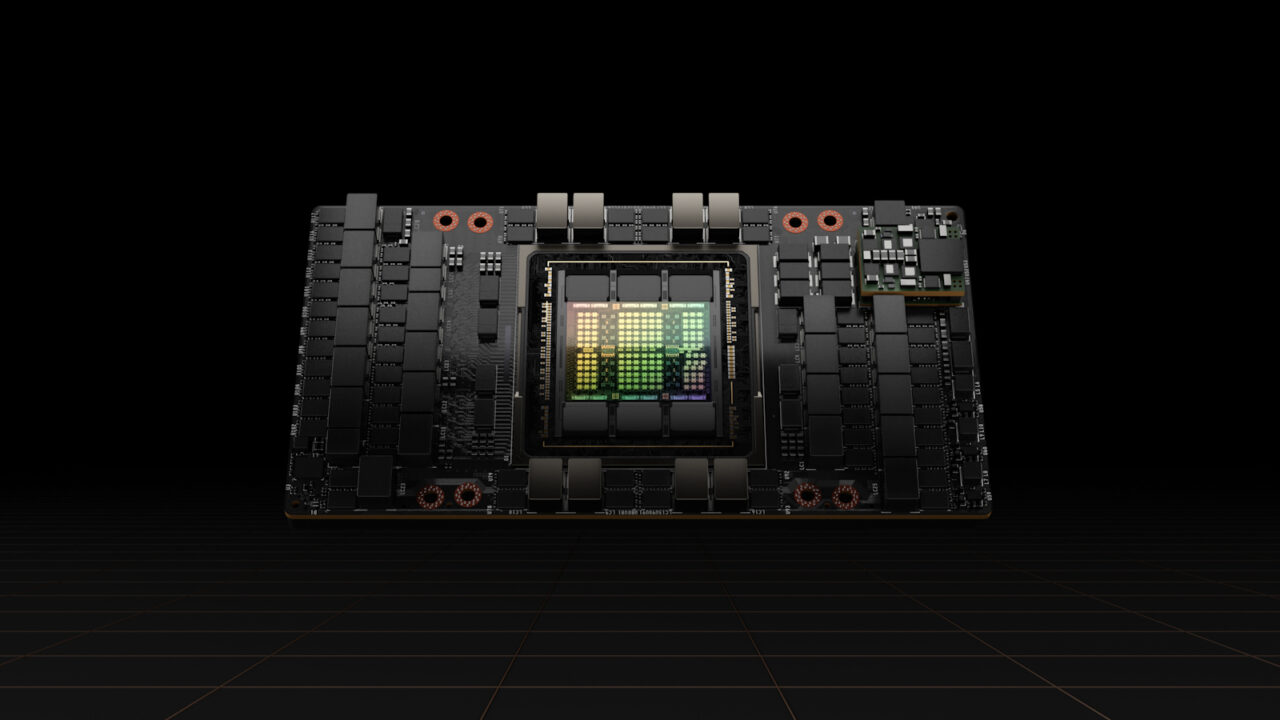

Hopper 아키텍처로 AI 가속화

H100은 트랜스포머 엔진(Transformer Engine)이 내장된 NVIDIA Hopper GPU 컴퓨팅 아키텍처를 기반으로 하며, 생성형 AI, 대규모 언어 모델(LLM)과 추천 시스템을 개발, 훈련, 배포하는 데 최적화돼 있습니다. 이러한 기술은 H100의 FP8 정밀도를 활용하며 이전 세대 A100에 비해 LLM에서 9배 빠른 AI 훈련과 최대 30배 빠른 AI 추론을 제공합니다. H100은 가을부터 글로벌 제조업체의 개별 및 일부 보드 단위로 출하되기 시작했습니다.

NVIDIA DGX H100은 NVIDIA NVLink 고속 인터커넥트로 연결된 8개의 H100 GPU와 통합된 NVIDIA Quantum InfiniBand 및 Spectrum 이더넷 네트워킹을 특징으로 합니다. 이 플랫폼은 이전 세대보다 2배 빠른 네트워킹으로 FP8 정밀도에서 32페타플롭(FPS)의 컴퓨팅 성능을 제공해 대규모 AI 워크로드를 처리할 때 에너지 효율성을 극대화하죠.

또한 DGX H100은 완전한 NVIDIA AI 소프트웨어 스택을 갖추고 있어, 기업이 대규모의 AI 워크로드를 원활하게 실행하고 관리할 수 있도록 지원합니다. 이 제품에는 별도로 발표된 최신 버전의 NVIDIA AI Enterprise와 NVIDIA Base Command가 포함됩니다. NVIDIA Base Command는 NVIDIA DGX 플랫폼 전체에서 AI 훈련 및 운영을 조정해 AI 개발을 간소화하고 효율화하는 DGX 데이터 센터의 운영 체제입니다.

AI 선구자들이 채택하는 H100

생성형 AI의 여러 선구자들이 작업 속도를 높이기 위해 H100을 도입하고 있습니다.

- 오픈 AI(Open AI)는 H100의 이전 버전인 NVIDIA A100 GPU를 사용해 대화에 최적화된 AI 시스템인 챗GPT(ChatGPT)를 훈련하고 실행했으며, 전 세계 수억 명의 사람들이 기록적인 속도로 사용했는데요. 오픈AI는 지속적인 AI 연구를 위해 애저(Azure) 슈퍼컴퓨터에서 H100을 사용할 예정입니다.

- NVIDIA의 핵심 기술 파트너인 메타(Meta)는 호스트-GPU 대역폭 4배, 컴퓨터 및 데이터 네트워크 대역폭 2배, 전력 엔벨로프 2배 등 이전 모델인 자이언(Zion)보다 여러 가지 성능이 향상된 Hopper 기반 AI 슈퍼컴퓨터 그랜드 테톤(Grand Teton) 시스템을 개발했습니다. 그랜드 테톤은 이러한 대규모 컴퓨팅 용량으로 딥 러닝 추천 모델과 콘텐츠 이해에 대한 훈련 및 생산 추론을 모두 지원할 수 있습니다.

- 텍스트-이미지 생성 AI의 선구자인 스터빌리티 AI(Stability AI)는 AWS의 H100 얼리 액세스 고객인데요. 스터빌리티 AI는 곧 출시될 비디오, 3D 및 멀티모달 모델을 가속화하기 위해 H100을 사용할 계획입니다.

- 기업과 개발자에게 멀티모달 비디오 이해에 대한 액세스를 제공하는 플랫폼인 트웰브랩스(Twelve Labs)는 OCI 슈퍼클러스터의 H100 인스턴스를 사용해 비디오를 즉각적이고 지능적이며 쉽게 검색할 수 있도록 계획하고 있습니다.

- AI 지원 스토리 작성 및 텍스트-이미지 합성을 위한 노벨AI(NovelAI) 앱의 제작자인 안라탄(Anlatan)은 모델 생성과 추론을 위해 코어위브(CoreWeave)의 클라우드 플랫폼에서 H100 인스턴스를 사용하고 있습니다.

전 세계 DGX H100

전 세계 혁신가들이 DGX H100 시스템의 첫 번째 물결을 맞이하고 있습니다.

- 일본에 본사를 둔 선도적인 디지털 광고 및 인터넷 서비스 회사인 사이버에이전트(CyberAgent)는 생성형 AI와 LLM 기술을 완전히 사용해 AI로 제작한 디지털 광고와 유명인 디지털 트윈 아바타를 제작하고 있습니다.

- 미국 최대 규모의 대학 부설 연구소인 존스홉킨스대학교 응용물리연구소(Johns Hopkins University Applied Physics Laboratory)는 LLM 교육에 DGX H100을 사용할 예정입니다.

- 스웨덴 스톡홀름에 위치한 유럽의 선도적인 기술 및 엔지니어링 대학인 KTH 왕립공과대학(Royal Institute of Technology)은 고등 교육을 위한 최첨단 컴퓨터 사이언스 프로그램을 제공하기 위해 DGX H100을 사용할 예정입니다.

- 에너지, 웰니스, IT, 통신 등의 분야에서 다양한 사업을 펼치는 일본의 선도적인 비즈니스 그룹 중 하나인 미쓰이(Mitsui)는 DGX H100을 탑재한 일본 최초의 신약 개발용 생성형 AI 슈퍼컴퓨터를 구축하고 있습니다.

- 에콰도르의 선도적인 통신 사업자인 텔코넷(Telconet)은 안전한 도시를 위한 지능형 비디오 분석과 스페인어를 사용하는 고객을 지원하기 위한 언어 서비스를 구축하고 있습니다.

생태계 지원을 받는 기업들의 한마디

“우리는 AI 혁신과 AI 우선 제품에 전적으로 집중하고 있습니다. NVIDIA H100 GPU는 최첨단 머신 러닝 가속기로, 모델 훈련에서 모델 추론에 이르는 다양한 애플리케이션을 위해 머신 러닝 업계에서 상당한 경쟁 우위를 확보할 수 있게 됐습니다.” — 안라탄(Anlatan) CEO, 에렌 도겐(Eren Doğan)

“AWS와 NVIDIA는 12년 이상 협력하면서 대규모의 비용 효율적인 GPU 기반 솔루션을 온디맨드 방식으로 제공해 왔습니다. AWS는 세대를 거듭할 때마다 확장성의 한계를 뛰어넘는 GPU 기반 인스턴스를 제공하는 데 있어 타의 추종을 불허하는 경험을 보유하고 있습니다. 오늘날 많은 고객들이 머신 러닝 트레이닝 워크로드를 10,000개 이상의 GPU로 확장하고 있습니다. 2세대 EFA를 통해 고객은 P5 인스턴스를 20,000개 이상의 H100 GPU로 확장해 모든 조직에 온디맨드 슈퍼컴퓨터 기능을 제공할 수 있습니다.” — AWS의 아마존 EC2 부문 부사장, 데이비드 브라운(David Brown),

“AI는 구글 클라우드에서 하는 모든 일의 핵심입니다. NVIDIA H100 GPU의 강력한 성능은 업계 최고의 AI 제품 및 서비스와 결합해 우리 고객들이 새로운 지평을 열 수 있도록 지원할 것입니다. NVIDIA와 협력해 기업들이 생성형 AI의 힘을 활용하려는 노력을 가속화할 수 있게 돼 기대가 큽니다.” — 구글 클라우드 시스템 및 서비스 인프라 부문 부사장, 아민 바닷(Amin Vahdat)

“생성형 AI를 기반으로 하는 등 새로운 AI 기반 경험을 구축함에 따라 기본 AI 모델은 점점 더 정교해지고 있습니다. 메타의 최신 H100 기반 그랜드 테톤 AI 슈퍼컴퓨터는 더 큰 컴퓨팅, 메모리 용량, 대역폭을 제공하여 오픈 소스 DLRM과 같은 메타의 AI 모델의 훈련과 추론을 더욱 가속화합니다. 차세대 컴퓨팅 플랫폼으로 전환함에 따라 H100은 메타의 미래 콘텐츠 추천, 생성형 AI, 메타버스 요구 사항을 연구하는 데 더 큰 컴퓨팅 기능을 제공합니다.” — 메타 인프라, AI 시스템 및 가속 플랫폼 부사장 알렉시스 비욜린(Alexis Bjorlin)

“AI 도입이 가속화됨에 따라 비즈니스 운영과 성공 방식이 근본적으로 변화하고 있습니다. NVIDIA의 Hopper 아키텍처를 마이크로소프트 애저에 도입하게 되면서, AI 기능을 확장하고자 하는 기업들에게 탁월한 컴퓨팅 성능과 기능을 제공할 수 있게 됐습니다.” — 마이크로소프트 클라우드 + AI 그룹 총괄 부사장 스캇 구스리(Scott Guthrie)

“NVIDIA H100 Tensor Core GPU의 컴퓨팅 성능은 AI 추론의 경계를 넓히기 위한 우리의 노력을 가능하게 하는 데 필수적입니다. NVIDIA의 발전은 GPT-4와 같은 시스템에 대한 우리의 연구와 조정 작업을 가능하게 합니다.” — 오픈AI 사장 겸 공동 창립자, 그렉 브록만(Greg Brockman)

“OCI는 모든 규모의 수천 개 조직에 대규모 AI 슈퍼컴퓨팅 기능을 제공하고 있습니다. NVIDIA와의 강력한 협력을 통해 고객에게 큰 가치를 제공하고 있으며, H100의 강력한 성능에 기대가 큽니다.” — 오라클 클라우드 인프라스트럭처의 CTO 겸 수석 부사장, 그렉 파블릭(Greg Pavlik)

“세계 최고의 오픈 소스 생성형 AI 모델 회사인 스터빌리티 AI는 소비자와 기업에 멀티모달 제작을 위한 세계 최고의 도구를 제공하기 위해 전념하고 있습니다. NVIDIA H100의 강력한 성능을 활용해 전례 없는 컴퓨팅 성능을 제공함으로써 생성형 AI의 혁신적인 힘을 활용하고자 하는 급증하는 사람들의 창의성과 연구 역량을 촉진할 수 있습니다. 엑사바이트 데이터를 위한 높은 상호 연결과 고급 아키텍처를 통해 비디오, 3D, 기타 모델에서 독보적인 이점을 누릴 수 있을 것입니다.” — 스터빌리티 AI의 창립자이자 CEO, 이마드 모스타크(Emad Mostaque)

“트웰브랩스는 NVIDIA H100 GPU 기반의 오라클 클라우드 인프라스트럭처 컴퓨트 베어메탈 인스턴스를 활용해 비디오 파운데이션 모델을 시장에 출시하는 데 앞장서게 되어 기쁘게 생각합니다.” — 트웰브랩스 CEO, 재 리(Jae Lee)

출시 정보

NVIDIA DGX H100 슈퍼컴퓨터는 현재 생산 중이며, 전 세계 NVIDIA 파트너사에서 주문할 수 있으며, 가격은 전 세계 NVIDIA DGX 파트너사에서 확인할 수 있습니다. 지금 바로 NVIDIA DGX Cloud를 통해 DGX H100을 체험해보세요.

클라우드의 NVIDIA H100은 현재 애저에서 발표한 비공개 프리뷰로, 오라클 클라우드 인프라스트럭처에서 제한된 가용성으로 제공되고 시라스케일(Cirrascale)과 코어위브(CoreWeave)에서 일반 버전으로 제공됩니다. AWS는 향후 몇 주 내에 H100을 제한된 프리뷰 버전으로 제공할 예정입니다. 구글 클라우드는 NVIDIA의 클라우드 파트너인 람다(Lambda), 페이퍼스페이스(Paperspace), 벌처(Vultr)와 함께 H100을 제공할 계획입니다.

NVIDIA H100 GPU가 탑재된 서버 및 시스템은 아토스(Atos), 시스코(Cisco), 델 테크놀로지스(Dell Technologies), 기가바이트(GIGABYTE), HPE(Hewlett Packard Enterprise), 레노버(Lenovo) 및 슈퍼마이크로(SuperMicro)를 비롯한 주요 서버 제조업체에서 구매할 수 있습니다.

가격, 기타 자세한 내용 등은 NVIDIA 파트너사로부터 직접 확인해보세요.

젠슨 황이 NVIDIA Hopper 아키텍처에 대해 설명하는 2023 GTC 키노트는 여기에서 다시 시청할 수 있습니다.