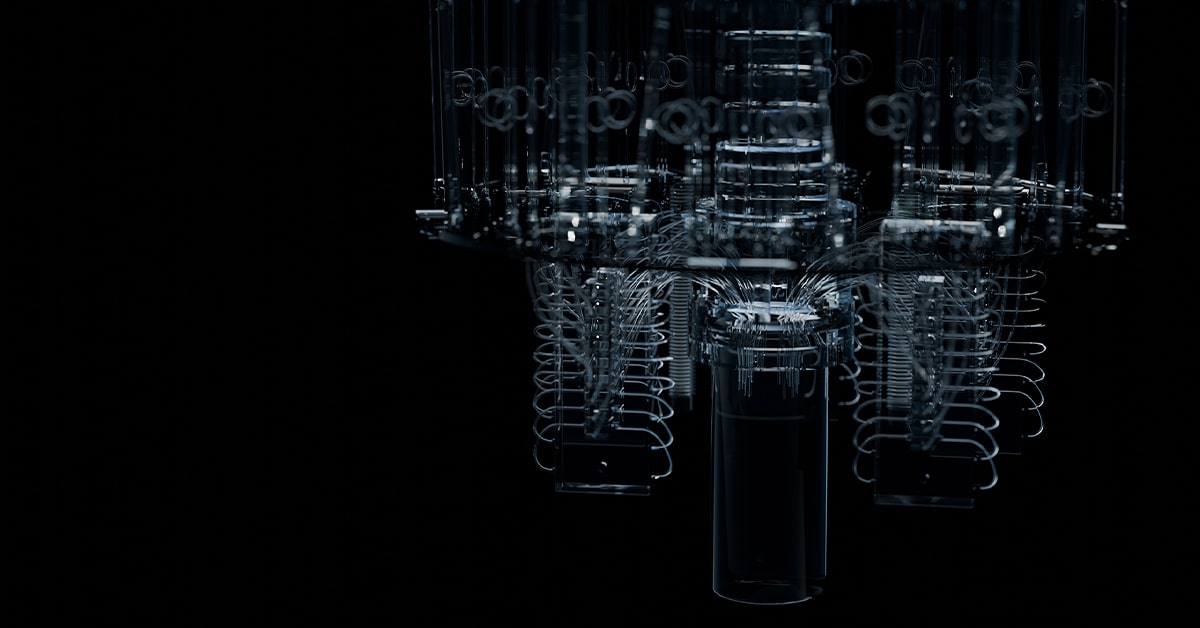

NVIDIA는 슈퍼컴퓨팅 2024(Supercomputing 2024, SC24) 콘퍼런스에서 구글 퀀텀 AI(Google Quantum AI)와 협력해 NVIDIA CUDA-Q™ 플랫폼 기반의 시뮬레이션으로 차세대 양자 컴퓨팅 장치 설계를 가속화하고 있다고 발표했습니다.

구글 퀀텀 AI는 하이브리드 양자-클래식 컴퓨팅 플랫폼과 NVIDIA Eos 슈퍼컴퓨터를 사용해 양자 프로세서의 물리학을 시뮬레이션하고 있습니다. 현재 양자 컴퓨팅 하드웨어는 ‘노이즈’라고 부르는 현상 때문에 계산을 중단해야 하는 특정 수의 양자 연산만 실행할 수 있는 어려움이 있는데요. 연구자들은 구글 퀀텀 AI를 통해 이러한 양자 컴퓨팅 하드웨어의 한계를 극복할 수 있습니다.

구글 퀀텀 AI의 연구 과학자 귀프레 비달(Guifre Vidal)은 “상업적으로 유용한 양자 컴퓨터의 개발은 노이즈를 억제하면서 양자 하드웨어를 확장할 수 있어야만 가능합니다. 우리는 NVIDIA 가속 컴퓨팅을 사용해 점점 더 커지는 양자 칩 설계의 노이즈 영향을 연구하고 있습니다”고 말했습니다.

양자 하드웨어 설계에서 노이즈를 이해하려면, 양자 프로세서 내의 큐비트와 환경의 상호작용 방식을 완벽하게 파악할 수 있는 복잡한 동적 시뮬레이션이 필요합니다.

이러한 시뮬레이션은 전통적으로 수행하기에 계산 비용이 매우 많이 소요됐죠. 하지만 이제 구글은 CUDA-Q 플랫폼을 사용하면, NVIDIA Eos 슈퍼컴퓨터에서 1,024개의 NVIDIA H100 Tensor 코어 GPU를 활용할 수 있습니다. 이를 통해 적은 비용으로 세계에서 가장 크고 빠른 양자 장치의 동적 시뮬레이션을 수행할 수 있죠.

NVIDIA HPC와 양자 컴퓨팅 부문 이사인 팀 코스타(Tim Costa)는 “AI 슈퍼컴퓨팅 성능은 양자 컴퓨팅의 성공에 도움이 될 것입니다. 구글의 CUDA-Q 플랫폼 사용은 GPU 가속 시뮬레이션이 양자 컴퓨팅을 발전시키고, 실제 문제를 해결하는 데 핵심적인 역할을 한다는 것을 보여줍니다”고 말했습니다.

CUDA-Q와 H100 GPU를 통해 구글은 40큐비트를 포함하는 장치에 대해 완전히 포괄적이고 사실적인 시뮬레이션을 수행할 수 있습니다. 이는 이러한 종류의 시뮬레이션 중 가장 큰 규모인데요. CUDA-Q가 제공하는 시뮬레이션 기술 덕분에 일주일이 걸리던 노이즈 시뮬레이션을 이제 단 몇 분 만에 실행할 수 있습니다.

이러한 가속 동적 시뮬레이션을 지원하는 소프트웨어는 CUDA-Q 플랫폼에서 공개적으로 제공될 예정이며, 양자 하드웨어 엔지니어는 시스템 설계를 빠르게 확장할 수 있습니다.