생성형 AI와 파운데이션 모델은 자율 머신이 훈련된 운영 설계 도메인을 넘어 일반화될 수 있도록 지원합니다. 이제 개발자와 연구자들은 토큰화, 거대 언어 모델(LLM), 확산 모델과 같은 새로운 AI 기술을 사용해 자율성을 가로막는 오랜 장애물을 해결할 수 있게 됐습니다.

이러한 거대 모델에는 훈련, 미세 조정, 검증을 위해 방대한 양의 다양한 데이터가 필요합니다. 하지만 야간에 자율주행 차량(AV) 앞을 지나가는 보행자나 용접 로봇 작업 셀에 사람이 들어가는 드문 상황과 잠재적으로 위험한 시나리오에서 이러한 데이터를 수집하는 것은 매우 어렵고 리소스 집약적일 수 있죠.

이러한 격차를 해소하기 위해 NVIDIA Omniverse Cloud Sensor RTX API는 대규모 데이터 세트 생성을 위한 물리적으로 정확한 센서 시뮬레이션을 지원합니다. 이 API는 카메라, 레이더, 라이더 등 자율주행에 일반적으로 사용되는 센서를 지원하도록 설계됐습니다. 또한, 기존 워크플로우에 원활하게 통합돼 모든 종류의 AV와 로봇 개발을 가속할 수 있죠.

현재 Omniverse Sensor RTX API는 얼리 액세스 형태로 일부 개발자에게 제공되고 있습니다. 액센츄어(Accenture), 포어텔릭스(Foretellix), 마이터(MITRE), 엠시티(Mcity)와 같은 기업들은 도메인별 블루프린트(blueprint)를 통해 이러한 API를 통합하는데요. 이를 통해 최종 고객에게 차세대 산업용 제조 로봇과 AV를 배포하는 데 필요한 도구를 제공하고 있습니다.

산업용 AI를 강화하는 Omniverse Blueprint

공장이나 창고와 같은 복잡한 환경에서 로봇은 기계, 인간 작업자와 안전하고 효율적으로 협력해야 합니다. 모든 움직이는 부품을 설계, 테스트, 검증할 때 중단을 피하면서 작업하는 것은 큰 도전 과제죠.

Mega는 기업에게 NVIDIA 가속 컴퓨팅, AI, NVIDIA Isaac, NVIDIA Omniverse 기술의 레퍼런스 아키텍처를 제공하는 Omniverse Blueprint입니다. 이를 사용해 기업은 디지털 트윈을 개발하고 로봇, 카메라, 장비 등을 구동하는 AI 기반 로봇 두뇌를 테스트해 엄청난 복잡성과 규모를 처리할 수 있습니다.

로봇 개발자는 Omniverse Blueprint를 통해 Omniverse Sensor RTX를 통합합니다. 공장에 있는 모든 유형의 지능형 기계에서 센서 데이터를 동시에 렌더링해 충실도 높은 대규모 센서 시뮬레이션을 수행할 수 있죠.

시뮬레이션에서 운영과 워크플로우를 테스트할 수 있는 기능을 통해 제조업체는 상당한 시간과 비용을 절감하고, 완전히 새로운 방식으로 효율성을 개선할 수 있습니다.

세계적인 공급망 솔루션 기업인 키온 그룹(KION Group)과 액센츄어는 Mega Blueprint를 사용해 산업용 AI의 로봇 두뇌를 위한 가상 훈련과 테스트 환경으로 활용되는 Omniverse 디지털 트윈을 구축하고 있습니다. 이들은 스마트 카메라, 지게차, 로봇 장비, 디지털 휴먼의 데이터를 활용하고 있죠.

로봇의 두뇌는 Omniverse Sensor RTX API로 렌더링된 물리적으로 정확한 센서 데이터로 시뮬레이션된 환경을 인식합니다. 로봇은 이 데이터를 사용해 계획하고 행동하며, 각 동작은 디지털 트윈의 모든 에셋의 상태, 위치와 함께 Mega로 정밀하게 추적됩니다. 이러한 기능을 통해 개발자는 새로운 레이아웃을 실제 세계에 구현하기 전에 지속적으로 구축하고 테스트할 수 있습니다.

자율주행 차량 개발과 검증

AV는 10년 이상 개발돼 왔지만, 적절한 훈련과 검증 데이터를 확보하는 데 있어 어려움이 있었으며 반복 주기가 느려 대규모 배포에 걸림돌이 있었습니다.

이러한 센서 데이터의 필요성을 해결하기 위해 기업들은 물리적으로 정확한 센서 시뮬레이션을 가능하게 하는 레퍼런스 워크플로우인 AV 시뮬레이션용 NVIDIA Omniverse Blueprint를 활용하고 있습니다. 이 워크플로우에서는 Omniverse Sensor RTX API를 사용해 AV 개발과 검증에 필요한 카메라, 레이더, 라이더 데이터를 렌더링합니다.

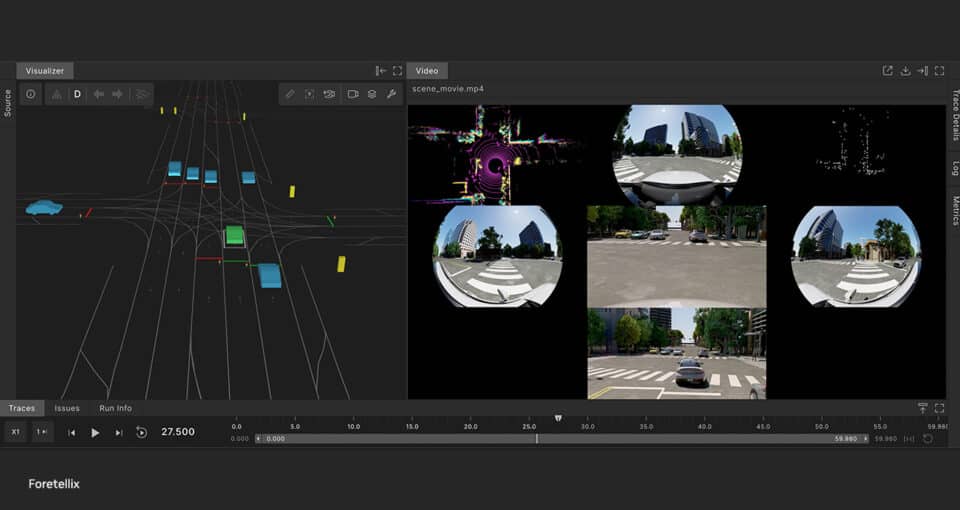

AV 툴체인 제공업체인 포어텔릭스는 이 Blueprint를 포어티파이(Foretify) AV 개발 툴체인에 통합해 객체 수준의 시뮬레이션을 물리적으로 정확한 센서 시뮬레이션으로 변환했습니다.

포어티파이 툴체인은 여러 테스트 시나리오를 동시에 생성할 수 있는데요. 이러한 시나리오에 센서 시뮬레이션 기능을 추가함으로써 개발자는 AV 개발의 완성도를 평가하고, 대규모의 안전한 배포를 달성하기 위해 필요한 수준의 충실도와 규모로 훈련과 테스트를 수행할 수 있습니다. 또한, 포어텔릭스는 새로 발표된 NVIDIA Cosmos 플랫폼을 사용해 검증과 검토를 위한 더 다양한 시나리오를 생성할 계획입니다.

뉴로(Nuro)는 미국에서 레벨 4를 가장 많이 배포한 자율주행 기술 제공업체로, 포어티파이 툴체인을 사용해 AV를 훈련하고 테스트하며 검증하고 있습니다.

또한, 연구 기관인 마이터는 미시간 대학교(The University of Michigan)의 엠시티 테스트 시설과 협력해 규제 용도의 디지털 AV 검증 프레임워크를 구축하고 있죠. 여기에는 32에이커 규모의 AV 시험장 엠시티의 디지털 트윈이 포함됩니다. 이 프로젝트는 AV 시뮬레이션 블루프린트를 사용해 가상 환경에서 물리적으로 정확한 센서 데이터를 대규모로 렌더링하며 훈련 효과를 높이고 있습니다.

로보틱스와 자율주행의 미래는 고충실도 센서 시뮬레이션의 힘 덕분에 더욱 주목받고 있습니다. 이번 CES에서 액센츄어와 포레텔릭스도 전용 부스에서 이러한 솔루션에 대해 자세히 알아볼 수 있는 자리를 마련했습니다.

CES에서 NVIDIA가 발표한 최신 오토모티브와 생성형 AI 기술에 대해 자세히 알아보세요.

소프트웨어 제품 정보에 관한 공지를 참조하세요.