오늘날 로보틱스, 자율주행 자동차, 스마트 공간의 핵심 기술인 피지컬 AI는 뉴럴 그래픽, 합성 데이터 생성, 물리 기반 시뮬레이션, 강화 학습, AI 추론의 조합을 활용합니다. 이는 최근 서로 융합되고 있는 AI와 그래픽 분야를 지난 20년간 선도해 온 NVIDIA Research 팀의 집단적 전문성과 완벽히 부합하죠.

NVIDIA Research팀의 전문가들은 캐나다 벤쿠버에서 열린 SIGGRAPH에서 스페셜 강연을 진행해, 피지컬 AI와 공간 AI를 가능하게 하는 그래픽과 시뮬레이션의 혁신을 강조했습니다.

NVIDIA의 AI Research팀의 부사장인 Sanja Fidler는 “AI는 시뮬레이션 역량을 발전시키고 있으며, NVIDIA의 시뮬레이션 역량은 AI 시스템을 발전시키고 있습니다. 두 분야 사이에는 진정하고 강력한 연결고리가 있으며, 이러한 조합은 흔하지 않습니다”고 말했습니다.

SIGGRAPH에서 피지컬 AI를 위한 새로운 소프트웨어 라이브러리도 공개했는데요. 여기에는 대규모 월드 재구성을 위한 NVIDIA Omniverse NuRec 3D 가우시안 스플래팅 라이브러리, 비전 AI를 위한 NVIDIA Metropolis 플랫폼의 업데이트, NVIDIA Cosmos와 NVIDIA Nemotron 추론 모델이 포함됩니다. Cosmos Reason은 피지컬 AI를 위한 새로운 추론 비전 언어 모델(vision language model, VLM)로, 로봇과 비전 AI 에이전트가 사전 지식, 물리 이해, 상식을 활용해 인간처럼 추론할 수 있도록 합니다.

이러한 혁신의 많은 부분은 NVIDIA의 글로벌 연구 팀이 이룬 획기적인 성과에 기반하고 있는데요, 이들은 이번 SIGGRAPH에서 차세대 피지컬 AI 도구 개발에 기여하는 뉴럴 렌더링, 실시간 패스 트레이싱, 합성 데이터 생성, 강화 학습 분야의 진전을 담은 12건 이상의 논문을 발표하기도 했습니다.

피지컬 AI가 그래픽과 AI, 로보틱스를 통합하는 방법

피지컬 AI 개발은 물리적으로 정확한 고해상도의 3D 환경 구축에서부터 시작됩니다. 이러한 현실감 있는 가상 환경이 없다면, 개발자들은 휴머노이드 로봇과 같은 고급 피지컬 AI 시스템을 시뮬레이션에서 훈련시킬 수 없죠. 왜냐하면 로봇이 가상훈련에서 습득한 기술은 현실 세계에 충분히 적용되지 않을 것이기 때문입니다.

예를 들어, 나무에서 복숭아를 따낼 때 과일을 손상시키지 않도록 정확한 압력을 사용하는 농업용 로봇이나, 밀리미터 단위의 정밀함이 요구되는 기계에서 미세한 전자 부품을 조립하는 제조 로봇을 상상해 볼 수 있습니다.

NVIDIA Research의 부사장인 Ming-Yu Liu는 “피지컬 AI는 현실과 같은 가상 환경이 필요합니다. 이는 로봇이 안전하게 시행착오를 통해 배울 수 있는 평행 우주와 같은 공간이죠. 이 가상 세계를 구축하려면 실시간 렌더링, 컴퓨터 비전, 물리적 동작 시뮬레이션, 2D와 3D 생성형 AI, 그리고 AI 추론이 필요합니다. 바로 NVIDIA Research가 거의 20년간 전문성을 쌓아온 분야입니다”라고 밝기도 했습니다.

2006년 연구 조직 설립 이래로 NVIDIA가 이뤄온 레이 트레이싱과 실시간 컴퓨터 그래픽 분야에서의 혁신적인 연구 성과는 피지컬 AI 시뮬레이션이 요구하는 현실감을 구현하는 데 결정적인 역할을 합니다. 이러한 렌더링 작업의 대부분은 AI 모델에 의해 구동되며, 이는 뉴럴 렌더링이라는 분야로 알려져 있습니다.

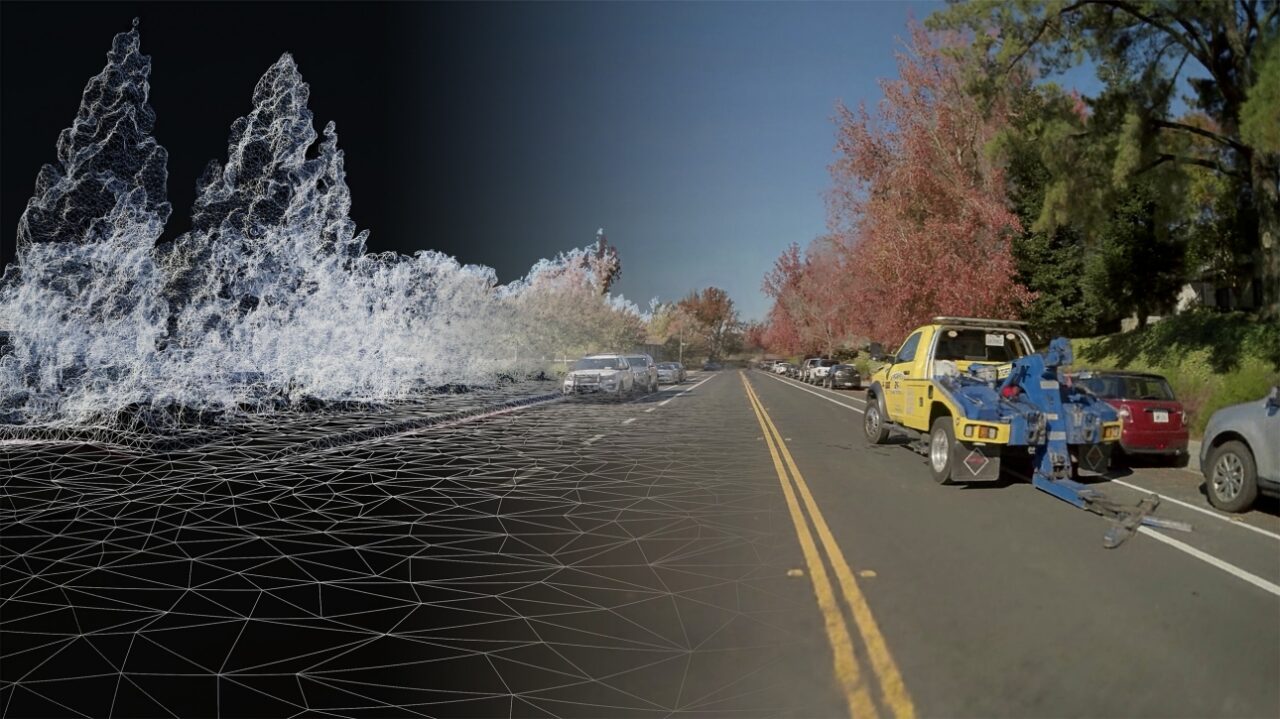

NVIDIA의 그래픽 연구 부사장 겸 리얼-타임 그래픽 Research((Real-Time Graphics Research) 그룹 책임자인 Aaron Lefohn은 “저희의 핵심 렌더링 연구는 고급 피지컬 AI 시스템을 훈련하는 데 사용되는 현실과 동일한 가상 세계의 창조를 촉진하며, 동시에 AI는 이미지에서 이러한 3D 세계를 생성하는 데 도움을 줍니다. 이제 누구나 촬영할 수 있는 대중적인 미디어 형태인 사진과 영상을 빠르게 가상 3D 환경으로 재구성할 수 있는 단계에 이르렀습니다”고 말했습니다.

이러한 기초 연구는 3D를 2D로 변환하는 포워드 렌더링(forward rendering)과 2D를 3D로 변환하는 역 렌더링(inverse rendering)입니다. 피들러의 스페이셜 인텔리전스 랩(Spatial Intelligence Lab)의 연구 성과를 포함한 물리적 동작 시뮬레이션 분야의 수년간의 연구와 기술 혁신으로 보완되는데요, 이 연구소는 최근 비디오 포즈 엔진(Video Pose Engine, ViPE)을 공개한 바 있습니다. 이는 Dynamic Vision Lab, NVIDIA Isaac 팀과 협력해 개발된 영상용 3D 기하학 주석 파이프라인입니다. 아마추어 녹화 영상, 대시캠 또는 영화 촬영 영상을 기반으로 카메라 움직임을 추정하고, 정밀한 깊이 맵을 생성하죠.

생성형 AI 분야에서는, NVIDIA Research 팀 중 하나인 Ming-Yu Liu의 Deep Imagination 그룹이 컴퓨터 비전, 트랜스포머, 비주얼 생성형 AI 모델을 선도하며 피지컬 AI 시스템이 월드의 미래 상태를 이해하고 예측할 수 있도록 하고 있습니다. 예를 들어, 차량이 적색 신호를 위반하거나 유리잔이 테이블 가장자리에 너무 가까이 있을 때 가능한 결과를 예측할 수 있죠.

이러한 이니셔티브는 올해 초 소개된 NVIDIA Cosmos 플랫폼의 기반을 마련했습니다. 이 플랫폼은 월드 파운데이션 모델(WFM), 사후 훈련 라이브러리, 가속화된 데이터 처리와 관리 파이프라인을 통해 피지컬 AI 개발을 가속화합니다.

SIGGRAPH에서의 NVIDIA Research

NVIDIA Research 팀은 시그라프에서 시뮬레이션, AI 기반 렌더링, 3D 콘텐츠 생성 분야의 최신 연구 성과를 발표했습니다. 가상 세계 생성, 로보틱스 개발, 자율주행 자동차 훈련 등에 적용될 수 있는 잠재 기술들이 있죠.

한 논문에서는 2D 이미지나 영상에서 물리 인지(physics-aware) 3D 형상을 재구성하는 과제를 다뤘습니다. 많은 모델이 영상 자료를 기반으로 3D 객체를 추정할 수 있지만, 생성된 3D 형상은 구조적 안정성이 부족한 경우가 많은데요. 실제 객체와 시각적으로 매우 유사하더라도 생성된 형상은 비율의 균형이 맞이 않거나 세부 사항이 누락돼 물리적 현실감이 떨어질 수 있습니다.

예를 들어, 2D 영상으로 제작된 의자의 3D 시뮬레이션은 물리적으로 정확한 시뮬레이션에 적용했을 때 무너질 수 있습니다. AI 모델은 실제 측정값이 아닌 3D 구조를 시각적 추정만으로 판단하기 때문이죠. 해당 논문에서 소개된 방법은 생성된 3D 형상이 실제 물리 현상을 반영하도록 해 이러한 문제를 방지하고, 피지컬 AI 훈련을 위한 가상 세계 생성을 지원합니다.

안정 상태(오른쪽)와 시뮬레이션(왼쪽).

의자 색상은 시뮬레이션된 기하학 구조의 응력 분포를 나타냅니다. 영상에서 관찰되는 떨림 현상은 최적화 과정의 각 반복 단계에서 적용된 무작위((random perturbation) 때문입니다.

또 다른 논문에서는 물리적으로 정확한 동작을 통해 시뮬레이션된 캐릭터에 생동감을 불어넣는 기술을 소개합니다. 연구진은 동작 생성기와 물리 기반 추적 컨트롤러를 결합해 파쿠르 선수들의 스턴트와 같은 복잡한 동작에 대한 사실적인 합성 데이터를 생성했죠.

이 데이터는 가상 캐릭터를 개발하거나 실제 휴머노이드 로봇을 훈련하는 데 도움이 될 수 있습니다. 실제 훈련 데이터에서는 거의 찾아볼 수 없는 민첩한 운동 능력을 갖추고 있죠. 또한, 긴급 대응을 지원하기 위해 험난한 지형을 가로지르는 작업과 같이 로봇이 수행할 수 있는 물리적 능력을 확대합니다.

파쿠르 같은 복잡한 동작에 대한 사실적인 합성 데이터 생성

또 다른 논문에서는 빛과 재료 시뮬레이션의 복잡성을 다루고 있습니다.

한 프로젝트는 예술가들이 재료의 디테일을 향상시키는 AI 어시스턴트를 만드는 방법을 보여주는데요. 이 프로젝트는 확산 모델과 미분 가능한 물리 기반 렌더러를 활용해 제작자가 3D 객체 표현 위에 재료 텍스처 맵을 쉽게 수정할 수 있도록 합니다. 이로써 간단한 텍스트 프롬프트로도 더욱 풍부하고 사실적인 가상 세계를 만들 수 있도록 하죠.

Research 팀은 이 모델을 사용해 풍화나 노화의 흔적과 같은 사실적인 객체 디테일을 빠르게 추가하는 방법을 시연했습니다. 이러한 디테일은 기존 렌더링 방식으로는 구현하는 데 시간이 오래 걸리는 작업인데요. 이러한 객체는 게임과 같은 창조적인 애플리케이션이나 시뮬레이션을 통한 로봇과 자율주행 자동차 훈련과 같은 물리적 애플리케이션에 사용되는 가상 환경에 구현될 수 있습니다.

풍화나 노화와 같은 사실적인 객체 디테일을 빠르게 추가하는 모델

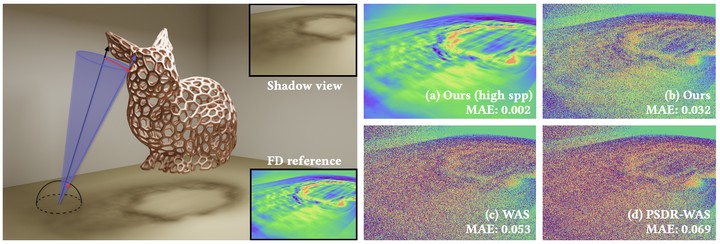

조명 시뮬레이션 분야에서 또 다른 시그라프 논문은 미분 가능 렌더링의 과제를 다룹니다. 이 논문에서는 이미지와 영상에서 3D 지오메트리를 더 빠르고 정확하게 재구성할 수 있는 강력한 미분 가능 가시성 쿼리를 소개하죠.

NVIDIA 연구진은 미분 가능 렌더러와 생성형 파운데이션 모델을 결합해 3D 콘텐츠 제작 AI 어시스턴트를 개발하고 있습니다.

이 논문은 NVIDIA Research가 포워드 렌더링과 역 렌더링을 결합해 가상 세계에서 합성 데이터 세트를 기반으로 피지컬 AI 모델을 정확하게 학습하는 데 필수적인 매개변수를 빠르게 추출한 사례입니다.

SIGGRAPH에서 진행된 피들러, 르폰, 류밍유의 스페셜 강연을 확인하고, 그래픽과 시뮬레이션 혁신이 불러오는 산업 디지털화에 대해 알아보세요.