편집자 노트: 본 게시물은 AI Decoded 시리즈의 일부로, AI에 대한 접근성을 높여 AI에 대한 이해를 돕고, RTX PC 사용자를 위한 새로운 하드웨어, 소프트웨어, 도구 및 가속 기술을 소개합니다.

게임 및 콘텐츠 제작 앱부터 소프트웨어 개발 및 생산성 도구에 이르기까지, 사용자 경험을 향상하고 효율성을 높이기 위해 AI가 점점 더 많은 애플리케이션에 통합되고 있습니다.

이러한 효율성 향상은 웹 브라우징과 같은 일상적인 작업으로까지 확대되었습니다. 개인정보 보호를 중시하는 웹 브라우저인 Brave는 최근 Leo AI라는 스마트 AI 어시스턴트를 출시했습니다. 이 어시스턴트는 검색 결과를 제공할 뿐만 아니라, 사용자가 콘텐츠를 요약하고 질문에 대한 답변을 찾을 수 있도록 도와줍니다.

Brave와 기타 여러 AI 기반 도구의 기반이 되는 기술은 AI의 고유한 요구에 맞게 최적화된 하드웨어, 라이브러리, 생태계 소프트웨어의 조합입니다.

소프트웨어가 중요한 이유

NVIDIA GPU는 데이터센터와 로컬 PC를 망라하여 전 세계의 AI를 구동합니다. 여기에는 대규모 병렬 연산 처리(AI에 필요한 엄청난 수의 계산을 한 번에 하나씩 수행하지 않고 동시에 빠르게 처리하는 것)를 통해 Leo AI와 같은 AI 애플리케이션을 가속화하도록 특별히 설계된 Tensor 코어가 포함되어 있습니다.

하지만 아무리 훌륭한 하드웨어라도 애플리케이션이 이를 효율적으로 사용할 수 없다면 의미가 없을 것입니다. 가장 빠르고 반응성이 뛰어난 AI 경험을 제공하려면 GPU 위에서 실행되는 소프트웨어도 마찬가지로 중요합니다.

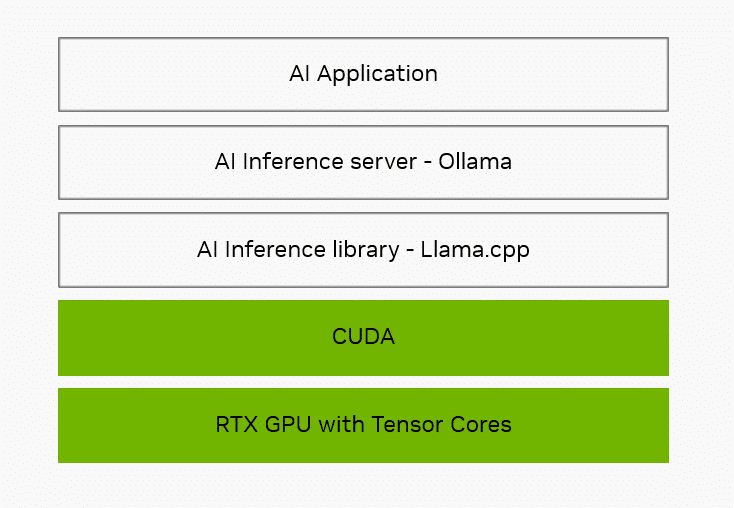

첫 번째 계층은 AI 추론 라이브러리로, 일반적인 AI 작업에 대한 요청을 받아 하드웨어가 실행할 수 있는 특정 명령어로 변환하는 번역기와 같은 역할을 합니다. 인기 있는 추론 라이브러리로는 NVIDIA TensorRT, Microsoft의 DirectML 그리고 Brave와 Leo AI가 사용하는 라이브러리인 llama.cpp 등이 있습니다.

Llama.cpp는 오픈 소스 라이브러리 및 프레임워크입니다. 개발자가 GeForce RTX 및 NVIDIA RTX GPU에 최적화하는 데 사용할 수 있는 NVIDIA 소프트웨어 애플리케이션 프로그래밍 인터페이스인 CUDA는 Gemma, Llama 3, Mistral, Phi와 같은 인기 있는 거대 언어 모델(LLM)을 비롯한 수백 개의 모델에 Tensor 코어 가속화를 제공합니다.

추론 라이브러리 외에도 애플리케이션은 통합을 간소화하기 위해 로컬 추론 서버를 사용하는 경우가 많습니다. 추론 서버는 애플리케이션이 수행할 필요가 없도록 특정 AI 모델을 다운로드하여 구성하는 등의 작업을 처리합니다.

Ollama는 llama.cpp의 상단에 배치되어 라이브러리의 기능에 대한 액세스를 제공하는 오픈 소스 프로젝트로, 로컬 AI 기능을 제공하는 애플리케이션 에코시스템을 지원합니다. NVIDIA는 RTX에서 더 빠르고 반응성이 뛰어난 AI 경험을 제공하기 위해 전체 기술 스택에서 Ollama 등의 도구를 NVIDIA 하드웨어에 최적화하고자 노력하고 있습니다.

하드웨어부터 시스템 소프트웨어, 그리고 애플리케이션이 더 빠르고 반응성이 뛰어난 AI 경험을 제공할 수 있도록 지원하는 추론 라이브러리 및 도구에 이르기까지 최적화를 위한 NVIDIA의 초점은 전체 기술 스택에 맞춰져 있습니다.

로컬 vs. 클라우드

Brave와 Leo AI는 클라우드에서 실행하거나 Ollama를 통해 PC에서 로컬로 실행할 수 있습니다.

로컬 모델을 사용하여 추론을 처리하는 데는 많은 이점이 있습니다. 처리를 위해 외부 서버로 프롬프트를 전송하지 않기 때문에 경험이 비공개로 유지되며 항상 사용 가능합니다. 또한 로컬로 실행하면 클라우드 액세스에 대한 비용을 지불할 필요가 없습니다. Ollama를 사용하면 동일한 AI 모델의 한두 가지 유형만 지원하는 대부분의 호스팅 서비스보다 더 다양한 오픈 소스 모델을 활용할 수 있습니다.

사용자가 이중 언어 모델, 소형 모델, 코드 생성 모델 등과 같이 다양한 전문성을 가진 모델과 상호 작용할 수도 있습니다.

RTX는 AI를 로컬로 실행할 때 빠르고 반응성이 뛰어난 경험을 지원합니다. llama.cpp와 함께 Llama 3 8B 모델을 사용하면 초당 최대 149개 토큰(초당 약 110개 단어)의 응답을 기대할 수 있습니다. Leo AI 및 Ollama와 함께 Brave를 사용하면 질문, 콘텐츠 요약 요청 등에 대해 더 스마트한 응답을 경험할 수 있습니다.

입력 시퀀스 길이가 100개 토큰인 Llama 3-8B 모델을 사용하는 경우 NVIDIA GeForce RTX GPU에서 100개 토큰을 생성하는 NVIDIA 내부 처리 성능 측정치입니다.

Leo AI 및 Ollama와 함께 Brave 시작하기

Ollama는 쉽게 설치할 수 있습니다. 프로젝트의 웹사이트에서 설치 프로그램을 다운로드하여 백그라운드에서 실행하면 됩니다. 명령 프롬프트로 지원되는 다양한 모델을 다운로드하여 설치한 다음, 명령줄을 통해 로컬 모델과 상호 작용할 수 있습니다.

Ollama를 통해 로컬 LLM 지원을 추가하는 방법에 대한 간단한 지침은 회사의 블로그를 참조하세요. Ollama를 사용하도록 구성하면, Leo AI는 프롬프트와 쿼리를 위해 로컬에 호스팅된 LLM을 사용합니다. 사용자는 언제든지 클라우드 모델과 로컬 모델 간에 전환할 수 있습니다.

개발자는 NVIDIA 기술 블로그에서 Ollama 및 llama.cpp를 사용하는 방법에 대해 자세히 알아볼 수 있습니다.

생성형 AI는 게임, 화상 회의 및 모든 종류의 인터랙티브 경험을 혁신하고 있습니다. AI Decoded 뉴스레터를 구독하고 새로운 소식을 확인하세요.