수십억 개 토큰 규모의 데이터 세트로 훈련된 거대 언어 모델(LLM)은 고품질 콘텐츠를 생성할 수 있습니다. 이 모델은 챗봇, 어시스턴트, 코드 생성기 등 다양한 인기 AI 애플리케이션의 핵심 기술로 활용되고 있습니다.

오늘날 LLM을 쉽게 활용하는 방법 중 하나는 AnythingLLM을 이용하는 것입니다. 이 앱은 개인 정보 보호를 중시하는 올인원 방식의 AI 어시스턴트를 PC에서 직접 활용하고자 하는 열성적인 사용자들을 위해 만들어졌는데요,

NVIDIA GeForce RTX 및 NVIDIA RTX PRO GPU에서 NVIDIA NIM 마이크로서비스가 새롭게 지원되면서, AnythingLLM 사용자는 더욱 빠른 성능과 민첩하게 반응하는 로컬 AI 워크플로우를 경험할 수 있습니다.

AnythingLLM이란 무엇인가요?

AnythingLLM은 사용자가 로컬 LLM, 검색 증강 생성(RAG) 시스템, 에이전트 도구를 실행할 수 있는 올인원 AI 애플리케이션입니다.

이 애플리케이션은 사용자가 선호하는 LLM과 데이터 사이의 연결 고리 역할을 하며, 스킬이라고 불리는 도구들을 활용할 수 있도록 지원하여 다음과 같은 특정 작업에 LLM을 더 간편하고 효율적으로 사용할 수 있게 해줍니다.

- 질문 답변: Llama, DeepSeek R1과 같은 최고 수준의 LLM을 통해 비용 부담 없이 질문에 대한 답변을 받을 수 있습니다.

- 개인 데이터 쿼리: RAG를 사용하여 PDF, Word 파일, 코드베이스 등의 콘텐츠를 비공개로 쿼리할 수 있습니다.

- 문서 요약: 연구 논문과 같은 긴 문서를 요약본 형태로 생성할 수 있습니다.

- 데이터 분석: 파일을 불러오고 LLM으로 분석하여 데이터와 관련된 핵심 정보를 추출할 수 있습니다.

- 에이전트 기반 작업: 로컬 또는 원격 리소스를 사용하여 동적으로 콘텐츠를 검색하고, 사용자 프롬프트에 따라 생성형 도구와 작업을 실행합니다.

AnythingLLM은 다양한 오픈 소스 로컬 LLM뿐만 아니라, OpenAI, Microsoft, Anthropic 등이 제공하는 클라우드 기반 대규모 LLM에 연결할 수 있습니다. 또한 이 애플리케이션은 커뮤니티 허브를 통해 에이전틱 AI 기능을 확장할 수 있는 스킬 활용을 지원합니다.

원클릭 설치가 가능하고, 독립 실행형 앱이나 브라우저 확장 프로그램으로 실행할 수 있는 AnythingLLM은 복잡한 설정 없이 직관적인 경험을 제공하며, AI 애호가, 특히 GeForce RTX 및 NVIDIA RTX PRO GPU 장착 시스템을 사용하는 사용자에게 매우 유용한 옵션입니다.

RTX, AnythingLLM 가속화 실현

GeForce RTX 및 NVIDIA RTX PRO GPU는 AI 가속에 특화된 Tensor 코어를 활용해 추론 속도를 높이며, AnythingLLM에서 LLM과 에이전트를 실행할 때 뛰어난 성능을 발휘합니다.

AnythingLLM은 Ollama를 통해 LLM을 장치 내에서 실행하며, 이 과정은 머신 러닝용 Llama.cpp와 ggml 텐서 라이브러리를 통해 가속화됩니다.

Ollama, Llama.cpp, GGML은 NVIDIA RTX GPU 및 5세대 Tensor 코어에 최적화되어 있습니다. GeForce RTX 5090은 Apple M3 Ultra 대비 2.4배 더 뛰어난 성능을 보여줍니다.

GeForce RTX 5090은 AnythingLLM 실행 시, Llama 3.1 8B 및 DeepSeek R1 8B 모두에서 Apple M3 Ultra 대비 2.4배 빠른 LLM 추론 성능을 제공합니다.

NVIDIA가 점차 확장되고 있는 AI Blueprint 라이브러리와 같은 새로운 NIM 마이크로서비스와 레퍼런스 워크플로우를 추가함에 따라, AnythingLLM과 같은 도구는 더욱 다양한 멀티모달 AI 사용 사례를 구현하는 데 중요한 역할을 하게 될 것입니다.

AnythingLLM — 이제 NVIDIA NIM 기술 지원

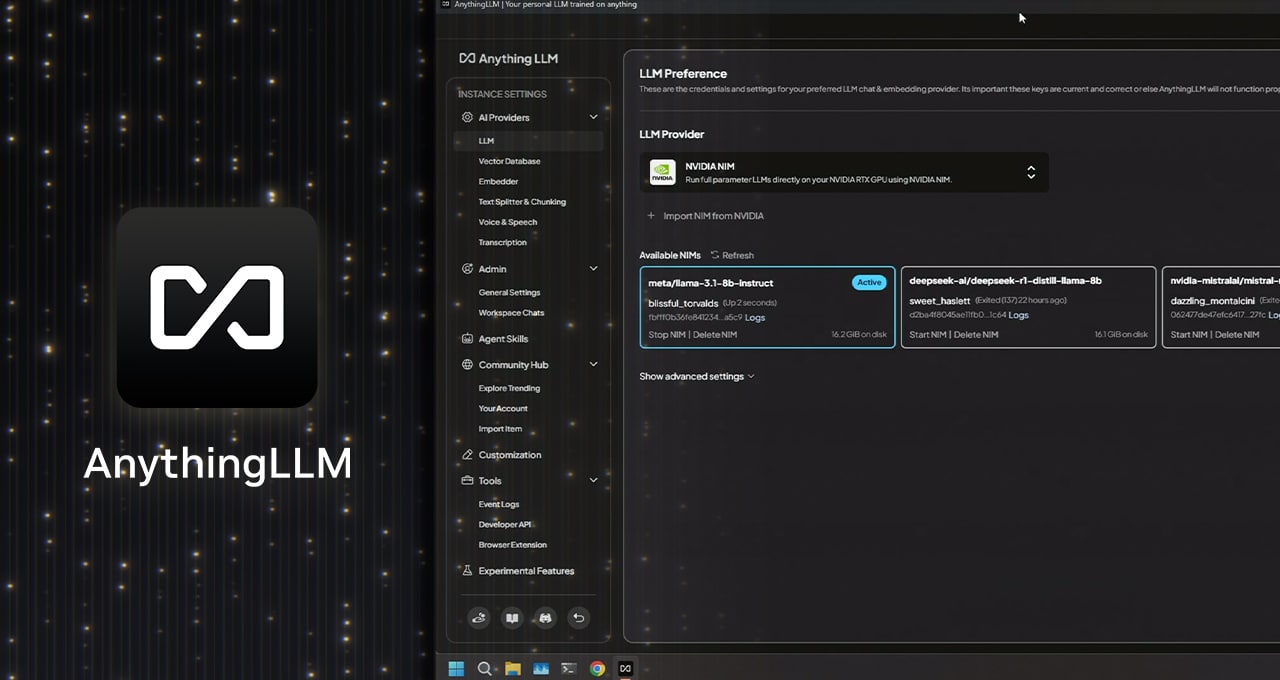

AnythingLLM은 최근 NVIDIA NIM 마이크로서비스 지원을 새롭게 추가했습니다. 이제 성능 최적화된 사전 패키지형 생성형 AI 모델과 간소화된 API를 통해 RTX AI PC에서 AI 워크플로우를 손쉽게 시작할 수 있습니다.

NVIDIA NIM은 워크플로우에서 생성형 AI 모델을 신속하게 테스트하려는 개발자에게 이상적입니다. 적합한 모델을 찾고 모든 파일을 다운로드하여 연결 방법을 알아내는 대신, 필요한 모든 것을 갖춘 단일 컨테이너를 제공합니다. 또한 클라우드와 PC 모두에서 실행 가능하여, 로컬에서 프로토타입을 간편하게 제작한 후 클라우드에 배포할 수 있습니다.

AnythingLLM의 사용자 친화적인 UI 내에서 이 NIM을 제공하여, 사용자들은 더욱 신속하게 테스트하고 실험할 수 있습니다. 그런 다음 AnythingLLM을 사용하여 해당 워크플로우에 연결하거나, NVIDIA AI Blueprint 및 NIM 문서와 샘플 코드를 활용하여 보유한 앱이나 프로젝트에 직접 연결할 수 있습니다.

언어 및 이미지 생성, 컴퓨터 비전, 음성 처리 등의 AI 기반 워크플로우를 강화할 수 있는 다양한 NIM 마이크로서비스에 대해 알아보세요.

매주 게재되는 RTX AI Garage 시리즈는 NIM 마이크로서비스 및 AI Blueprint에 대해 자세히 알아보고 AI PC와 워크플로우 스테이션에서 AI 에이전트, 크리에이티브 워크플로우, 디지털 휴먼, 생산성 앱 등을 구축하기를 원하는 사람들을 위해 커뮤니티 기반 AI 혁신과 콘텐츠를 제공합니다.

Facebook, Instagram, TikTok, X에서 NVIDIA AI PC에 대해 알아보고 RTX AI PC 뉴스레터를 구독하여 최신 정보를 받아보세요.

또한 LinkedIn과 X에서 NVIDIA 워크플로우 스테이션 채널도 팔로우하세요.

소프트웨어 제품 정보는 공지를 참조해 주세요.