NVIDIA GeForce RTX 5090, 5080 GPU는 획기적인 NVIDIA Blackwell 아키텍처를 기반으로 설계됐습니다. Blackwell 아키텍처는 새로운 DLSS Multi Frame Generation을 지원해 렌더링된 프레임당 최대 3개의 프레임을 생성하는 AI를 사용해 FPS를 향상시킵니다. 이 GPU들은 NVIDIA DLSS 4 기술로 최대 8배 빠른 프레임 속도, NVIDIA Reflex 2로 낮은 지연 시간, NVIDIA RTX 뉴럴 셰이더(neural shader)로 향상된 그래픽 충실도를 제공합니다.

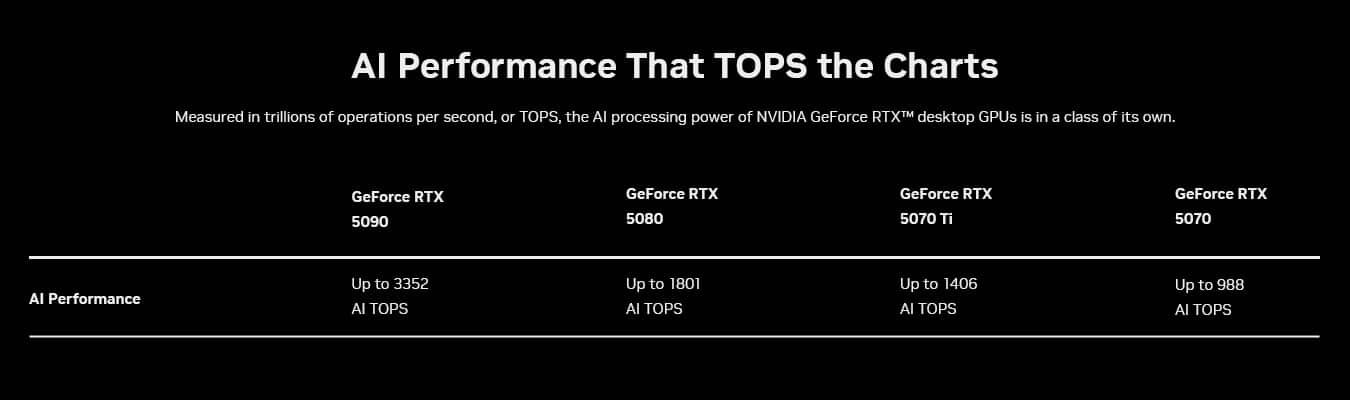

또한, 이들은 최신 생성형 AI 워크로드를 가속화하기 위해 제작됐습니다. 초당 최대 3,352조 개의 AI 연산(TOPS)을 처리하는 한편, 5세대 Tensor 코어와 FP4 정밀도 지원 기능을 갖춰 고급 AI 모델의 실행 속도를 높이고 효율성을 증가시키죠. AI 애호가, 게이머, 크리에이터, 개발자들에게 놀라운 경험을 선사합니다.

NVIDIA는 지난 CES 전시회에서 AI 개발자와 애호가들이 이러한 기능을 활용할 수 있도록 RTX용 NVIDIA NIM과 AI Blueprint를 공개했습니다. NVIDIA NIM 마이크로서비스는 사전 패키지 생성형 AI 모델입니다. 이는 개발자와 애호가들이 생성형 AI를 쉽게 시작하고, 빠르게 반복하며, RTX의 성능을 활용해 윈도우(Windows) PC에서 AI를 가속화할 수 있도록 합니다. NVIDIA AI Blueprint는 개발자들에게 NIM 마이크로서비스를 사용해 차세대 AI 경험을 구축하는 방법을 보여주는 참조 프로젝트입니다.

NIM과 AI Blueprint는 GeForce RTX 50 시리즈 GPU에 최적화돼 있습니다. 이 두 가지 기술은 원활하게 연동돼, 개발자와 애호가들이 AI PC에서 최첨단 AI 경험을 구축, 반복, 제공할 수 있도록 지원합니다.

PC에서 생성형 AI 가속화하는 NVIDIA NIM

AI 모델 개발이 빠르게 발전하고 있지만, 이러한 혁신을 PC에 적용하는 것은 많은 사람들에게 여전히 어려운 과제입니다. 허깅페이스(Hugging Face)와 같은 플랫폼에 게시된 모델은 PC에서 실행하기 위해 선별, 조정, 정량화돼야 하죠. 또한, 기존 도구와의 호환성을 보장하기 위해 새로운 AI 애플리케이션 프로그래밍 인터페이스(application programming interface, API)에 통합돼야 합니다. 그리고 최고의 성능을 발휘할 수 있도록 최적화된 추론 백엔드로 변환돼야 합니다.

RTX AI PC와 워크스테이션을 위한 NVIDIA NIM 마이크로서비스는 커뮤니티 기반과 NVIDIA가 개발한 AI 모델에 대한 접근을 제공해, 이러한 과정의 복잡성을 완화할 수 있습니다. 이 마이크로서비스는 업계 표준 API를 통해 쉽게 다운로드하고 연결할 수 있으며, AI PC에 필수적인 주요 양식을 포괄합니다. 나아가 다양한 AI 도구와 호환되며, PC, 데이터센터, 클라우드 등 어디에서나 유연한 배포 옵션을 제공합니다.

NIM 마이크로서비스에는 RTX GPU가 탑재된 PC에서 최적화된 모델을 실행하는 데 필요한 모든 것이 있습니다. 특정 GPU용 사전 구축 엔진, NVIDIA TensorRT 소프트웨어 개발 키트(SDK), Tensor 코어를 사용한 가속 추론용 오픈 소스 NVIDIA TensorRT-LLM 라이브러리 등을 포함합니다.

마이크로소프트(Microsoft)와 NVIDIA는 리눅스용 윈도우 서브시스템(Windows Subsystem for Linux, WSL2)에서 RTX용 NIM 마이크로서비스와 AI Blueprint를 활성화하기 위해 협력했습니다. WSL2를 사용하면 데이터센터 GPU에서 실행되는 것과 동일한 AI 컨테이너를 RTX PC에서 효율적으로 실행할 수 있죠. 이 덕분에 개발자는 플랫폼 전반에 걸쳐 보다 쉽게 AI 모델을 구축, 테스트, 배포할 수 있습니다.

추가적으로 NIM과 AI Blueprint는 5세대 Tensor 코어와 FP4 정밀도 지원 등 GeForce RTX 50 시리즈의 기반이 되는 Blackwell 아키텍처의 주요 혁신을 활용합니다.

차세대 AI 성능을 이끄는 Tensor 코어

AI 계산은 매우 까다롭고 막대한 처리 능력을 필요로 하죠. 이미지나 비디오 생성, 언어 이해, 실시간 의사 결정 등 AI 모델은 매초마다 수백 조의 수학적 연산을 수행해야 합니다. 그리고 이를 따라잡기 위해서 컴퓨터는 AI 전용으로 제작된 특수 하드웨어가 필요합니다.

지난 2018년 NVIDIA GeForce RTX GPU는 이러한 집중적인 워크로드를 처리하도록 설계된 전용 AI 프로세서인 Tensor 코어를 도입함으로써 게임의 판도를 바꿨습니다. 기존의 컴퓨팅 코어와 달리, Tensor 코어는 더욱 빠르고 효율적으로 계산을 수행함으로써 AI를 가속화하도록 설계됐죠. 이 혁신적인 기술 덕분에 AI 기반 게임, 창작 도구, 생산성 애플리케이션이 주류로 자리 잡을 수 있었습니다.

Blackwell 아키텍처는 AI 가속을 한 차원 더 발전시킵니다. Blackwell GPU의 5세대 Tensor 코어는 최대 3,352 AI TOPS를 제공해 더욱 까다로운 AI 작업을 처리하고 동시에 여러 AI 모델을 실행할 수 있습니다. 즉, 실시간 렌더링에서 지능형 어시스턴트에 이르기까지 더 빠른 AI 기반 경험을 제공해 게이밍, 콘텐츠 제작과 그 밖의 분야에서 더 큰 혁신을 이룰 수 있는 길을 열어줍니다.

FP4 – 더 작은 모델에서 더 큰 성능을 실현하다

AI 성능을 최적화하는 또 다른 방법은 양자화입니다. 양자화는 모델 크기를 줄여 모델이 더 빠르게 실행되도록 하며, 메모리 요구 사항을 줄이는 기술입니다.

여기서 FP4가 등장합니다. AI 모델이 출력 품질을 저하시키지 않으면서 더 빠르고 경량으로 실행될 수 있도록 해주는 고급 양자화 포맷입니다. FP16에 비해 모델 크기를 최대 60%까지 줄일 수 있고, 성능은 2배 이상 향상시키면서 성능 저하를 최소화할 수 있습니다.

예를 들어, 블랙 포레스트 랩스(Black Forest Labs)의 플럭스.1(FLUX.1) [dev] 모델은 FP16에서 23GB 이상의 VRAM을 필요로 합니다. 즉, GeForce RTX 4090과 전문가용 GPU에서만 지원될 수 있죠. 반면 FP4를 사용하면 플럭스.1 [dev]는 10GB 미만의 VRAM만 필요로 해, 더 많은 GeForce RTX GPU에서 로컬로 실행할 수 있습니다.

FP16를 사용하는 GeForce RTX 4090에서 플럭스.1 [dev] 모델은 30단계로 이미지를 생성하는 데 15초가 소요됩니다. 그러나 FP4를 사용하는 GeForce RTX 5090의 경우, 약 5초만에 이미지를 생성할 수 있죠.

FP4는 Blackwell 아키텍처에 기본적으로 지원돼, 로컬 PC에 고성능 AI를 배포하는 것이 그 어느 때보다 쉬워졌습니다. 또한, NIM 마이크로서비스에 통합돼 이전에는 양자화가 어려웠던 모델을 효과적으로 최적화합니다. FP4는 보다 효율적인 AI 처리를 가능하게 함으로써 콘텐츠 제작을 위한 더 빠르고 스마트한 AI 경험을 제공합니다.

AI Blueprint, RTX PC에서 고급 AI 워크플로우 지원

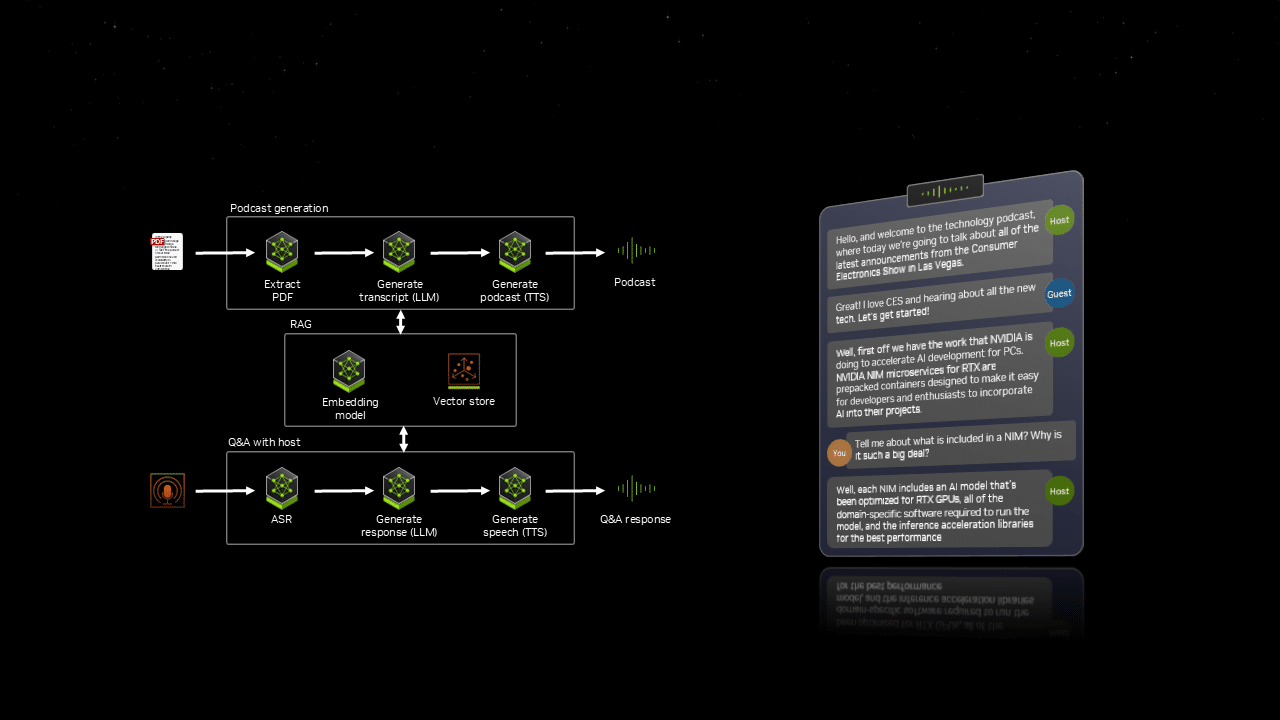

NIM 마이크로서비스에 기반한 NVIDIA AI Blueprint는 사전 패키지화되고, 최적화된 참조 구현을 제공합니다. 이를 통해 디지털 휴먼, 팟캐스트 생성기 또는 애플리케이션 어시스턴트 등 고급 AI 기반 프로젝트를 보다 쉽게 개발할 수 있도록 해줍니다.

지난 달 CES에서 NVIDIA는 사용자가 PDF를 재미있는 팟캐스트로 변환하고, 이후 AI 팟캐스트 호스트와의 Q&A를 만들 수 있는 블루프린트인 PDF to Podcast를 시연했습니다. 이 워크플로우는 모두 동기화된 7가지 다른 AI 모델을 통합해, 역동적이고 상호 작용적인 경험을 제공합니다.

AI Blueprint를 사용하면, RTX PC와 워크스테이션에서 AI를 실험하는 것에서 개발하는 단계로 빠르게 넘어갈 수 있습니다.

RTX PC와 워크스테이션에 곧 탑재될 NIM과 AI Blueprint

생성형 AI는 게이밍, 콘텐츠 제작 등 다양한 분야에서 가능성의 한계를 넓혀가고 있습니다. NIM 마이크로서비스와 AI Blueprint를 사용하면 최신 AI의 발전은 더 이상 클라우드에만 국한되지 않습니다. RTX PC에도 최적화되죠. RTX GPU를 사용하면 개발자와 애호가들은 PC와 워크스테이션에서 바로 AI를 실험하고 구축하고 배포할 수 있습니다.

NIM 마이크로서비스와 AI Blueprint는 곧 출시될 예정입니다. GeForce RTX 50 시리즈, GeForce RTX 4090과 4080, NVIDIA RTX 6000과 5000 전문가용 GPU에 대한 초기 하드웨어 지원이 함께 제공될 예정이며, 향후 추가 GPU도 지원될 계획입니다.