생성형 AI는 디지털 휴먼부터 작문 도우미, 지능형 에이전트, 크리에이티 도구에 이르기까지 PC 소프트웨어를 혁신적인 경험으로 재탄생시키고 있습니다.

NVIDIA RTX AI PC는 Windows 11의 효율적인 성능을 통해 생성형 AI 실험을 간소화하고 이러한 변환을 주도하고 있는데요,

NVIDIA TensorRT는 RTX AI PC용으로 재구성되어 8배 작아진 패키지에 업계 최고 수준의 TensorRT 성능과 디바이스 즉시 엔진 기능을 결합하여 1억 대 이상의 RTX AI PC에 AI를 원활히 배포합니다.

Microsoft Build에서 발표한 RTX용 TensorRT는 새로운 추론 스택으로 앱 개발자에게 광범위한 하드웨어 호환성과 최첨단 성능을 제공하며 Windows ML로 기본 지원됩니다.

NVIDIA 소프트웨어 개발 키트(SDK)는 손쉬운 통합형 AI 기능을 필요로 하는 개발자에게 NVIDIA DLSS에서부터 NVIDIA RTX Video 멀티미디어 개선 사항에 이르는 다양한 옵션을 제공합니다. 이번 달에는 RTX AI 기능 및 가속화 활성화를 위해 Autodesk, Bilibili, Chaos, LM Studio, Topaz Labs 등의 주요 소프트웨어 애플리케이션 업데이트를 발표합니다.

AI 애호가와 개발자는 AnythingLLM, Microsoft VS Code, ComfyUI와 같은 인기 앱에서 최적화 및 실행 가능화된 사전 패키지형 AI 모델 NVIDIA NIM를 통해 손쉽게 AI를 시작할 수 있습니다. 이번 주에 출시되는 FLUX.1-schnell 이미지 생성 모델은 NIM 마이크로서비스로 제공될 예정이며, 인기 서비스인 FLUX.1-dev NIM 마이크로서비스 또한 더 광범위한 RTX GPU 지원을 위해 새롭게 업데이트되었습니다.

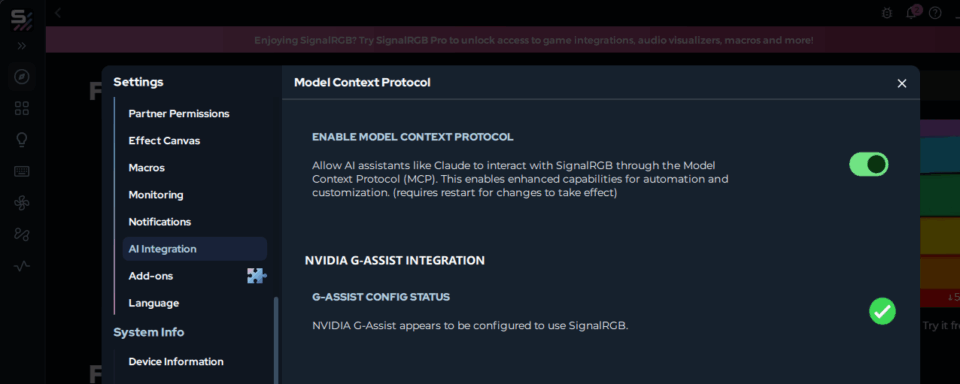

간단한 노코드 AI 개발을 찾고 있는 사용자는 NVIDIA App의 RTX PC AI 어시스턴트인 Project G-Assist를 활용하여 자연어 AI로 PC 앱과 주변 장치를 제어하는 플러그인을 구축할 수 있습니다. 이제 Google Gemini 웹 검색, Spotify, Twitch, IFTTT, SignalRGB를 포함한 새로운 커뮤니티에도 플러그인을 제공합니다.

RTX용 TensorRT로 가속화된 AI 추론

개발자는 현재 AI PC 소프트웨어 스택 사용 시 성능을 절충하거나 특정 하드웨어에 맞춰 투자를 최적화해야합니다.

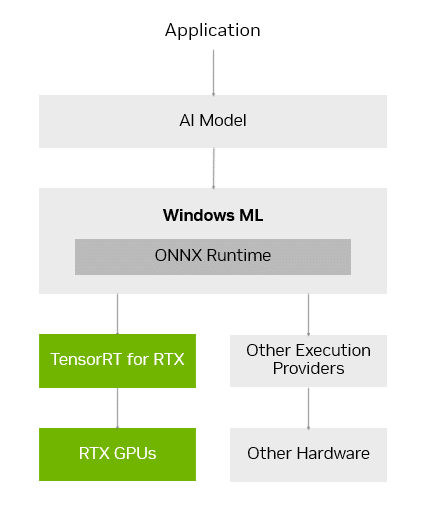

Windows ML은 이러한 문제를 해결하기 위해 구축되었는데요, Windows ML은 ONNX 런타임을 기반으로, 각 하드웨어 제조업체가 제공 및 유지 관리하는 최적화된 AI 실행 레이어와 원활하게 연동됩니다.

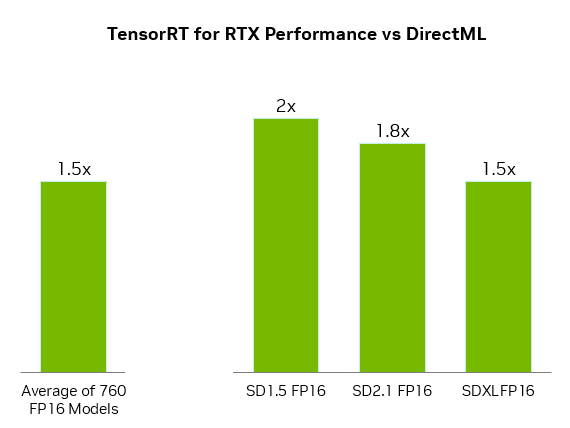

특히 GeForce RTX GPU의 경우 Windows ML가 자동으로 RTX용 TensorRT를 사용하여 고성능을 보장하고 빠른 배포를 수행하는데요, DirectML와 비교했을 때 TensorRT는 PC AI 워크로드 성능을 50% 이상 향상시킵니다.

Windows ML은 또한 개발자에게 다양한 편의 기능을 제공합니다. 각 AI 기능에 적합한 GPU, CPU, NPU 등의 하드웨어를 자동으로 선택하고, 해당 하드웨어의 실행 제공자를 다운로드하기 때문에 앱에 해당 파일을 포함시킬 필요가 없습니다. 이를 통해 준비가 되는 즉시 실시간으로 사용자에게 최신 TensorRT 성능을 제공합니다.

기존 데이터센터용으로 구축된 TensorRT가 RTX AI PC용으로 재설계되었습니다. RTX용 TensorRT는 TensorRT 엔진을 사전 생성하여 앱으로 패키징하는 방식 대신, 사용자의 특정 RTX GPU에 맞춰 AI 모델 실행 방식을 최적화하는 온디바이스 실시간 엔진 구축 기술을 채택하여 단 몇 초만에 최적화를 완료합니다. 또한 라이브러리 패키지가 간소화되어 파일 크기가 8배 감소하였습니다.

RTX용 TensorRT는 현재 Windows ML 미리보기 버전으로 개발자에게 제공되고 있으며, 6월에 NVIDIA Developer에서 독립 실행형 SDK로 제공될 예정입니다.

개발자는 RTX용 TensorRT 출시 블로그 또는 Microsoft의 Windows ML 블로그에서 자세한 내용을 확인할 수 있습니다.

Windows 11 PC의 AI 생태 확장

개발자는 다양한 NVIDIA SDK를 활용하여 AI 기능을 추가하거나 앱 성능을 향상할 수 있습니다. 여기에는 GPU 가속화용 NVIDIA CUDA와 TensorRT, 3D 그래픽용 NVIDIA DLSS 및 Optix, 멀티미디어용 NVIDIA RTX Video와 Maxine, 생성형 AI용 NVIDIA Riva와 ACE가 포함됩니다.

이번 달 출시되는 주요 애플리케이션 업데이트를 통해 다음의 NVIDIA SDK 기능이 활성화될 예정입니다:

- LM Studio 앱에 최신 CUDA 버전의 업그레이드를 적용하면 성능이 30% 이상 향상됩니다.

- Topaz Labs는 비디오 품질을 향상을 위해 CUDA 가속화를 적용한 생성형 AI 비디오 모델을 출시합니다.

- Chaos Enscape와 Autodesk VRED는 DLSS 4를 추가하여 더 빠른 성능과 더 나은 이미지 화질을 보장합니다.

- BiliBili는 가상 배경 등의 NVIDIA Broadcast 기능을 통합하여 라이브 스트림의 품질을 향상하고 있습니다.

NVIDIA는 Windows ML 및 TensorRT 통합을 통해 Microsoft 및 최고 AI 앱 개발자와 지속적으로 협력하여 RTX 기반 머신에서 AI 기능을 가속화할 수 있기를 기대합니다.

NIM 마이크로서비스와 AI Blueprint 기반 로컬 AI로 사용 편의성 향

PC로 AI 개발을 시작하는 일은 어렵게 느껴질 수 있습니다. AI 개발자 및 애호가들은 120만 개 이상의 Hugging Face AI 모델 중 하나를 선택한 후 PC 실행 가능성이 높은 형식으로 양자화하고, 실행에 필요한 모든 종속 파일을 찾아 설치하는 등의 작업을 수행해야 합니다.

NVIDIA NIM은 RTX GPU에서 최고 성능 달성을 위해 AI 모델 실행에 필요한 모든 파일을 사전 패키지화하고 최적화된 목록을 제공하기 때문에 손쉽게 개발을 시작할 수 있는데요, 또한 컨테이너화되어 있어 전체 PC 또는 클라우드에서 동일 NIM 마이크로서비스를 원활하게 실행할 수 있습니다.

이 NVIDIA NIM 마이크로서비스는 build.nvidia.com에서 다운로드하거나 Anything LLM, ComfyUI 및 Visual Studio Code용 AI Toolkit과 같은 AI 앱을 통해 다운로드할 수 있습니다.

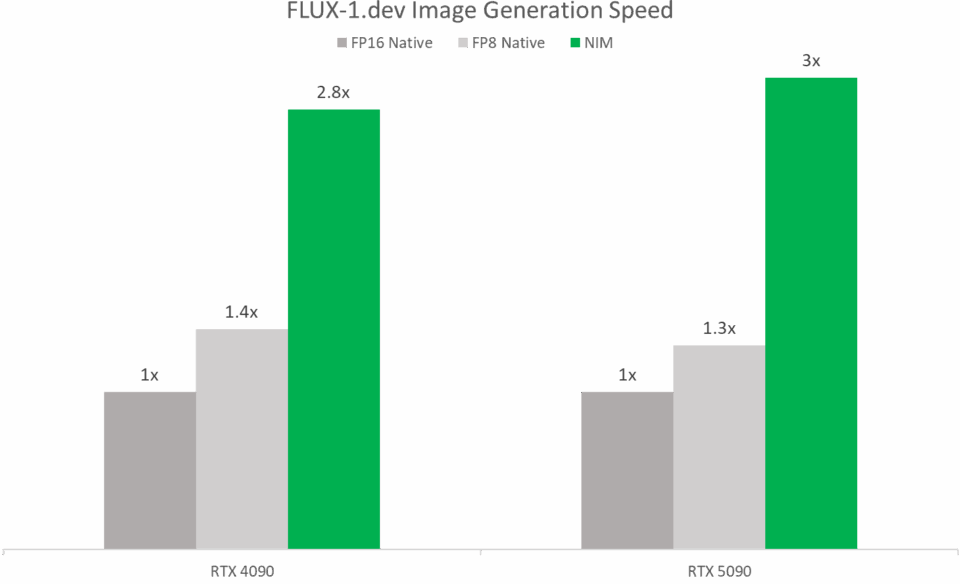

COMPUTEX에서 NVIDIA는 Black Forest Labs의 초고속 이미지 생성 모델인 FLUX.1-schnell NIM 마이크로서비스를 출시하고 다양한 GeForce RTX 40 및 50 시리즈 GPU 호환성을 추가하는 FLUX.1-dev NIM 마이크로서비스 업데이트를 진행할 예정인데요, 이러한 NIM 마이크로서비스는 TensorRT와 양자화된 모델로 처리 속도를 향상시킵니다. FP4 및 RTX를 최적화를 통해 NVIDIA Blackwell GPU의 속도가 기존 대비 두 배 이상 빨라지죠.

AI 개발자는 NVIDIA AI Blueprint를 적용하여 NIM 마이크로서비스로 샘플 워크플로우 및 프로젝트를 실행할 수 있습니다.

지난 달 NVIDIA는 3D 형식 참조를 기반으로 생성된 이미지를 구성하고 카메라 각도를 제어하는 강력한 3D 가이드 생성형 AI용 NVIDIA AI Blueprint를 출시했습니다. 개발자는 필요에 따라 오픈 소스 블루프린트를 수정하거나 추가 기능을 확장할 수 있습니다.

현재 새로운 Project G-Assist 플러그인과 샘플 프로젝트를 이용하실 수 있습니다

NVIDIA는 최근 NVIDIA App 통합형 AI 어시스턴트 Project G-Assist를 출시했습니다. 사용자는 G-Assist를 통해 간단한 음성 및 텍스트 명령으로 GeForce RTX 시스템을 제어할 수 있으며, 다수의 레거시 제어판 분산 관리 대비 간편한 인터페이스를 이용할 수 있습니다.

개발자는 Project G-Assist를 사용하여 플러그인을 제작하거나 어시스턴트 사용 사례를 테스트한 후, NVIDIA Discord 및 GitHub을 통해 게시할 수 있습니다.

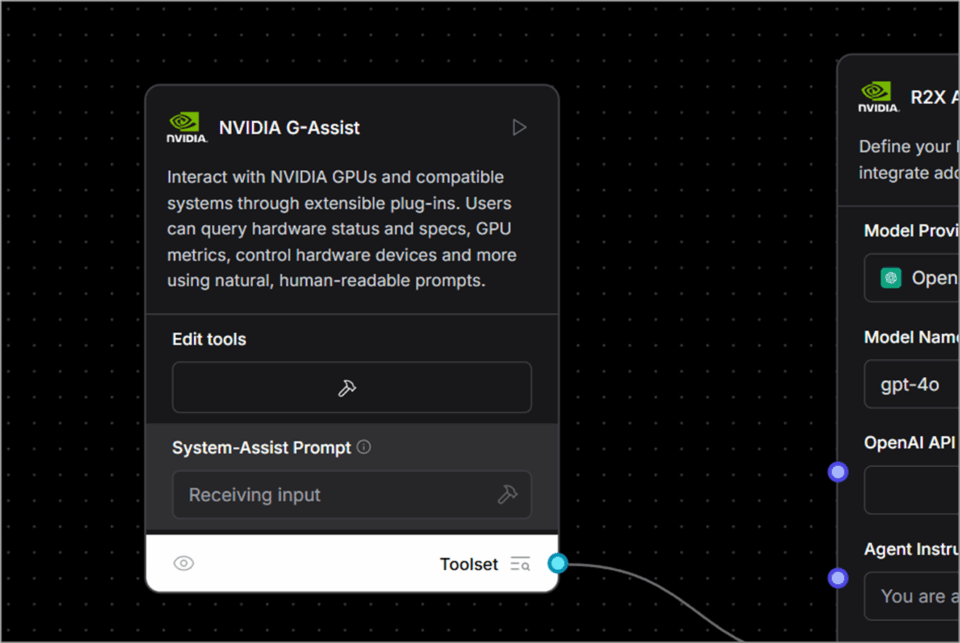

자연어 명령을 기반을 노코드 및 로우 코드 개발이 가능한 ChatGPT 기반 앱 Project G-Assist 플러그인 빌더를 통해 더욱 손쉽게 플러그인 제작을 시작할 수 있습니다. 이 가벼운 커뮤니티 애드온은 간단한 JSON 정의와 Python 로직을 사용합니다.

이제 GitHub에서 이용 가능한 새로운 오픈 소스 플러그인 샘플은 온디바이스 AI가 PC 및 게임 워크플로우를 개선하는 다양한 방법을 제시합니다. 여기에는 다음이 포함됩니다:

- Gemini: Google의 클라우드 기반 무료 대규모 언어 모델을 사용하는 기존 Gemini 플러그인에 실시간 웹 검색 기능을 추가하습니다.

- IFTTT: 사용자가 호환 가능한 수백 개의 엔드포인트를 자동화하여 실내 조명, 스마트 색조를 조정하고, 모바일 장치에 최신 게임 뉴스를 푸시하도록 지원하는 IoT 루틴 트리거 플러그인입니다.

- Discord: 사용자가 게임 플레이의 흐름을 끊지 않은 채 게임 하이라이트나 메시지를 Discord 서버로 직접 공유할 수 있도록 지원하는 플러그인입니다.

GitHub 리포지토리에서 Spotify를 통한 핸즈프리 음악 제어, Twitch를 통한 라이브 스트림 상태 확인 등의 다양한 예시를 확인해보세요.

많은 기업에서 인공지능(AI)을 새로운 PC 인터페이스로 채택하고 있습니다. 일례로, SignalRGB는 제조업체의 통합 조명 제어를 지원하는 G-Assist 플러그인을 개발하고 있습니다. 사용자는 곧 SignalRGB 앱에서 해당 플러그인을 직접 설치할 수 있을 것입니다.

이번 주부터 AI 커뮤니티는 Langflow에서 G-Assist를 맞춤형 구성 요소로 활용할 수 있습니다. 사용자는 이 기능을 로코드 또는 노코드 워크플로우, AI 애플리케이션, 에이전트 플로우에 함수 호출 기능으로 통합할 수 있습니다.

Project G-Assist 플러그인을 개발하고 실험하는 데 관심이 있는 애호가들은 NVIDIA 개발자 Discord 채널에 가입 및 협업하고 창작물을 공유하며 지원을 받을 수 있습니다.

매주 RTX AI Garage는 NIM 마이크로서비스 및 AI Blueprint에 대해 자세히 알아보고 AI PC와 워크플로우 스테이션에서 AI 에이전트, 크리에이티브 워크플로우, 디지털 휴먼, 생산성 앱 등을 구축하기를 원하는 사람들을 위해 커뮤니티 기반 AI 혁신과 콘텐츠를 제공합니다.

Facebook, Instagram, TikTok, X에서 NVIDIA AI PC와 연결하고 RTX AI PC 뉴스레터를 구독하여 최신 정보를 받아보세요.

LinkedIn과 X에서 NVIDIA 워크플로우 스테이션을 팔로우하세요.

소프트웨어 제품 정보는 공지를 참조해 주세요.