최신 워크플로우는 PC 환경에서 생성형 AI와 에이전틱 AI(agentic AI)의 무한한 가능성을 보여줍니다.

대표적인 활용 사례로는 제품 지원 문의를 처리하기 위한 챗봇 조정이나, 개인 일정을 관리하는 개인 비서 개발 등이 있죠. 하지만 소형 언어 모델(SLM)은 전문적인 에이전틱 작업에서 높은 정확도로 일관되게 수행하는 데 여전히 어려움을 겪고 있습니다.

이때 필요한 것이 바로 파인튜닝입니다.

Unsloth는 세계에서 가장 널리 사용되는 거대 언어 모델(LLM) 파인튜닝을 위한 오픈소스 프레임워크 중 하나로, 모델을 손쉽게 조정할 수 있는 방법을 제공합니다. Unsloth는 NVIDIA GPU 메모리 사용을 최소화한 효율적인 훈련에 최적화됐으며, GeForce RTX 데스크톱과 노트북부터 RTX PRO 워크스테이션, 세계에서 가장 작은 AI 슈퍼컴퓨터인 DGX Spark에 이르기까지 다양한 NVIDIA GPU 환경에서 활용할 수 있습니다.

NVIDIA는 파인튜닝을 위한 또 다른 핵심 기반으로 NVIDIA Nemotron 3 제품군을 공개했습니다. 제품군에는 오픈 모델, 데이터, 라이브러리가 포함됩니다. Nemotron 3은 탁월한 에이전틱 AI 파인튜닝을 지원하며, 가장 효율적인 오픈 모델 제품군을 제공합니다.

AI에 새로운 역량을 학습시키기

파인튜닝은 AI 모델에 집중적인 훈련 세션을 제공하는 것과 같습니다. 모델은 특정 주제, 워크플로우와 연관된 예시를 통해 새로운 패턴을 학습하고, 주어진 작업에 적응함으로써 정확도를 향상시킵니다.

모델의 파인튜닝 방식은 개발자가 기존 모델을 어느 수준까지 조정할지에 따라 달라지는데요. 개발자는 목표에 따라 다음 세 가지 주요 파인튜닝 방식 중 하나를 선택할 수 있습니다.

파라미터 효율적 파인튜닝(LoRA, QLoRA):

- 작동 방식: 모델의 일부만 업데이트해 더 빠르고 저비용으로 훈련을 수행합니다. 모델을 크게 변경하지 않고도 성능을 개선할 수 있는 효율적인 방식입니다.

- 적용 사례: 도메인 지식 추가, 코딩 정확도 향상, 법률과학 작업용 모델 적응, 추론 정교화, 어조·행동 일치 등 기존의 완전 파인튜닝이 적용되던 거의 모든 상황에서 활용 가능합니다.

- 요구 사항: 소규모, 중규모 데이터세트(100~1,000개의 프롬프트-샘플 쌍)

완전 파인튜닝:

- 작동 방식: 모델의 모든 매개변수를 업데이트하는 방식으로, 특정 형식이나 스타일을 따르도록 모델을 훈련하는 데 유용합니다.

- 적용 사례: 특정 주제에 대한 지원을 제공하고, 정해진 가드레일 세트를 유지하며, 특정 방식으로 응답해야 하는 AI 에이전트와 챗봇 개발과 같은 고급 사용 사례에서 활용 가능합니다.

- 요구 사항: 대규모 데이터세트(1,000개 이상의 프롬프트-샘플 쌍)

강화 학습:

- 작동 방식: 피드백 또는 선호도 신호를 사용해 모델의 행동을 조정합니다. 모델은 환경과 상호작용하며 학습하고, 피드백을 통해 시간이 지남에 따라 스스로 성능을 개선합니다. 훈련과 추론이 결합된 복잡한 고급 기술로, 파라미터 효율적 파인튜닝과 완전 파인튜닝 방식과 병행해서 사용할 수 있습니다. 자세한 내용은 Unsloth의 강화 학습 가이드(Reinforcement Learning Guide)에서 확인할 수 있습니다.

- 적용 사례: 법률, 의학 같은 특정 분야의 모델 정확도를 향상시키거나, 사용자를 대신해 행동을 조정할 수 있는 자율 에이전트 구축에 활용 가능합니다.

- 요구 사항: 행동 모델, 보상 모델, 환경 등 모델이 학습할 수 있는 프로세스

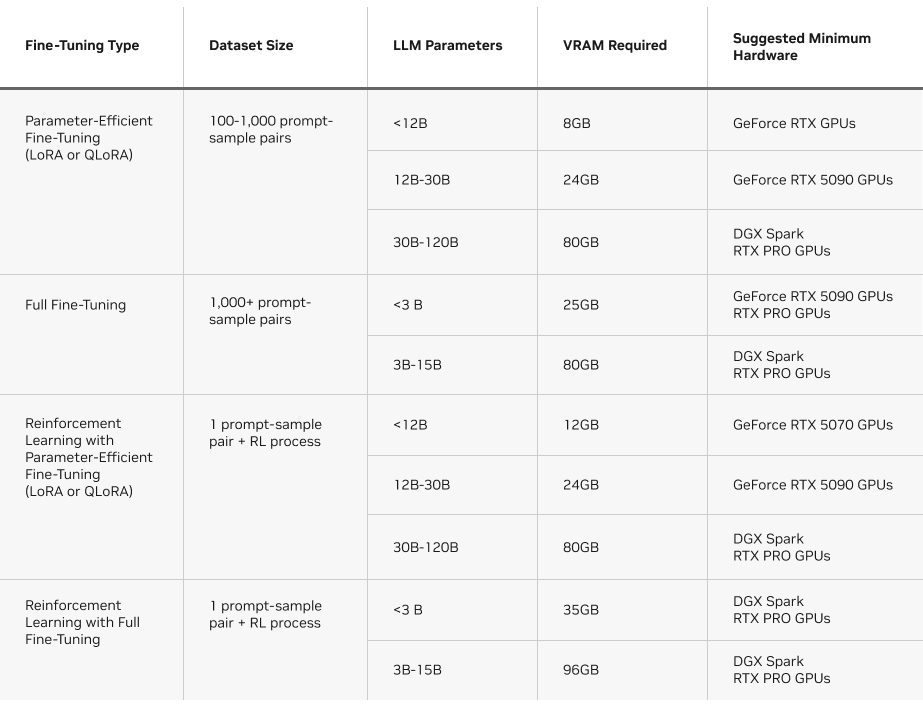

추가로 파인튜닝 방식에 필요한 VRAM 사양도 고려해야 합니다. 아래 표는 Unsloth에서 각 유형의 파인튜닝 방식을 실행하는 데 필요한 요구 사항을 정리한 것입니다.

Unsloth, NVIDIA GPU에서 파인튜닝 가속화

LLM 파인튜닝은 메모리와 연산 집약적인 작업으로, 훈련 단계마다 모델 가중치를 업데이트하기 위해 수십억 개의 행렬 곱셈을 수행해야 합니다. NVIDIA GPU의 강력한 성능은 이러한 고도의 병렬 워크로드를 신속하고 효율적으로 처리하기 위해 필수적입니다.

Unsloth는 이러한 워크로드에서 강점을 발휘하며, 복잡한 수학적 연산을 효율적인 맞춤형 GPU 커널로 변환해 AI 훈련을 가속화합니다.

Unsloth는 NVIDIA GPU 환경에서 Hugging Face 트랜스포머 라이브러리(transformers library)의 성능을 최대 2.5배 향상시킵니다. 이러한 GPU 전용 최적화와 Unsloth의 사용 편의성은 더 많은 AI 연구자와 개발자 커뮤니티가 파인튜닝을 쉽게 활용할 수 있도록 지원합니다.

이 프레임워크는 GeForce RTX 노트북, RTX PRO 워크스테이션, DGX Spark를 포함한 NVIDIA 하드웨어에 맞춰 설계되고 최적화돼, VRAM 사용량을 줄이면서도 최고 수준의 성능을 제공합니다.

Unsloth는 다양한 LLM 구성, 하이퍼파라미터(hyperparameters), 옵션의 시작 방법과 관리 방법에 대한 유용한 가이드를 제공하며, 예제 문서와 단계별 워크플로우도 함께 제공합니다.

아래에서 Unsloth 가이드에 대한 자세한 내용을 확인해 보세요.

NVIDIA DGX Spark에서 Unsloth를 설치하는 방법에 관해 알아보고, NVIDIA 기술 블로그에서 NVIDIA Blackwell 플랫폼의 파인튜닝과 강화 학습에 대한 자세한 내용을 읽어보세요.

Matthew Berman이 NVIDIA GeForce RTX 5090에서 Unsloth를 활용해 강화 학습 기반 로컬 파인튜닝을 직접 실행하는 과정을 확인해 보세요.

NVIDIA Nemotron 3 오픈 모델 제품군 공개

NVIDIA가 새롭게 공개한 Nemotron 3 오픈 모델 제품군은 Nano, Super, Ultra 세 가지 모델로 구성되며, 신규 하이브리드 전문가 혼합 방식(Mixture-of-Experts, MoE) 아키텍처 기반으로 설계됐습니다. Nemotron 3 제품군은 업계 선도적인 정확도와 효율성을 갖춘 오픈 모델 제품군으로, 에이전틱 AI 애플리케이션 구축에 이상적이죠.

Nemotron 3 Nano 30B-A3B는 현재 출시된 라인업 중 가장 컴퓨팅 효율이 높은 모델인데요. 소프트웨어 디버깅, 콘텐츠 요약, AI 어시스턴트 워크플로우, 낮은 추론 비용의 정보 검색 등의 작업에 최적화됐습니다. 하이브리드 MoE 설계는 다음과 같은 성능을 제공합니다.

- 추론 토큰 최대 60% 감소해 추론 비용 크게 절감

- 100만 토큰 컨텍스트 윈도우 지원으로, 장시간다단계 작업에서도 훨씬 더 많은 정보 유지 가능

Nemotron 3 Super는 멀티 에이전트 애플리케이션을 위한 고정밀 추론 모델이며, Nemotron 3 Ultra는 복잡한 AI 애플리케이션을 위한 모델입니다. 두 모델은 모두 2026년 상반기에 출시될 예정입니다.

또한 NVIDIA는 개방형 훈련 데이터세트 모음과 최첨단 강화 학습 라이브러리를 출시했는데요. Nemotron 3 Nano 파인튜닝은 Unsloth를 통해 이용할 수 있습니다.

지금 Hugging Face에서 Nemotron 3 Nano를 다운로드하거나, 라마.cpp(Llama.cpp)와 LM 스튜디오(LM Studio)를 통해서 실험해 보세요.

DGX Spark, 컴팩트한 AI 파워하우스

DGX Spark는 로컬 파인튜닝을 지원하며, 컴팩트한 데스크톱 슈퍼컴퓨터로 놀라운 AI 성능을 제공합니다. 개발자들은 일반 PC보다 더 많은 메모리를 활용할 수 있죠.

NVIDIA Grace Blackwell 아키텍처를 기반으로 구축된 DGX Spark는 최대 1페타플롭(FP4) AI 성능을 제공하며, 통합 CPU-GPU의 128GB 메모리를 통해 개발자가 더 큰 모델, 긴 컨텍스트 윈도우와 까다로운 훈련 워크로드를 로컬에서 실행할 수 있는 충분한 여유 공간을 제공합니다.

DGX Spark는 다음과 같은 파인튜닝 성능을 제공합니다.

- 큰 모델 크기. 300억 개 이상의 파라미터를 가진 모델은 소비자용 GPU의 VRAM 용량을 초과하는 경우가 많지만, DGX Spark의 통합 메모리에는 여유롭게 수용됩니다.

- 고급 기술. 더 많은 메모리와 높은 처리량을 요구하는 완전 파인튜닝과 강화 학습 기반 워크플로우가 DGX Spark에서 훨씬 빠르게 실행됩니다.

- 클라우드 대기 없는 로컬 제어. 개발자는 클라우드 인스턴스를 기다리거나 여러 환경을 관리할 필요 없이, 연산 집약적 작업을 로컬에서 실행할 수 있습니다.

DGX Spark의 강점은 LLM에만 국한되지 않는데요. 예를 들어, 고해상도 확산 모델은 일반 데스크톱이 제공하는 메모리 용량을 넘어서는 경우가 많습니다. FP4 지원과 대용량 통합 메모리를 갖춘 DGX Spark는 단 몇 초 만에 1천 개의 이미지를 생성할 수 있으며, 창의적 또는 멀티 모달 파이프라인에서도 더 높은 처리량을 유지할 수 있죠.

아래 표는 DGX Spark의 라마(Llama) 제품군 파인튜닝 성능을 보여줍니다.

파인튜닝 워크플로우가 발전함에 따라, 새로운 Nemotron 3 오픈 모델 제품군은 RTX 시스템과 DGX Spark에 최적화된 확장 가능한 추론과 긴 컨텍스트 성능을 제공합니다.

DGX Spark의 고강도 AI 작업 처리에 대해 더 자세히 알아보세요.

#ICYMI – NVIDIA RTX AI PC의 새로운 진전

🚀 NVIDIA RTX GPU에 최적화된 FLUX.2 이미지 생성 모델 출시

블랙 포레스트 랩스(Black Forest Labs)의 신형 모델은 FP8 양자화 방식으로 VRAM을 절감하고 성능을 40% 향상시킵니다.

✨ 넥사AI, 에이전트 검색용 하이퍼링크로 RTX PC의 로컬 AI 확장

신규 온디바이스 검색 에이전트는 검색 증강 생성 인덱싱 속도를 3배, LLM 추론 속도를 2배 향상시켜 1GB 용량의 밀집 폴더 인덱싱 시간을 약 15분에서 4~5분으로 단축합니다. 또한 딥시크(DeepSeek) OCR이 넥사SDK(NexaSDK)를 통해 GGUF에서 로컬 실행되며, RTX GPU에서 차트, 수식, 다국어 PDF의 플러그-앤-플레이(plug-and-play) 파싱을 제공합니다.

🤝 NVIDIA GPU, 미스트랄 AI 최적화 신규 모델 제품군 공개

새로운 미스트랄 3(Mistral 3) 모델은 클라우드부터 엣지까지 최적화됐으며, 올라마(Ollama)와 라마.cpp를 통해 빠른 로컬 실험을 지원합니다.

🎨 블렌더 5.0, HDR 컬러와 주요 성능 향상으로 출시

이번 출시에는 ACES 2.0 광색역과 HDR 컬러, 헤어와 털 렌더링 속도를 최대 5배 향상시키는 NVIDIA DLSS, 대규모 지오메트리 처리 개선, 그리즈 펜슬(Grease Pencil)용 모션 블러 기능이 추가됐습니다.

페이스북(Facebook), 인스타그램(Instagram), 틱톡(TikTok), X에서 NVIDIA AI PC에 연결하고 RTX AI PC 뉴스레터를 구독해 최신 소식을 받아볼 수 있습니다. 링크드인(LinkedIn)과 X에서 NVIDIA Workstation을 팔로우하세요.

소프트웨어 제품 정보에 관한 공지를 확인하세요.