AI 분야의 혁신에 함께하고 싶다면 트랜스포머(transformer)에 주목하세요.

여기서 말하는 트랜스포머는 TV 위의 변신 로봇 장난감이나 전신주에 달린 쓰레기통 크기의 통을 의미하는 것은 아닙니다.

트랜스포머 모델이란?

트랜스포머 모델은 문장 속 단어와 같은 순차 데이터 내의 관계를 추적해 맥락과 의미를 학습하는 신경망입니다.

어텐션(attention) 또는 셀프어텐션(self-attention)이라 불리며 진화를 거듭하는 수학적 기법을 응용해 서로 떨어져 있는 데이터 요소들의 의미가 관계에 따라 미묘하게 달라지는 부분까지 감지해내죠.

구글(Google)의 2017년 논문에 처음 등장한 트랜스포머는 지금까지 개발된 모델 중 가장 새롭고 강력합니다. ‘트랜스포머 AI’라 불리기도 하는 머신 러닝계의 혁신을 주도하고 있죠.

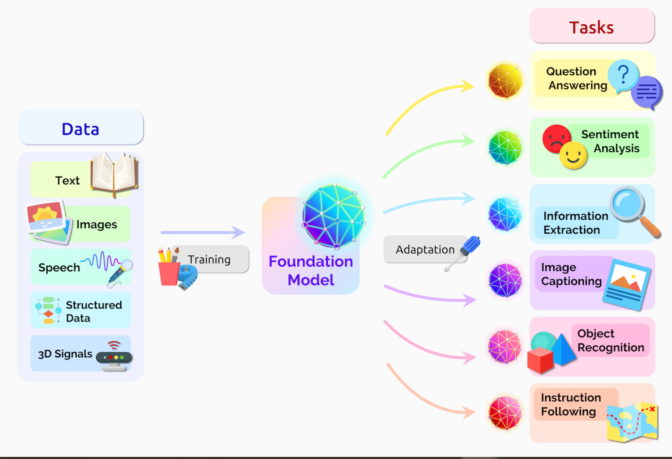

스탠퍼드대학교 연구진은 2021년 8월에 발표한 논문에서 트랜스포머를 “파운데이션 모델(foundation model)”로 일컬은 바 있습니다. 이 모델들이 AI의 패러다임 변화를 견인하고 있다고 봤기 때문인데요. “지난 몇 년 사이 등장한 파운데이션 모델의 놀라운 규모와 범위는 우리가 가능하다고 상상하는 것들의 범주를 넓혀왔다”고 평가했습니다.

트랜스포머 모델의 기능은?

트랜스포머는 텍스트와 음성을 거의 실시간으로 옮겨 청각 장애인 등 다양한 청중의 회의와 강의 참여를 지원합니다.

DNA의 유전자 사슬과 단백질의 아미노산에 대한 이해를 도와 신약 디자인을 가속하기도 하죠.

트랜스포머는 트렌드와 이상 징후를 감지해 부정 방지, 제조 간소화, 온라인 추천, 헬스케어 개선 등에 기여합니다.

우리가 구글이나 마이크로소프트 빙(Microsoft Bing)에서 검색할 때에도 트랜스포머를 사용합니다.

트랜스포머 AI의 선순환

순차적 텍스트나 이미지, 비디오 데이터를 사용하는 애플리케이션은 무엇이든 트랜스포머 모델이 될 수 있습니다.

이는 트랜스포머 AI의 선순환으로 이어집니다. 대규모 데이터세트로 구축된 트랜스포머들은 정확한 예측을 통해 자신들의 보다 효과적인 쓰임새를 찾아내고, 이에 힘입어 더 많이 생성한 데이터로 더 나은 모델을 구축할 수 있게 됩니다.

NVIDIA 창립자 겸 CEO 젠슨 황(Jensen Huang)도 GTC 2022 키노트에서 트랜스포머가 “자기지도(self-supervised) 학습을 가능하게 하고, AI가 초고속으로 움직이게 만듭니다”라고 평가한 바 있습니다.

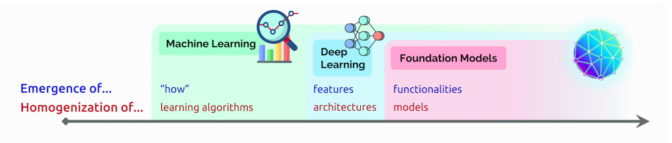

CNN과 RNN을 대체하는 트랜스포머

불과 5년 전까지도 가장 인기 있는 딥 러닝 모델로 손꼽혔던 합성곱과 순환 신경망(CNN과 RNN)을 이제는 트랜스포머가 대체하고 있습니다.

실제로 지난 2년간 아카이브(arXiv)에 게재된 AI 관련 논문의 70%에 트랜스포머가 등장합니다. 2017년 전기전자학회(IEEE) 논문에 패턴 인식 분야의 최고 인기 모델로 RNN과 CNN이 보고됐다는 사실을 감안하면 이는 아주 전위적인 변화인 셈입니다.

라벨링은 없애고 성능은 높이고

트랜스포머의 등장 전까지는 라벨링된 대규모 데이터 세트로 신경망을 훈련해야 했는데요. 이런 데이터 세트들은 구축에 많은 시간과 비용이 소요되죠. 트랜스포머는 요소들 사이의 패턴을 수학적으로 찾아내기 때문에 이 과정이 필요 없습니다. 그 덕분에 수조 개의 이미지와 페타바이트(petabytes)급 텍스트 데이터를 웹과 기업 데이터베이스에서 사용할 수 있게 됩니다.

이에 더해 트랜스포머가 사용하는 연산은 병렬 프로세싱에 적합하기 때문에 모델의 실행 속도 또한 빨라집니다.

현재 트랜스포머는 2019년에 언어 처리 시스템용으로 개발된 벤치마크인 수퍼글루(SuperGLUE) 등의 유명 성능 리더보드들을 압도하고 있습니다.

트랜스포머와 어텐션

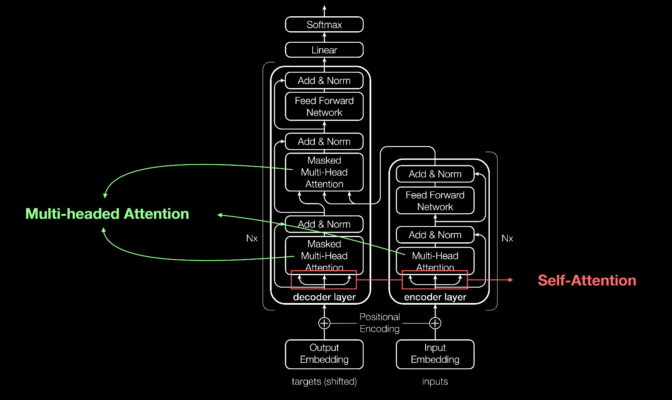

신경망 대부분이 그렇듯 트랜스포머 모델도 기본적으로는 데이터를 처리하는 대형 인코더/디코더 블록에 해당합니다.

이 블록에 작지만 전략적인 요소들을 추가해(하단 그림 참고) 트랜스포머를 더욱 특별하게 개선할 수 있습니다.

트랜스포머는 네트워크에 송수신되는 데이터 요소에 위치 인코더로 태그를 지정합니다. 이 태그를 따라 어텐션 유닛이 데이터 요소 간의 관계를 보여주는 일종의 대수 지도(algebraic map)를 계산하죠.

어텐션 쿼리는 멀티헤드 어텐션(multi-headed attention)이라 불리는 방정식들의 행렬을 계산해 대개 병렬로 실행됩니다.

이러한 도구들을 활용해 컴퓨터는 인간의 눈에 비치는 패턴을 똑같이 볼 수 있게 됩니다.

의미를 찾는 셀프어텐션

문장을 예로 들어 살펴보겠습니다.

그녀는 주전자의 물을 컵에 따랐다. 그것이 가득 찰 때까지.

여기서 ‘그것’이 컵을 의미한다는 사실을 우리는 쉽게 알 수 있습니다. 그럼 다음의 문장을 보죠.

그녀는 주전자의 물을 컵에 따랐다. 그것이 텅 빌 때까지.

여기서 ‘그것’은 물론 주전자를 의미하겠죠.

구글 브레인(Google Brain)의 수석 연구원으로 앞서 소개한 2017년 논문의 연구를 이끈 아시시 바스와니(Ashish Vaswani)에 따르면 “의미는 사물 간 관계의 결과이고, 셀프어텐션은 관계를 배우는 일반적 방법”입니다.

그는 “기계 번역은 단어 사이의 가깝고 먼 관계들을 파악해야 하는 셀프어텐션의 확립에 좋은 수단이 되어줬습니다”며, “이제 셀프어텐션은 강력하고 유연한 학습의 도구로 완전히 자리매김했습니다”라고 덧붙였습니다.

트랜스포머라는 이름을 갖기까지

어텐션이 트랜스포머의 핵심이다 보니 구글 연구진은 자신들의 2017년 모델명에 그 용어를 거의 그대로 쓸 뻔했습니다.

2011년에 신경망 연구를 처음 시작한 바스와니는 “어텐션 넷(Attention Net)이라는 이름이 그리 끌리지 않았습니다”고 말합니다.

같은 팀의 수석 소프트웨어 엔지니어인 야코프 우스츠코라이트(Jakob Uszkoreit)가 트랜스포머라는 이름을 생각해냈습니다.

바스와니는 “나는 우리가 데이터의 리프레젠테이션(representation)을 바꾸는 트랜스포머라고 주장했습니다. 의미상 그렇다는 얘기였습니다”라고 말합니다.

트랜스포머의 탄생

신경정보처리시스템학회(NeurIPS)의 2017년 컨퍼런스에 발표된 이 논문에서 구글 팀은 자신들이 개발한 트랜스포머가 기계 번역에서 기록한 정확도를 함께 공개했습니다.

해당 모델의 경우 다양한 기법과 더불어 8개의 NVIDIA GPU를 활용해 3.5일만에 훈련을 완료했습니다. 기존 모델과 비교하면 정말 미미한 수준의 시간과 비용을 들인 셈이죠. 이 모델은 최대 10억 개의 단어쌍으로 구성된 데이터 세트에서 훈련했습니다.

2017년 당시 구글 인턴으로 이 연구에 참여한 에이단 고메즈는 “논문을 제출하기까지 3개월간 전력으로 질주했습니다”고 회상합니다.

“논문 제출을 앞둔 밤, 아시시와 나는 구글에서 밤을 샜습니다. 조그만 회의실에서 두어 시간 정도 눈을 붙이기로 했습니다. 일찍 출근한 직원이 벌컥 열어젖힌 문에 머리를 맞는 바람에 잠에서 깼는데, 논문 제출 마감 직전이었습니다”

이 모닝콜은 위대한 혁신의 시작을 알리는 모닝콜이기도 했죠.

“그날 밤에 아시시가 이런 얘기를 했습니다. 트랜스포머는 대형 사건이 될 테고, 게임의 판도를 완전히 바꿔놓을 거라고 말입니다. 나는 그렇게까지 확신하지는 못했습니다. 벤치마크에서 괜찮은 결과를 얻을 것 정도로만 생각했습니다. 하지만 결국 아시시의 말이 옳았습니다” 고메즈는 현재 트랜스포머 기반 언어 처리 서비스를 제공하는 스타트업 코히어(Cohere)의 CEO입니다.

머신 러닝계의 중대 사건

바스와니는 페이스북(Facebook) 팀이 CNN으로 진행한 유사 연구 결과를 트랜스포머가 능가하던 당시의 흥분을 지금도 기억합니다.

“이것이 머신 러닝계의 일대 사건이 되리라는 것을 알 수 있었습니다”

1년 뒤에는 또다른 구글팀이 트랜스포머로 텍스트 시퀀스의 포워드와 백워드 처리를 시도했습니다. 이를 통해 단어들 간의 관계를 더 많이 포착하고, 문장의 의미를 이해하는 모델의 능력을 개선했습니다.

이들이 개발한 BERT(Bidirectional Encoder Representations from Transformers) 모델은 11개의 신기록을 세웠고, 구글 검색 알고리즘에 포함됐습니다.

전세계 연구자들은 언어와 산업 전반의 활용 사례에 앞다퉈 BERT 모델을 도입하기 시작했습니다. 20년간 머신 러닝을 연구한 베테랑 앤더스 아프테그(Anders Arpteg)에 따르면 “텍스트는 기업이 보유하고 있는 가장 일반적인 데이터 유형의 하나이기 때문”입니다.