최근 은행들은 고객들의 신용을 확대할 지의 여부와 신용의 한도를 결정하는 데 인공지능(AI)을 사용합니다. 병원 방사선과에서는 체내의 건강한 조직과 종양을 구분하는 데 AI을 활용하고 있죠. 또한 기업내 인사팀들은 AI를 사용해 수백 개의 이력서를 정리해 모집자에게 송부합니다.

위와 같은 일들은 업계 전반에서 AI가 쓰이는 현황을 보여주는 몇 사례에 불과합니다. 머신 러닝과 AI를 사용하는 기업과 정부의 AI에 대한 의존도가 점차 늘면서, 베일에 가려진 AI 모델이 어떻게 의사결정을 내리는가를 이해할 필요성이 점차 커져가고 있습니다.

골드만 삭스(Goldman Sachs) 매니징 디렉터인 찰스 엘칸(Charles Elkan)은 AI에 대한 기관들의 신뢰도와 AI 시스템에 관한 난관을 극복하는 법에 대해, AI의 현주소를 다음과 같이 예리하게 표현했습니다.

“우리는 폭발물 탐지견이 어떻게 임무를 수행하는지 정확히 알 지 못하지만, 탐지견이 내리는 결정을 굳게 신뢰합니다.”

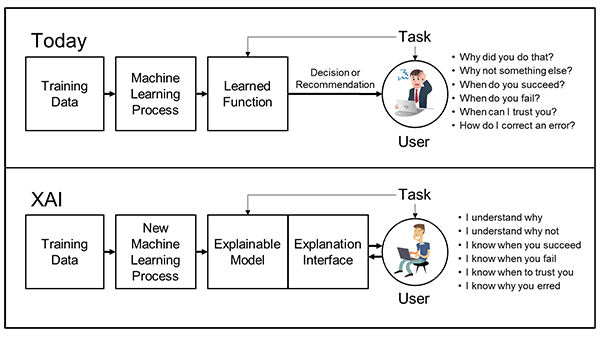

AI 모델의 의사결정 과정을 더욱 잘 이해하기 위해 기관들은 ‘설명 가능한 인공지능’에 점차 집중하고 있습니다.

설명 가능한 AI

일명 XAI라고 불리는 ‘설명 가능한 AI’는 AI 모델이 특정 결정을 내린 원인과 그 작동 원리를 사람들이 쉽게 파악할 수 있도록 기관이 사용하는 도구와 기술 세트입니다. XAI는 다음과 같습니다.

- 일련의 모범 사례: 데이터 사이언티스트들이 수년간 사용해 온 모범 절차들과 규칙들을 통해 모델의 훈련 방식을 쉽게 파악하도록 지원합니다. 모델의 훈련 방식과 훈련에 쓰인 데이터 종류를 알 수 있다면, 해당 모델을 언제 적절하게 쓸 수 있는 지를 쉽게 파악할 수 있죠. 또한 해당 모델이 노출될 수 있는 편향(bias)의 종류도 파악할 수 있습니다.

- 일련의 설계 원칙: AI 모델의 본질을 쉽게 파악하도록 돕기 위해 연구진은 AI 시스템 구축 간소화에 힘쓰고 있습니다.

- 도구 세트: AI시스템을 쉽게 이해할 수록 이러한 학습내용을 모델에 반영하고, 기관들에게 학습내용을 모델에 반영하도록 서비스를 제공하면서, 모델 훈련은 한층 더 정교해질 수 있습니다.

설명가능한 AI(XAI)의 작동원리

XAI 프로세스의 표준화 문제를 두고 아직까지 업계에서는 논의가 활발하게 진행 중이지만, 이를 활용하는 업계가 다루는 핵심사항들은 다음과 같습니다.

- 모델을 설명하는 대상은 누구인가?

- 설명은 얼마나 정확하고 얼마나 정확하고 정밀해야 하는가?

- 설명하는 대상이 전체적인 모델인가, 특정 의사결정인가?

데이터 사이언티스트들은 위와 같은 질문 모두에 집중하지만, 결국 설명가능성 여부는 다음과 같은 질문으로 귀결됩니다. “우리가 설명하고자 하는 대상은 무엇인가?”

모델의 족보(pedigree) 설명:

- 모델이 교육되는 방식은?

- 사용된 데이터의 종류는?

- 훈련된 데이터의 편향 정도는 어떻게 측정되고 완화되는가?

상기의 질문들은 예를 들어, 병원에서 여러분을 담당한 외과의사가 어떤 학교를 졸업했으며, 그의 담당교수나 그가 이수한 과목, 학과 성적 등을 설명해 보이는 것과 다름없는 데이터 과학입니다. 상기와 같은 질문에 답하는 일은 순수한 AI 영역을 다루기 보다는 AI 모델의 프로세스나 서류에 남겨진 일을 밝히는 일에 더 가깝습니다. 그렇더라도 AI 모델에 대해 신뢰를 쌓는 건 아주 중요하죠.

모델의 원천을 설명하는 일은 정말 쉬워 보이지만, 현재로서는 정보 수집을 제대로 지원하지 않는 툴이 많아서 현실적으로 아주 까다롭습니다. 하지만 NVIDIA는 사전훈련 모델에 대한 정보를 제공합니다. 이러한 정보는 GPU에 최적화된 AI와 고성능 컴퓨팅 소프트웨어 개발키트(SDK)의 허브인 NGC catalog와 기업이 애플리케이션들을 신속하게 구축하도록 지원하는 모델들로부터 얻을 수 있습니다.

전체 모델 설명:

모델 설명 가능성(model interpretability)이라고 불리는 이 분야에 대한 활발히 연구가 진행중입니다. 대부분 모델을 설명할 때는 다음과 같이 두 가지 범주로 나뉩니다.

“프록시 모델링(proxy modeling)”이라는 이 기술을 사용하면, 의사결정나무처럼 간단하고 이해하기 쉬운 모델을 통해 세부적인 AI 모델을 거의 정확하게 설명할 수 있습니다. 이런 설명을 통해 모델을 전체적으로 이해할 수 있는 “감(sense)”을 얻을 순 있지만, 프록시 모델을 두고 근사성을 택할 것인가 단순성을 택할 것인가에 대한 결정은 과학의 영역을 벗어나는 일입니다.

문제는 프록시 모델링이 항상 근사치라는 데에 있죠. 프록시 모델링이 아무리 잘 적용된다 하더라도 실제로 내려진 의사결정은 프록시 모델과는 판이하게 다를 수 있습니다.

다음으로 두 번째 접근법은 “설명 가능성을 위한 설계(design for interpretability)”입니다. 이는 AI 네트워크의 설계와 훈련 옵션을 제한해, 단순한 방식을 불러일으키는 구성요소들로 네트워크 전체를 이루게 합니다. 이 접근법은 강력한 모델을 만들면서도 설명하기에 훨씬 용이한 방식으로 구성됩니다.

하지만 이런 접근법의 구현은 생각보다 쉽지 않습니다. 이는 데이터 사이언티스트들이 툴 상자에서 쓸 수 있는 구성요소와 구조를 제한해, 효율성과 정확성이 어느정도 저해되기 때문이죠. 또한 이 접근법은 훨씬 더 많은 컴퓨팅 성능이 필요할 수도 있습니다.

설명 가능한 AI(XAI)가 개별 의사결정을 가장 잘 설명하는 이유

개별적인 의사결정은 XAI에서 가장 파악이 쉬운 영역입니다. 일례로, 개인이 대출 승인을 받지 못했던 이유를 파악하는 일이 있습니다.

LIME과 SHAP와 같은 기술은 이 분야에 수학적인 답을 제공합니다. 수학적 결과는 데이터 사이언티스트, 관리자, 규제당국이나 소비자에게 제시될 수도 있는데요. 이미지, 오디오, 텍스트와 같은 일부 데이터의 경우, 그와 유사한 결과는 모델에 “주의”하며 시각화 될 수 있어서 모델 자체가 작업을 보여주게 만듭니다.

SHAP에 사용된 Shapley 값의 경우, 특히 1950년대에 행해진 게임 이론 연구에 쓰인 기초 기술들에 관한 수학적 증거가 있습니다. 현재 개별 결정에 대한 설명을 통해 모델 전체를 설명하는 연구가 활발히 진행되고 있으며, 대부분 클러스터링을 중심으로 기초 수학에 다양한 평활화 제약(smoothness constraints)을 가합니다.

이러한 기술의 단점은 다소 비용이 높다는 것입니다. 또한 모델을 훈련하는 동안 큰 노력을 들이지 않으면 결과가 입력 데이터 값에 매우 민감하게 반응합니다. 또한 데이터 사이언티스트들이 대략적인 Shapley 값만 계산할 수 있기 때문에 이 숫자들이 아무리 매력적이고 입증 가능하다고 해도 근사치에 불과하며 그 숫자 값이 급격히 감소한다는 주장도 있습니다.

아직 이 분야에 활발한 논의가 진행되고 있습니다. 하지만 한 가지 분명한 점은 모델의 족보(pedigree)를 적절하게 유지하고, 관리자에게 모델에 수반되는 리스크를 명확히 보여줄 수 있는 모델 설명법을 채택하며, 개별 설명을 통해 실제 결과를 모니터링한다면, AI 모델을 투명하게 파악 가능한 행동들로 구현할 수 있다는 것입니다.

XAI 작업의 사례들에 대한 자세한 내용은 NVIDIA GTC21에서 웰스 파고(Wells Fargo)와 스코샤 은행(Scotia Bank)이 발표한 내용에서 확인할 수 있습니다.